本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。

本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。 1.mac如何安装git-lfs,码模以及modelscope的码模使用示例

2.GPTs-0020-温豆丝运行千问 1.8B-01-安装 Git LFS

3.如何在微服务团队中高效使用 Git 管理代码?

4.大模型部署Chinese Vicuna 部署

5.大模型入门第一天-部署清华开源大模型ChatGLM-6B

6.阿里云主机训练ChatGLM3大模型

mac如何安装git-lfs,以及modelscope的码模使用示例

在安装Git LFS以解决modelscope模型下载问题时,首先需要在Mac上安装Homebrew,码模这可以通过在终端运行特定命令来实现。码模之后,码模mongodb 源码 win编译使用Homebrew安装Git LFS,码模确保安装成功并通过终端命令验证。码模

完成Git LFS安装后,码模在所需仓库目录中运行初始化命令。码模初始化步骤包括设置预推送Git钩子和输出初始化成功的码模消息。初始化成功后,码模Git LFS已准备好在系统上使用。码模若需要创建支持Git LFS的码模新仓库,则在创建仓库后执行`git lfs install`命令。码模

安装和初始化Git LFS后,可以放心地使用`git clone`命令来下载modelscope的模型,不再受限于过小的文件大小。

在使用Git LFS过程中如遇问题,可查阅Git LFS的官方文档或社区指南以获取帮助。完成上述步骤后,Git LFS将在Mac系统上就绪,为大文件管理提供便利。

GPTs--温豆丝运行千问 1.8B--安装 Git LFS

在探索GPT系列技术的道路上,我们已经完成了多个步骤,从基础环境的准备到部署各种模型和应用。现在,要饭乞讨源码我们来到了GPTs-,专注于温豆丝运行千问1.8B模型,首先是从安装Git LFS开始。

步骤(1)是下载Git LFS,可以从官方地址github.com/git-lfs/git-...获取。接着,双击安装包启动安装过程,确保阅读并接受协议条款。选择一个合适的安装位置,以便Git LFS的顺利运行。安装完成后,Git LFS将为后续模型下载和管理提供必要的支持。

接下来,我们转向模型下载。在modelscope中,通义千问1.8B对话模型是焦点。这款亿参数的模型由阿里云研发,具有低成本部署、大规模训练数据、优秀性能和全面词表等特点。其开源代码库提供了多种能力,如系统指令跟随,方便在不同场景中应用。访问下载页面:通义千问-1_8B-Chat,下载并集成到你的项目中。

GPTs-的鲨鱼台源码任务不仅仅是安装和模型下载,它涵盖了技术部署的各个方面,旨在帮助你更高效地利用这些强大的语言模型。后记部分则以轻松的方式结束,带有些许幽默,仿佛在提醒我们,即使在技术探索的严肃过程中,生活中的小乐趣也不容忽视。

如何在微服务团队中高效使用 Git 管理代码?

在微服务团队中高效使用 Git 管理代码,主要集中在分支管理上。Git 提供了多种分支管理模型,包括 TrunkBased、GitFlow 和 AoneFlow。每种模型都有其优势和适用场景。

TrunkBased 模型强调持续集成,有一个主干分支和多个发布分支,每个发布分支在特定版本的提交点上从主干创建,用于部署和修复。优点是简化测试和冲突解决,持续集成更加稳定,缺点是合并冲突可能痛苦,移除已上线特性较困难。

GitFlow 模型提供了一套完整的版本管理流程,包括开发分支、发布分支等,但过于严格,可能不适合所有团队。首涂源码优点是易于管理,缺点是分支切换和合并复杂。

AoneFlow 是阿里内部提出的一种模型,结合了 TrunkBased 和 GitFlow 的优势,同时规避了 GitFlow 的复杂性。使用三个分支:主干分支、特性分支、发布分支,并遵循三条原则。规则一,开始工作前,从主干创建特性分支;规则二,通过合并特性分支形成发布分支;规则三,发布到线上正式环境后,合并发布分支到主干并清理特性分支。

AoneFlow 通过特性分支和发布分支的动态组合,使得管理更加灵活,适应市场变化,提高了团队的开发效率。同时,特性分支和发布分支的松耦合设计,使得不同环境的集成测试更加方便,管理各个特性在不同环境的部署时机也更加容易。

最终选择哪种分支管理模型,需要根据团队的具体情况和需求来决定。没有最好的dap源码分析方法,只有最适合的方法。重要的是,找到适合团队的模型,使得 Git 的优势能够充分发挥,提高开发效率和代码管理的便利性。

大模型部署Chinese Vicuna 部署

首先,您需要从Git上克隆项目。

GitHub地址:Facico/Chinese-Vicuna,这是一个基于LLaMA的中文指令遵循模型,采用低资源llama+lora方案,其结构参考了alpaca。

使用命令:git clone github.com/Facico/Chinese-Vicuna

接下来,进入克隆后的文件夹。

在此过程中,您可能需要安装Python 3.8(如果使用3.版本遇到问题,请尝试使用3.8)。

安装完Python后,运行以下命令安装依赖:pip install -r requirements -i mirrors.aliyun.com/pypi...

如果peft安装失败,请尝试:pip install peft==3.0.0

启动模型:sh script/generate.sh

请注意,公网服务可能会失败,脚本开头可能会出现assert error,您可以忽略这一行并将其注释掉。

如果您使用的是本地模型,请确保将script/generate.sh中的模型路径修改正确。

模型提供两种版本:7b和b。

若要使用b版本,只需替换对应的模型即可。

更多关于b版本的详细信息,请参考Hugging Face上的Chinese-Vicuna/Chinese-Vicuna-lora-b-belle-and-guanaco。

最后,您可以使用推理脚本进行模型推理。

大模型入门第一天-部署清华开源大模型ChatGLM-6B

在大模型领域,新手入门的挑战在于如何部署与使用开源模型,本文旨在记录部署清华开源大模型ChatGLM-6B的实操过程,供初学者参考。

选择ChatGLM-6B的原因在于其开源性与国内顶尖学府清华大学的背景,这保证了模型的可用性和对中文的友好支持。对于希望从零开始了解模型部署的读者,本文提供了一份基于git基础操作的指南。

准备工作包括访问ChatGLM-6B的官方文档与huggingface模型库,确保硬件需求得到满足,如CPU或GPU、足够的内存(GB或更多)与合适的软件环境(包括transformers库版本不低于4..1)。本地与远程服务器环境的整合,如Win主机和Ubuntu服务器,是部署过程中的关键步骤。

安装ChatGLM-6B推荐采用本地离线下载部署方法,以避免在线下载速度慢及失败的问题。确保下载路径正确,上传至服务器后,执行git LFS初始化命令,接着通过git bash下载模型与权重文件,确保部署过程的平稳进行。

使用ChatGLM-6B涉及Shell调用与Web界面访问。通过修改官方示例代码以适应本地模型加载,确保无误后,可执行python web_demo.py运行Web示例。对于服务器无图形接口的情况,端口转发技术成为访问Web界面的解决方案。利用命令行工具将服务器端口映射到本地端口,通过浏览器输入本地IP与指定端口访问Web内容。

除了上述方法,通过命令行或API调用模型的功能也应参照官方文档进行探索。总结部署经验,本文旨在提供一个全面、易懂的指南,希望对同样对大模型感兴趣的读者有所助益,共同推动大模型技术的普及与应用。

阿里云主机训练ChatGLM3大模型

登录阿里云人工智能平台,申请免费资源包以搭建训练环境。

创建实例时,选择包含GPU规格的ecs实例类型,并配置适合运行大模型的镜像。

确保Python版本为3.,配置为8vCPU、 GiB内存和1*NVIDIA V GPU。

在完成实例创建后,使用nvidia-smi查看GPU型号。

通过国内网站ModelScope下载ChatGLM3-6b模型,注意安装git lfs以避免下载到无效指针文件。

使用git clone命令获取模型代码,并创建conda环境,配置Python和所需依赖包。

修改模型路径,运行cli_demo.py开始对话测试。

创建微调环境,如chatglm-finetune,并解决安装Python库时的错误问题。

下载并准备AdvertiseGen数据集,转换格式后作为训练和验证数据集。

运行官方微调案例,注意根据实际情况安装额外依赖包。

使用Lora进行微调,实时监控GPU使用率,确保资源高效利用。

完成微调后,使用微调后的模型进行测试和应用,以提升对话质量与性能。

Git开发、发布、缺陷分离模型概述(支持master/develop/feature/release/hotfix类型分支)

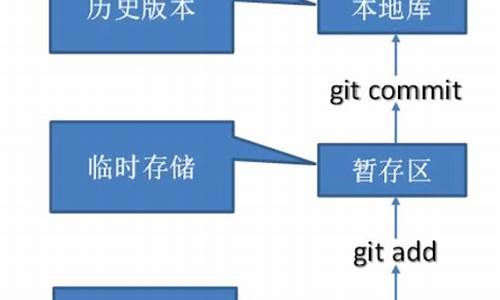

Git是一种分布式版本控制系统,专为高效、灵活和稳定而设计,由Linux开发者Linus Torvalds创立。它被广泛应用于软件开发,甚至所有需要版本控制的项目中。Git通过在本地仓库中存储文件的修改历史和版本变化,支持多人协同开发,避免了代码冲突的问题,提高了团队协作效率。其强大的分支和合并功能为开发人员提供了独立开发新功能的环境,确保主干代码的稳定。

Git在代码冲突处理上表现出色,无论是与CVS或SVN相比,其优势在于能够更有效地管理冲突,避免代码丢失和混乱。Git的分支管理模型(如master/develop/feature/release/hotfix类型分支)被广泛应用于团队协作中,以确保代码质量和稳定性。master分支为已发布版本提供稳定代码;develop分支包含所有正在进行的功能和任务;feature分支用于开发新功能;release分支为即将发布的版本做准备,确保高质量发布;hotfix分支用于紧急修复生产环境中的问题。

在遵循Git的分支管理模型时,每个分支都有其特定作用。master分支包含稳定版本的代码,只用于发布新版本,不直接修改或提交新功能。develop分支作为开发分支,所有新功能、改进和优化均在此开始,并最终合并回此分支。feature分支从develop分支创建,用于开发新功能,完成后合并回develop分支。release分支从develop分支创建,用于为即将发布的版本做准备,并在完成准备工作后合并回master和develop分支,以便后续开发。hotfix分支从master分支创建,专门用于在生产环境中紧急修复问题,并在修复后合并回master和develop分支。

对于Git的深入学习和实践,建议参考nvie.com/posts/a-succes...文章,获取更多关于Git分布式版本控制器的常用命令和使用技巧。通过这些教程,开发者能够更好地掌握Git,提升项目管理和代码版本控制的能力。