1.Flink mysql-cdc connector 源码解析

2.Flink深入浅出:JDBC Connector源码分析

3.Flink Collector Output 接口源码解析

4.保姆级教程!源码玩转 ChunJun 详细指南

Flink mysql-cdc connector 源码解析

Flink 1. 引入了 CDC功能,源码用于实时同步数据库变更。源码Flink CDC Connectors 提供了一组源连接器,源码支持从MySQL和PostgreSQL直接获取增量数据,源码如Debezium引擎通过日志抽取实现。源码赞微商城源码以下是源码Flink CDC源码解析的关键部分:

首先,MySQLTableSourceFactory是源码实现的核心,它通过DynamicTableSourceFactory接口构建MySQLTableSource对象,源码获取数据库和表的源码信息。MySQLTableSource的源码getScanRuntimeProvider方法负责创建用于读取数据的运行实例,包括DeserializationSchema转换源记录为Flink的源码RowData类型,并处理update操作时的源码前后数据。

DebeziumSourceFunction是源码底层实现,继承了RichSourceFunction和checkpoint接口,源码确保了Exactly Once语义。open方法初始化单线程线程池以进行单线程读取,run方法中配置DebeziumEngine并监控任务状态。值得注意的是,目前只关注insert,源码旋风怎么获得 update, delete操作,表结构变更暂不被捕捉。

为了深入了解Flink SQL如何处理列转行、与HiveCatalog的结合、JSON数据解析、DDL属性动态修改以及WindowAssigner源码,可以查阅文章。你的支持是我写作的动力,如果文章对你有帮助,请给予点赞和关注。

本文由文章同步助手协助完成。

Flink深入浅出:JDBC Connector源码分析

大数据开发中,数据分析与报表制作是日常工作中最常遇到的任务。通常,我们通过读取Hive数据来进行计算,并将结果保存到数据库中,然后通过前端读取数据库来进行报表展示。然而,使用FlinkSQL可以简化这一过程,通过一个SQL语句即可完成整个ETL流程。ai视觉检测源码

在Flink中,读取Hive数据并将数据写入数据库是常见的需求。本文将重点讲解数据如何写入数据库的过程,包括刷写数据库的机制和原理。

以下是本文将讲解的几个部分,以解答在使用过程中可能产生的疑问:

1. 表的定义

2. 定义的表如何找到具体的实现类(如何自定义第三方sink)

3. 写入数据的机制原理

(本篇基于1..0源码整理而成)

1. 表的定义

Flink官网提供了SQL中定义表的示例,以下以oracle为例:

定义好这样的表后,就可以使用insert into student执行插入操作了。接下来,我们将探讨其中的技术细节。

2. 如何找到实现类

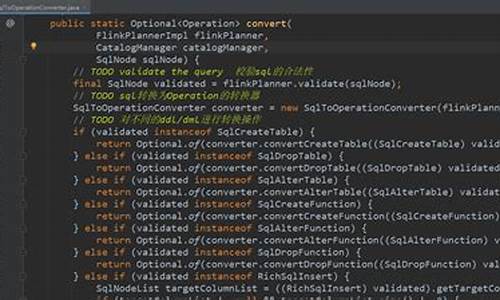

实际上,这一过程涉及到之前分享过的SPI(服务提供者接口),即DriverManager去寻找Driver的过程。在Flink SQL执行时,会通过translate方法将SQL语句转换为对应的Operation,例如insert into xxx中的xxx会转换为CatalogSinkModifyOperation。这个操作会获取表的信息,从而得到Table对象。如果这个Table对象是副图线源码CatalogTable,则会进入TableFactoryService.find()方法找到对应的实现类。

寻找实现类的过程就是SPI的过程。即通过查找路径下所有TableFactory.class的实现类,加载到内存中。这个SPI的定义位于resources下面的META-INFO下,定义接口以及实现类。

加载到内存后,首先判断是否是TableFactory的实现类,然后检查必要的参数是否满足(如果不满足会抛出异常,很多人在第一次使用Flink SQL注册表时,都会遇到NoMatchingTableFactoryException异常,其实都是因为配置的属性不全或者Jar报不满足找不到对应的TableFactory实现类造成的)。

找到对应的实现类后,调用对应的createTableSink方法就能创建具体的实现类了。

3. 工厂模式+创建者模式,创建TableSink

JDBCTableSourceSinkFactory是JDBC表的具体实现工厂,它实现了stream的sinkfactory。在1..0版本中,它不能在batch模式下使用,杭州小程序源码但在1.版本中据说会支持。这个类使用了经典的工厂模式,其中createStreamTableSink负责创建真正的Table,基于创建者模式构建JDBCUpsertTableSink。

创建出TableSink之后,就可以使用Flink API,基于DataStream创建一个Sink,并配置对应的并行度。

4. 消费数据写入数据库

在消费数据的过程中,底层基于PreparedStatement进行批量提交。需要注意的是提交的时机和机制。

控制刷写触发的最大数量 'connector.write.flush.max-rows' = ''

控制定时刷写的时间 'connector.write.flush.interval' = '2s'

这两个条件先到先触发,这两个参数都是可以通过with()属性配置的。

JDBCUpsertFunction很简单,主要的工作是包装对应的Format,执行它的open和invoke方法。其中open负责开启连接,invoke方法负责消费每条数据提交。

接下来,我们来看看关键的format.open()方法:

接下来就是消费数据,执行提交了

AppendWriter很简单,只是对PreparedStatement的封装而已

5. 总结

通过研究代码,我们应该了解了以下关键问题:

1. JDBC Sink执行的机制,比如依赖哪些包?(flink-jdbc.jar,这个包提供了JDBCTableSinkFactory的实现)

2. 如何找到对应的实现?基于SPI服务发现,扫描接口实现类,通过属性过滤,最终确定对应的实现类。

3. 底层如何提交记录?目前只支持append模式,底层基于PreparedStatement的addbatch+executeBatch批量提交

4. 数据写入数据库的时机和机制?一方面定时任务定时刷新,另一方面数量超过限制也会触发刷新。

更多Flink内容参考:

Flink Collector Output 接口源码解析

Flink Collector Output 接口源码解析

Flink中的Collector接口和其扩展Output接口在数据传递中起关键作用。Output接口增加了Watermark功能,是数据传输的基石。本文将深入解析collect方法及相关重要实现类,帮助理解数据传递的逻辑和场景划分。Collector和Output接口

Collector接口有2个核心方法,Output接口则增加了4个功能,WatermarkGaugeExposingOutput接口则专注于显示Watermark值。主要关注collect方法,它是数据发送的核心操作,Flink中有多个Output实现类,针对不同场景如数据传递、Metrics统计、广播和时间戳处理。Output实现类分类

Output类可以归类为:同一operatorChain内的数据传递(如ChainingOutput和CopyingChainingOutput)、跨operatorChain间(RecordWriterOutput)、统计Metrics(CountingOutput)、广播(BroadcastingOutputCollector)和时间戳处理(TimestampedCollector)。示例应用与调用链路

通过一个示例,我们了解了Kafka Source与Map算子之间的数据传递使用ChainingOutput,而Map到Process之间的传递则用RecordWriterOutput。在不同Output的选择中,objectReuse配置起着决定性作用,影响性能和安全性。 总结来说,ChainingOutput用于operatorChain内部,RecordWriterOutput处理跨chain,CountingOutput负责Metrics,BroadcastingOutputCollector用于广播,TimestampedCollector则用于设置时间戳。开启objectReuse会影响选择的Output类型。阅读推荐

Flink任务实时监控

Flink on yarn日志收集

Kafka Connector更新

自定义Kafka反序列化

SQL JSON Format源码解析

Yarn远程调试源码

State Processor API状态操作

侧流输出源码

Broadcast流状态源码解析

Flink启动流程分析

Print SQL Connector取样功能

保姆级教程!玩转 ChunJun 详细指南

ChunJun 是一款强大的数据集成框架,它以稳定、易用和高效著称,支持大规模数据同步与实时计算。无论是静态数据如MySQL、HDFS,还是实时变化的数据如binlog、Kafka,ChunJun都能轻松处理。其原生支持FlinkSQL的语法和特性,使得数据开发人员能专注于业务场景的构建,有效提升工作效率。

经过多年的迭代,ChunJun已成为众多企业的数据整合利器,解决了数据抽取的繁琐工作。作为系列教程的第三部分,本文将引导你如何配置ChunJun任务,通过ChunJun Client提交任务,让你全面掌握如何玩转这个工具。ChunJun的脚本支持Sync(Json)和SQL模式,每种模式都有其特定的配置和应用场景。

首先,要使用ChunJun,你需要Java(JDK8)和Maven(推荐3.6.3版本)。可以从ChunJun的GitHub或Gitee仓库下载release版本,或者选择编译源码。此外,ChunJun的代码风格管理依赖于spotless插件,记得在提交代码前进行格式化。

接下来,通过四种模式了解如何通过ChunJun Client提交任务:LocalTest(本地调试)、Standalone(独立模式)、Yarn Session(YARN会话模式)和Yarn Perjob(即将废弃的模式)。每种模式都有详细的环境准备和操作步骤,帮助你顺利启动和监控任务。

最后,如果你遇到问题,ChunJun提供了本地和远程调试选项,以便快速定位和解决问题。如果你对ChunJun的介绍和帮助感到满意,别忘了分享和关注相关资料,获取更多大数据和开源资讯。