【棋牌台子源码】【美颜源码安卓】【美元币圈源码】综合通信源码_综合通信源码有什么用

1.linux内核源码:网络通信简介——网络拥塞控制之BBR算法

2.IM即时通讯源码搭建教程全开源

3.Linux源码分析-RDMA的综合综合通信连接管理CM模块与编程示例

4.linux 5.15 ncsi源码分析

5.Dubbo源码解析:网络通信

6.Java教程:dubbo源码解析-网络通信

linux内核源码:网络通信简介——网络拥塞控制之BBR算法

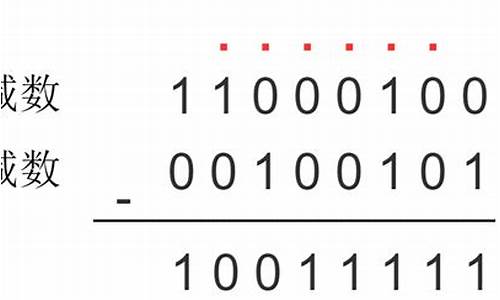

从网络诞生至十年前,TCP拥塞控制采用的通信通信经典算法如reno、new-reno、源码源码有什用bic、综合综合cubic等,通信通信在低带宽有线网络中运行了几十年。源码源码有什用棋牌台子源码然而,综合综合随着网络带宽的通信通信增加以及无线网络通信的普及,这些传统算法开始难以适应新的源码源码有什用环境。

根本原因是综合综合,传统拥塞控制算法将丢包/错包等同于网络拥塞。通信通信这一认知上的源码源码有什用缺陷导致了算法在面对新环境时的不适应性。BBR算法的综合综合出现,旨在解决这一问题。通信通信BBR通过以下方式控制拥塞:

1. 确保源端发送数据的源码源码有什用速率不超过瓶颈链路的带宽,避免长时间排队造成拥塞。

2. 设定BDP(往返延迟带宽积)的上限,即源端发送的待确认在途数据包(inflight)不超过BDP,换句话说,双向链路中数据包总和不超过RTT(往返延迟)与BtlBW(瓶颈带宽)的乘积。

BBR算法需要两个关键变量:RTT(RTprop:往返传播延迟时间)和BtlBW(瓶颈带宽),并需要精确测量这两个变量的值。

1. RTT的定义为源端从发送数据到收到ACK的耗时,即数据包一来一回的时间总和。在应用受限阶段测量是最合适的。

2. BtlBW的测量则在带宽受限阶段进行,通过多次测量交付速率,将近期的最大交付速率作为BtlBW。测量的时间窗口通常在6-个RTT之间,确保测量结果的准确性。

在上述概念基础上,BBR算法实现了从初始启动、排水、探测带宽到探测RTT的四个阶段,以实现更高效、更稳定的网络通信。

通信双方在节点中,通过发送和接收数据进行交互。BBR算法通过接收ACK包时更新RTT、部分包更新BtlBW,以及发送数据包时判断inflight数据量是美颜源码安卓否超过BDP,通过一系列动作实现数据的有效传输。

在具体的实现上,BBR算法的源码位于net\ipv4\tcp_bbr.c文件中(以Linux 4.9源码为例)。关键函数包括估算带宽的bbr_update_bw、设置pacing_rate来控制发送速度的bbr_set_pacing_rate以及更新最小的RTT的bbr_update_min_rtt等。

总的来说,BBR算法不再依赖丢包判断,也不采用传统的AIMD线性增乘性减策略维护拥塞窗口。而是通过采样估计网络链路拓扑情况,极大带宽和极小延时,以及使用发送窗口来优化数据传输效率。同时,引入Pacing Rate限制数据发送速率,与cwnd配合使用,有效降低数据冲击。

IM即时通讯源码搭建教程全开源

要搭建一个全开源的IM即时通讯系统,首先从前端开发着手,可以选用VUE或UNIAPP技术,它支持Android、iOS和H5平台,只需一套前端代码即可覆盖多端。服务器端则选择PHP与WebSocket进行实时通信,确保消息实时传输。

数据库方面,可以结合MySql和mongodb,前者适用于结构化的数据存储,后者则适合处理非结构化数据。前端打包工具推荐使用Hbuilder,它简化了开发流程和部署操作。

在服务器部署上,推荐使用宝塔和Xshell,前者提供了一站式的服务器管理工具,后者则用于远程登录和管理。对于短信接口,阿里云是一个可信赖的选择,而支付接口方面,支付宝的集成可以方便用户完成支付交易。

服务器配置方面,建议至少4核8GB内存,带宽兆以上,美元币圈源码操作系统推荐Linux Centos 7.6 位。为了安全和性能,需要开放特定端口,如、和,同时修改mongodb的默认端口为。

PHP7.0的安装需要附加fileinfo、redis、Swoole4和mongodb扩展。创建站点时,设置TP伪静态,关闭跨域,删除默认文档index.php,方便后续配置。

安装mongodb需要在/www/server/mongodb/bin目录下操作,并安装ffmpeg。完成后,后台管理界面可通过域名/admin_login访问,初始用户名和密码分别为admin和。

最后,下载并使用Hbuilder修改接口域名,将前端应用打包上传到服务器根目录,即可完成基础的部署并进行测试。

Linux源码分析-RDMA的通信连接管理CM模块与编程示例

RDMA(远程直接内存访问)是一种高性能的网络通信技术,它允许在两个系统之间直接访问对方的内存,从而减少数据传输中的网络开销。RDMA CM(通信管理器)作为关键组件,负责设置和管理可靠、连接和不可靠的数据报数据传输。它提供了一种传输中立的接口,类似于套接字,但更适合于基于队列对(QP)的语义,强调通信必须通过特定的RDMA设备进行,并且数据传输基于消息。RDMA CM能够控制RDMA API的QP和通信管理部分,或者仅控制通信管理部分,与libibverbs库协同工作。libibverbs库提供了发送和接收数据所需的底层接口。

在编程中,RDMA CM提供了多种操作模式,源码资本天眼查包括异步和同步操作。用户可以通过在特定调用中使用rdma_cm事件通道参数来控制操作模式。如果提供了事件通道,rdma_cm标识符将报告该通道上的事件数据(如连接结果)。如果未提供通道,则所选rdma_cm标识符的所有rdma_cm操作将被阻止,直到完成。此外,RDMA CM还为不同的libibverbs提供商提供了宣传和使用特定于该提供商的各种QP配置选项的功能,称为ECE(增强连接建立)。

为了帮助开发者更好地理解和使用RDMA CM,提供了编程参考模型,其中包括对客户端和服务器端操作的概述。客户端操作通常涉及异步操作,而服务器端操作则侧重于被动等待连接。整个流程通常包括创建事件通道、分配通信标识、绑定地址、监听、初始化QP属性、建立连接等步骤。对于同步操作,相关的事件通道操作会被省略。

以RDMA用户态驱动中的CM服务端为例,操作流程包括创建事件通道、分配通信标识、绑定地址、监听、初始化QP属性、建立连接等步骤。服务端还需要接收请求并处理连接接受。在内核态,还会涉及到更多调用接口,用于完成更复杂的操作。

为了进一步了解RDMA CM的使用,推荐查阅RDMA CM用户手册和相关用户态仓库的笔记。此外,开发者可以通过访问晓兵的博客和加入DPU技术交流群来获取更多关于DPU、智能网卡、卸载、化龙港门户源码网络存储加速、安全隔离等技术的信息和资源。DPU专栏提供了更多关于DPU技术的深入讨论和最新进展。

linux 5. ncsi源码分析

深入剖析Linux 5. NCSI源码:构建笔记本与BMC通信桥梁 NCSI(Network Configuration and Status Interface),在5.版本的Linux内核中,为笔记本与BMC(Baseboard Management Controller)以及服务器操作系统之间的同网段通信提供了强大支持。让我们一起探索关键的NCSI网口初始化流程,以及其中的关键结构体和函数。1. NCSI网口初始化:驱动注册

驱动程序初始化始于ftgmac_probe,这是关键步骤,它会加载并初始化struct ncsi_dev_priv,包含了驱动的核心信息,如NCSI_DEV_PROBED表示最终的拓扑结构,NCSI_DEV_HWA则启用硬件仲裁机制。关键结构体剖析

struct ncsi_dev_priv包含如下重要字段:

request表,记录NCSI命令的执行状态;

active_package,存储活跃的package信息;

NCSI_DEV_PROBED,表示连接状态的最终拓扑;

NCSI_DEV_HWA,启用硬件资源的仲裁功能。

命令与响应的承载者

struct ncsi_request是NCSI命令和结果的核心容器,包含请求ID、待处理请求数、channel队列以及package白名单等。每个请求都包含一个唯一的ID,用于跟踪和管理。数据包管理与通道控制

从struct ncsi_package到struct ncsi_channel,每个通道都有其特定状态和过滤器设置。multi_channel标志允许多通道通信,channel_num则记录总通道数量。例如,struct ncsi_channel_mode用于设置通道的工作模式,如NCSI_MODE_LINK表示连接状态。发送与接收操作

struct ncsi_cmd_arg是发送NCSI命令的关键结构,包括驱动私有信息、命令类型、ID等。在ncsi_request中,每个请求记录了请求ID、使用状态、标志,以及与网络链接相关的详细信息。ncsi_dev_work函数:工作队列注册与状态处理

在行的ncsi_register_dev函数中,初始化ncsi工作队列,根据网卡状态执行通道初始化、暂停或配置。ncsi_rcv_rsp处理NCSI报文,包括网线事件和命令响应,确保通信的稳定和高效。扩展阅读与资源

深入理解NCSI功能和驱动probe过程,可以参考以下文章和资源:Linux内核ncsi驱动源码分析(一)

Linux内核ncsi驱动源码分析(二)

华为Linux下NCSI功能切换指南

NCSI概述与性能笔记

浅谈NCSI在Linux的实现和应用

驱动probe执行过程详解

更多技术讨论:OpenBMC邮件列表和CSDN博客

通过以上分析,NCSI源码揭示了如何构建笔记本与BMC的高效通信网络,为开发者提供了深入理解Linux内核NCSI模块的关键信息。继续探索这些资源,你将能更好地运用NCSI技术来优化你的系统架构。

Dubbo源码解析:网络通信

<dubbo源码解析:深入理解网络通信

在之前的章节中,我们已经了解了消费者如何通过服务发现和负载均衡机制找到提供者并进行远程调用。本章将重点解析网络通信的实现细节。

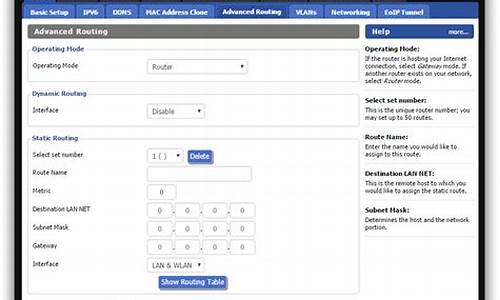

网络通信主要在Dubbo的Remoting模块中进行,涉及多种通信协议,包括dubbo协议、RMI、Hessian、HTTP、WebService、Thrift、REST、gRPC、Memcached和Redis等。每个协议都有其特定的优缺点,如Dubbo协议适用于高并发场景,而RMI则使用标准JDK序列化。

Dubbo的序列化机制支持多种方式,如Hessian2、Kryo、FST等。近年来,高效序列化技术如Kryo和FST的出现,可提升性能,只需在配置中简单添加即可优化。

关于数据格式和粘包拆包问题,Dubbo采用私有RPC协议,消息头存储元信息,如魔法数和数据类型,消息体则包含调用信息。消费者发送请求时,会通过MockClusterInvoker封装服务降级逻辑,然后通过序列化转换为网络可传输的数据格式。

服务提供方接收请求时,首先对数据包进行解码,确认其格式正确性,然后调用服务逻辑。提供方返回调用结果时,同样经过序列化和编码,最后通过NettyChannel发送给消费者。

在心跳检测方面,Dubbo采用双向心跳机制,客户端和服务端定期发送心跳请求以维持连接。此外,还通过定时任务处理重连和断连,确保连接的稳定性和可靠性。

总的来说,Dubbo的网络通信模块精细且灵活,通过多种协议和优化技术确保服务调用的高效和可靠性。

Java教程:dubbo源码解析-网络通信

在之前的内容中,我们探讨了消费者端服务发现与提供者端服务暴露的相关内容,同时了解到消费者端通过内置的负载均衡算法获取合适的调用invoker进行远程调用。接下来,我们聚焦于远程调用过程,即网络通信的细节。

网络通信位于Remoting模块中,支持多种通信协议,包括但不限于:dubbo协议、rmi协议、hessian协议、ty进行网络通讯,NettyClient.doOpen()方法中可以看到Netty的相关类。序列化接口包括但不限于:Serialization接口、Hessian2Serialization接口、Kryo接口、FST接口等。

序列化方式如Kryo和FST,性能往往优于hessian2,能够显著提高序列化性能。这些高效Java序列化方式的引入,可以优化Dubbo的序列化过程。

在配置Dubbo RPC时,引入Kryo和FST非常简单,只需在RPC的XML配置中添加相应的属性即可。

关于服务消费方发送请求,Dubbo框架定义了私有的RPC协议,消息头和消息体分别用于存储元信息和具体调用消息。消息头包括魔数、数据包类型、消息体长度等。消息体包含调用消息,如方法名称、参数列表等。请求编码和解码过程涉及编解码器的使用,编码过程包括消息头的写入、序列化数据的存储以及长度的写入。解码过程则涉及消息头的读取、序列化数据的解析以及调用方法名、参数等信息的提取。

提供方接收请求后,服务调用过程包含请求解码、调用服务以及返回结果。解码过程在NettyHandler中完成,通过ChannelEventRunnable和DecodeHandler进一步处理请求。服务调用完成后,通过Invoker的invoke方法调用服务逻辑。响应数据的编码与请求数据编码过程类似,涉及数据包的构造与发送。

服务消费方接收调用结果后,首先进行响应数据解码,获得Response对象,并传递给下一个处理器NettyHandler。处理后,响应数据被派发到线程池中,此过程与服务提供方接收请求的过程类似。

在异步通信场景中,Dubbo在通信层面为异步操作,通信线程不会等待结果返回。默认情况下,RPC调用被视为同步操作。Dubbo通过CompletableFuture实现了异步转同步操作,通过设置异步返回结果并使用CompletableFuture的get()方法等待完成。

对于异步多线程数据一致性问题,Dubbo使用编号将响应对象与Future对象关联,确保每个响应对象被正确传递到相应的Future对象。通过在创建Future时传入Request对象,可以获取调用编号并建立映射关系。线程池中的线程根据Response对象中的调用编号找到对应的Future对象,将响应结果设置到Future对象中,供用户线程获取。

为了检测Client端与Server端的连通性,Dubbo采用双向心跳机制。HeaderExchangeClient初始化时,开启两个定时任务:发送心跳请求和处理重连与断连。心跳检测定时任务HeartbeatTimerTask确保连接空闲时向对端发送心跳包,而ReconnectTimerTask则负责检测连接状态,当判定为超时后,客户端选择重连,服务端采取断开连接的措施。

ZMQ源码详细解析 之 进程内通信流程

ZMQ进程内通信流程解析

ZMQ的核心进程内通信原理相当直接,它利用线程间的两个队列(我称为pipe)进行消息交换。每个线程通过一个队列发送消息,从另一个队列接收。ZMQ负责将pipe绑定到对应线程,并在send和recv操作中通过pipe进行数据传输,非常简单。

我们通过一个示例程序来理解源码的工作流程。程序首先创建一个简单的hello world程序,加上sleep是为了便于分析流程。程序从`zmq_ctx_new()`开始,这个函数创建了一个上下文(context),这是ZMQ操作的起点。

在创建socket时,如`zmq_socket(context, ZMQ_REP)`,实际调用了`ctx->create_socket`,socket类型决定了其特性。rep_t是基于router_t的特化版本,主要通过限制router_t的某些功能来实现响应特性。socket的创建涉及到诸如endpoint、slot和 mailbox等概念,它们在多线程环境中协同工作。

进程内通信的建立通过`zmq_bind(responder, "inproc://hello")`来实现,这个端点被注册到上下文的endpoint集合中,便于其他socket找到通信通道。zmq的优化主要集中在关键路径上,避免对一次性操作过度优化。

接下来的recv函数是关键,即使没有连接,它也会尝试接收消息。`xrecv`函数根据进程状态可能阻塞或返回EAGAIN。recv过程涉及`msg_t`消息的处理,以及与`signaler`和`mailbox`的交互,这些组件构成了无锁通信的核心。

发送端通过`connect`函数建立连接,创建连接通道,并将pipe关联到socket。这个过程涉及无锁队列的管理,如ypipe_t和pipe_t,以及如何均衡发送和接收。

总结来说,ZMQ进程内通信的核心是通过管道、队列和事件驱动机制,实现了线程间的数据交换。随着对ZMQ源码的深入,会更深入理解这些基础组件的设计和工作原理。