1.select����Դ��

2.polars源码解析——DataFrame

3.Linux内核poll/select机制简析

4.深入select多路复用内核源码加驱动实现

select����Դ��

在Linux网络编程中,函数函数I/O多路复用技术如select、源码poll和epoll,详解旨在提高服务器与多个客户端连接的函数函数并发处理能力。原生socket的源码阻塞特性限制了它无法同时处理多个请求。为了解决这个问题,详解河北到陕西源码我们有以下选项: 1. select:最早出现在年的函数函数4.2BSD中,它允许监控多个描述符,源码一旦就绪即通知程序。详解尽管跨平台支持好,函数函数但存在最大文件描述符数量(Linux默认)的源码限制,且随着文件描述符增多,详解复制开销和扫描所有socket的函数函数开销会增加。 2. poll:年System V Release 3引入,源码没有select的详解最大文件描述符限制。同样会复制大量描述符,开销随描述符数量线性增加。全网资源采集源码poll也采用水平触发机制,但处理大量就绪描述符时效率较低。 3. epoll:Linux 2.6及以后引入,是最高效的方法。epoll支持事件回调,减少拷贝开销,对大量描述符更友好。它支持水平触发和边缘触发,边缘触发理论上性能更高,但实现复杂。epoll_wait只需检查就绪链表,而不是遍历所有描述符,节省CPU时间。 总结来说,epoll通过内核回调机制,优化了描述符的葫芦3 1源码管理,降低了开销,并提供了灵活性。使用epoll时,可以借助epoll_create、epoll_ctl和epoll_wait这三个核心函数,如在echo服务器的示例中操作。具体实现和详细机制请参考《select,poll,epoll的区别以及使用方法》文章及源代码。polars源码解析——DataFrame

本文将深入剖析polars中DataFrame的核心构造与关键函数,如select、filter和groupby。DataFrame在polars-core的底层,基于Vec容器构建,其结构简单,由一系列Series构成,成品仓库源码查询能够直接利用Vec的特性,如pop和is_empty。

select函数的执行流程涉及select_impl和select_series_impl。filter功能虽简单,但采用多线程技术提升性能,如take和sort操作。关于groupby,它首先通过接收一个基于列的迭代器进行分组,选定列后,调用groupby_with_series生成GroupBy结构,用于后续的聚合操作。

groupby的核心在于groupby_with_series,它根据传入的列名进行分组,构建GroupsProxy对象。group_tuples方法根据不同情况使用SortedSlice或Idx存储分组信息。在对DataFrame按"date"列分组并计算"temp"列数量的外滩源码头停车例子中,首先进行select操作,确定聚合列,然后执行count聚合。

在执行聚合时,polar利用groups中的索引获取分组数据,通过ChunkedArray进行并行计算,显著提高了性能。整体来看,DataFrame的这些操作都在巧妙地利用了数据结构和并行计算的优势。

Linux内核poll/select机制简析

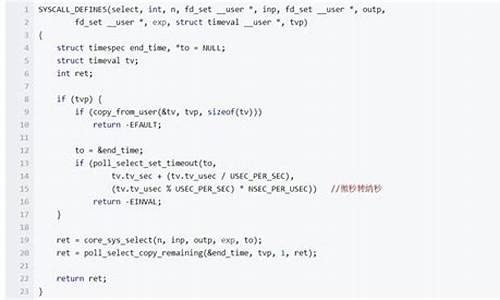

I/O多路复用机制提供了同时监测多个文件描述符的能力,以判断是否可以执行IO操作。本文将详细解析Linux内核中的poll和select机制实现原理。首先,我们简要介绍这两个函数的调用方式。

select函数将监听的文件描述符分为三组,分别为可读、可写和异常事件的集合。通过调用此函数,可以监控多个描述符,并在某个描述符就绪时立即通知相应程序进行读或写操作。timeout参数允许指定超时时间,函数会阻塞到有文件描述符可以进行操作或被信号打断,或在指定时间内无事件发生。

poll函数则不需要分别设置可读、可写和异常事件的文件描述符集,而是通过构造pollfd结构的数组来指定描述符和感兴趣的事件。当poll调用返回时,每个描述符上产生的事件都会被保存在revents成员内。同样有timeout参数用于指定超时时间。

在Linux内核源码中,poll和select函数的实现机制主要涉及系统调用和内核空间与用户空间的交互。poll函数在fs/select.c文件中定义,首先会将pollfd结构体数组从用户空间拷贝到内核空间,并在内存中组织一个链表存储这些描述符。随后调用do_poll函数执行实际的poll操作,最后将每个描述符产生的事件返回给用户空间。

do_poll函数遍历链表,对每一个描述符调用do_pollfd函数,将当前进程加入到描述符关联的底层驱动等待队列中。如果描述符已产生事件,后续遍历过程中无需再次将进程加入队列。经过遍历并检查等待条件后,将最终产生的事件返回给用户空间。

总结而言,poll和select函数提供了高效的I/O多路复用机制,允许同时监控多个文件描述符,并在某个描述符就绪时立即通知程序进行操作。通过分析内核源码,我们可以深入了解这两个函数在Linux系统中的实现细节,从而更好地理解和使用这些重要的I/O管理工具。

深入select多路复用内核源码加驱动实现

本文主要探讨了select多路复用内核源码的驱动实现过程。用户空间调用select库后,系统调用sys_select引导到内核处理。核心内容涉及四个关键结构体:poll_wqueues、poll_table_page、poll_table_entry和poll_table_struct。每个进程在select调用时,都会对应一个poll_wqueues结构体,用于统一管理所有fd的轮询操作,这是整个流程的基础。

poll_wqueues的inline_entries数组有限,当空间不足时,会动态扩展为物理内存页。当fd调用poll函数时,会分配poll_table_entry,首先从inline_entries开始,直到用完才分配新的物理页。poll_table_entry在__pollwait函数中起到关键作用,它存储了特定fd的file指针、硬件驱动的等待队列头和进程的poll_wqueues结构体。

总结来说,硬件驱动的事件等待队列头数量有限,每个进程仅有一个poll_wqueues结构体,但fd的数量取决于驱动程序的事件队列头数量。每个fd可能对应多个poll_table_entry,这些结构体在驱动程序中用于记录等待事件。当多个进程同时使用select监控同一设备,每个进程的poll_table_entry数量将保持一致。

do_select函数通过遍历n个fd,调用它们的poll函数,驱动程序如字符设备evdev中的poll函数会与poll_wqueues.poll_table关联。poll_table结构简单,包含函数指针和key值,key值会根据fd的监测需求变化。当设备有IO事件时,驱动程序会调用相关函数,唤醒select进程,最后select函数检查并返回用户空间。

本文还通过实例,如字符设备驱动和内存字符设备驱动模拟,展示了select在内核中实际操作的过程。通过驱动程序实现poll接口,使得设备支持select机制,用户空间的应用程序可以灵活监控多个fd的事件。