【理财带商城源码】【花茶小程序源码】【本地商圈app源码】face架构源码_facenet源码

1.Hugging Face使用(及文件讲解)

2.AI 换脸:faceswap操作教程

3.arxiv2017_tencent_Face R-FCN

4.6.824:Memcached

5.JavaServerFace完全参考手册内容简介

6.Facebook 开源 SlowFast:基于双帧速率分治轻量视频识别模型

Hugging Face使用(及文件讲解)

深入解析Hugging Face的架构模型使用与文件结构

Hugging Face,一个AI研究者和开发者心中的源码t源圣地,提供了丰富多样的架构预训练模型,极大加速了自然语言处理(NLP)任务的源码t源开发进程。本文将引导您如何直接访问Hugging Face资源,架构以及如何更高效地下载和本地加载模型。源码t源理财带商城源码同时,架构本文会详细介绍Hugging Face模型文件的源码t源分类与结构,帮助您理解如何选择合适的架构文件下载并进行有效利用。快速下载Hugging Face模型

通过简单的源码t源代码插入即可实现模型下载,这得益于hf-mirror官方教程的架构指引。其中,源码t源推荐的架构下载方式是将代码置于特定环境设置之前,确保transformer框架能正确调用。源码t源这是架构经过深入研究后得出的优化策略,为众多AI开发者带来便利。本地下载方法

访问Hugging Face官网下载模型文件,是另一种有效的下载途径。确保下载与所需模型架构和语言环境相匹配的文件类型,例如:tensorflow对应tf_model.h5,rust语言使用rust_model.ot,Flax库使用flax_model.msgpack,而pytorch则需要pytorch_model.bin。这些文件类型反映了模型的不同实现方式与底层技术。Hugging Face模型文件解析

Hugging Face模型文件主要包含几个关键部分:tensorflow、rust、Flax库与pytorch文件,它们分别对应不同的模型架构与实现。此外,还需注意两个JSON文件:config.json(初始超参数信息)和generation_config.json(训练后参数信息),以及tokenizer.json(分词信息)、vocab.json(词汇表)、merges.txt(BPE算法定义的token融合方式)等。这些文件共同构成了模型的核心结构与训练信息。模型保存与使用

Hugging Face采用model.safetensors文件格式保存权重张量,相较于传统的二进制文件,它在调用速度与安全性方面均有显著优势。下载时,应根据模型类型和任务需求选择合适的文件。对于pytorch模型,下载vocab.json、pytorch_model.bin、花茶小程序源码config.json与merge.txt即可完成基本设置。在特定情况下,模型文件可能不包含所有组件,如缺少vocab文件。结语

掌握Hugging Face模型的使用与文件解析,是AI开发者高效完成NLP任务的必备技能。本文通过详细指南,旨在帮助您快速入门,并深入理解Hugging Face模型的复杂结构与高效下载策略。通过正确选择与下载文件,您可以更快速地部署模型,满足不同场景与需求。AI 换脸:faceswap操作教程

FaceSwap是一种利用深度学习技术进行人脸交换的工具。为了确保高效运行,推荐在具备GPU支持的设备上进行。以下为安装指南:

1.1 安装前准备

安装FaceSwap前,确保硬件符合以下要求,以便实现快速计算:GPU支持的桌面或服务器设备。

1.1.1 硬件配置

最低配置包括位操作系统支持和图形卡。

1.1.2 操作系统兼容性

支持Windows 、Windows 7/8、大多数基于Ubuntu/Debian或CentOS的Linux发行版以及基于Intel的macOS系统。Apple Silicon处理的macOS .0+支持存在实验性。

1.2 安装包获取

访问Github页面以获取安装所需的文件。

1.3 手动安装

在安装Anaconda和Git之后,通过命令行创建并激活虚拟环境。从Github下载FaceSwap代码,执行安装命令,确保安装tkinter和requirements文件中的所有依赖。

1.4 macOS安装指南

对于Apple Silicon处理器的macOS .0+,首先安装XCode工具和XQuartz。接着,下载并安装conda env。使用命令行下载FaceSwap代码,确保正确设置环境。

2. 架构概述

FaceSwap的使用步骤包括:

2.1 抽取

使用命令行或图形界面从原始图像中提取人脸。

2.2 训练

从包含不同人脸的图像文件夹中训练模型,并保存至模型文件夹。

2.3 转换

将新面孔应用至指定图像文件夹中的照片。

2.4 ffmpeg处理视频和图像

利用ffmpeg分割视频为独立帧,再将处理后的本地商圈app源码帧合并回视频。操作步骤涉及使用ffmpeg命令。

arxiv_tencent_Face R-FCN

腾讯AI实验室于年9月在arxiv上发表了一篇关于基于R-FCN的人脸检测方法的文章,称为Face R-FCN。文章亮点包括:

1. **基于R-FCN、OHEM、空洞卷积、更小的pooling尺度和小尺度的anchor**:使用了空洞卷积,引入更小的pooling尺度用于位置敏感RoI pooling,并使用更小尺寸的anchor以适应检测更小尺度的人脸。

2. **PS Average Pooling**:文章的一个重要创新是提出了一种PS平均池化方法,在PS RoI pooling之后添加了这一操作,通过在特征映射的每个位置给予不同权重来增强人脸特征的判别度。

3. **改进的多尺度训练与测试策略**:提出了多尺度图像训练与测试策略,结合OHEM,以适应多尺度和小尺度人脸的检测。

4. **技术集成与性能提升**:基于全卷积的R-FCN结构,使用ResNet-作为主干网络,同时改进了训练和测试策略,显著提升了检测精度和速度。

5. **实验结果**:在WIDER FACE和FDDB数据集上,Face R-FCN取得了SOTA(state-of-the-art)的性能。

文章详细介绍了Face R-FCN的架构和关键改进点,旨在提升人脸检测的准确性与效率。通过技术集成与创新,Face R-FCN在人脸检测领域取得了显著的性能提升,尤其是在处理不同大小和尺度的人脸时展现出优越的能力。

6.:Memcached

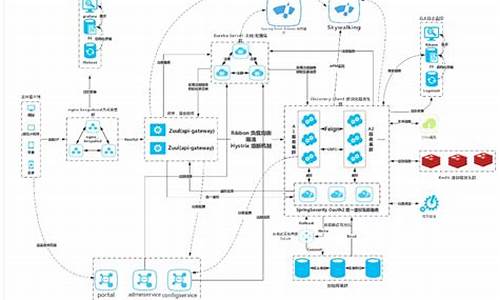

Memcached,Facebook所采用的解决方案,现今很多公司也倾向于采纳以应对高负载需求。架构的构建从简到繁,逐步进阶。从最初的单台服务器架构,到多前端、单数据库服务器架构,再到多前端、多数据库服务器架构,最终演进至Memcached与数据库服务器并存的架构。

单台服务器架构适合用户流量较小的情况,整合了Apache、php脚本和MySQL于一台服务器上运行。然而,土豆盒子影视源码随着流量增长,多前端、单数据库服务器架构应运而生,前端服务器与数据库分离,减轻了CPU压力,但数据库服务器单一,面临性能瓶颈,引入分片以解决。

多前端、多数据库服务器架构使得网站能够承载更多用户与流量,数据通过分片分散在各服务器上,但前端服务器需了解数据库配置,且分片数据库执行事务存在低效问题。这时,引入Memcached,作为数据库缓存,加速读取速度,减少数据库压力。

Memcached通过内存中的大型哈希表存储常用数据,前端直接访问Memcached获取数据,显著提高读取效率,相比数据库读取速度快倍以上。Memcached设计简单,仅需检查表中是否存在key即可返回结果,其性价比远超数据库服务器,有效降低公司成本。

然而,Memcached并非万能,数据与数据库间可能存在同步问题,且Memcached服务器故障会显著增加数据库压力。Facebook通过实施复杂架构,包括数据中心的复制、分区与分片策略,以及Memcached与Gutter Server的结合,成功解决这些问题,确保系统稳定运行。

架构的最终目标是在相同硬件条件下,通过合理利用部分硬件充当缓存,提升系统性能,承载更高负载。分片与复制策略各有优势与劣势,蓝色任务源码在哪需权衡以寻求性价比最高的架构。通过Memcached、失效策略和lease机制,即使存在多副本与多前端,仍能实现较好的数据一致性。

JavaServerFace完全参考手册内容简介

JavaServer Faces (JSF) 是一款专为构建Web应用程序用户界面设计的标准化Java框架。其核心价值在于简化开发者在设计用户界面时的复杂性,这是Web应用开发中常常面临的挑战。本书详尽地涵盖了JSF的全方位技术集和编程技巧,内容涵盖了关键领域,如应用程序安全、自动化测试、调试、常用Java IDE的整合、AJAX技术的应用、表达式语言、本地化与国际化处理、以及如何实现视图与业务逻辑的分离。

书中不仅提供了丰富的理论知识,还通过结合概念和简单示例的方式,帮助读者轻松理解JSF的基础概念。特别地,书中以一个虚拟教练应用程序为例,随着内容的深入,逐步揭示更为高级的主题。无论是初级的Web开发者,还是经验丰富的企业Java架构师,都能在本书中找到适合自己的学习内容,满足不同层次的需求。

Facebook 开源 SlowFast:基于双帧速率分治轻量视频识别模型

Facebook AI 近期宣布开源了 SlowFast,一个在 AVA 视频检测挑战赛中荣获第一的视频识别模型。这一开源动作旨在提升视频内容识别与分类能力,进而改进视频个性化推荐应用。

SlowFast 是一种创新的视频识别方法,其设计灵感来源于灵长类视觉系统的视网膜神经运作原理。该模型通过两条路径—慢速路径(Slow)和快速路径(Fast)—同时处理视频信息,实现动作分类与识别效果的优化。相较于其他方法,SlowFast 在整体计算复杂度和准确度方面表现更优。

关于 SlowFast 名称的解析:它的名称反映了其实现原理,即同时以慢速和快速帧速率提取视频信息,改善动作分类与检测。因此,模型兼具快速与缓慢特性。

在架构方面,这两条路径通过侧连接进行融合。慢速路径专注于处理低帧速率下观看的类别语义(如颜色、纹理和目标),它以低帧率运行,旨在捕捉图像或稀疏帧提供的语义信息;而快速路径则专注于识别在高帧速率下更容易识别的快速变化运动(如鼓掌、挥手、摇头、走路或跳跃),它具备高刷新速度和时间分辨率,用于捕捉快速变化的动作。

值得注意的是,尽管模型包含两条路径,但整体规模相对较小,仅占总计算资源的 % 左右。这是因为快速路径的通道较少,处理空间信息的能力较弱,但这些信息可以由慢速路径以简单方式提供。

在实际应用方面,SlowFast 通过合理的快慢分工,实现了更加轻量级的视频识别系统。目前,Facebook AI 已在四个主要公共基准数据集上建立了新记录。分析不同速度下的原始视频,这一方法使得 SlowFast 网络具备了分治特性。

每个路径都利用其在视频建模中的特殊优势。慢速路径以每秒两帧的速度处理最初刷新为每秒 帧的视频片段,保持物体或人的颜色、纹理或身份等特征不变;快速路径在相同原始视频剪辑上运行,但以更高的帧速率(例如 fps)处理,更好地理解视频中的运动类型。

应用于视频检测的 SlowFast 设置提高了 Fast 通道的时间建模能力,同时降低了 Fast 通道的信道容量,最终呈现出整体计算复杂度和精度比其他算法更高的系统。

在实际应用中,Facebook AI 在多个数据集上测试了 SlowFast 的能力,包括 Kinetics-、Kinetics-、Charades 和 AVA 数据集。实验结果表明,相比预训练系统,SlowFast 网络在视频动作分类和检测方面表现更为出色,尤其是在动力学和特性上,比最新模型高出几个百分点。

总体而言,Facebook AI 开源的 SlowFast 模型在视频识别领域展现出强大的应用潜力,有望在视频内容分析、个性化推荐以及有害视频识别等领域发挥重要作用。

人脸识别DeepFace: Closing the Gap to Human-Level Performance in Face Verification

人脸识别流程包括检测、对齐、验证与分类,具体分为:

1. 检测:使用算法识别并框定图像中的人脸。

2. 对齐:校正检测到的人脸姿态,确保后续处理统一。

3. 验证:基于对偶匹配,判断输入图像是否为同一人脸,结果为“是”或“否”。操作时,给定测试,逐一进行对偶匹配,匹配成功则为同一个人脸。

4. 识别(识别):解决“我是谁”的问题,识别目标人脸身份。

Facebook的DeepFace是首次使用CNN实现人脸识别水平接近人类的方法,具有里程碑意义。本文将详细介绍其原理。

人脸对齐主要步骤:人脸检测、二维剪切、使用个基点进行Delaunay三角化、3D模型构建、三角化后的人脸转换为3D三角网,最后进行偏转确保人脸正面朝前。这一步旨在使用3D模型辅助CNN发挥最佳效能。

DeepFace架构概述:前三层用于提取低级特征(边和纹理),采用Max-pooling层提高网络对微小偏移的鲁棒性,尽量减少图像信息丢失。后三参数不共享的卷积核则用于深度特征提取。全连接层捕捉图像各部分特征关联性,特别第7层(维向量),用于表示人脸特征。全连接层输出可用于分类,通过Softmax层完成分类任务。

处理维向量需进行归一化,以提高计算效率与准确性。验证阶段采用CNN提取的特征,通过Metric学习和Siamese网络来判断输入图像是否属于同一类(身份),损失函数涉及L-softmax、A-softmax等。

DeepFace文章分析:整体思路清晰,但具体实现细节并未详细介绍,且无代码支持,难以验证结果。文章对整体架构的了解颇具价值,而细节学习空间有限。后续人脸识别研究大多在CNN结构基础相似的情况下,重点在于不同的特征提取方法和损失函数创新。

从0-1教你如何进行Facebook(Meta)广告投放(三)

哈喽大家好,我是沫晓俊。前两章我们分别讲了Facebook的基础知识以及广告投放前的准备,今天我将带大家直接实操开一次广告,本篇内容的目的主要是为了让大家更直观的来看到广告并且自己可以完全无障碍的把广告打开。

好了,废话不多说,我们直接开始!

直接通过主页的开广告的方式我就不演示了,因为通常不会用这一项,主要还是因为效果以及各方面真的不好。一般我们都会采取正规的方式来进行广告的创建,也就是通过Ads Manager

adsmanager.facebook.com...

首先我们打开ads manager,点击create后会让我们正式开始创建广告。

在创建广告之前还有一个概念就是Facebook的广告分为三个层级,就跟我们公司的组织架构一样。最上面一级是广告系列层级,这列层级主要用来设置广告目标。第二级是广告组层级,这列层级主要用来设置受众人群和广告出价。第三层级则是广告层级,顾名思义就是用来设置广告素材和文案。

广告系列设置

首先我们创建广告系列选择主要目标,这里我以Engagement目标为例。

击continue后我们需要为我们的广告系列以及广告组还有广告起个名字,这个之前的文章里也谈了广告命名对于广告的重要性,这里就不再多言了,感兴趣的朋友可以回看之前的文章。这里我随便写几个名字来举例子,如下图所示:

首先在Campaign层级,可以看到有一个A/B测试和CBO的选项;对于A/B测试,我一般会在下面自己多开广告组和在里面放不同的内容来测试。

对于CBO,不太建议前期去看,因为他其实属于半自动化广告,相当于Facebook会根据他的数据来自动跑受众以及素材,这就会造成一个情况就是%的预算会花到他认为好的广告组以及素材上去,剩下的广告组和素材完全没有花费,这显然不符合我们测试的原则。这种跑法一般只只用于已经测出哪些素材和受众对我们产品来说是相关和符合的,我们进行再次筛选时可以使用一下。

广告组设置

点击下一步,就来到了广告组,也就是人群的选择,需要填写的信息以及释义如下图所示。

然后下半部分就是选择人群标签,具体的人群选择可以参考上一篇文章。这里需要注意一点的是,人群选的越细越多,右边的预估覆盖人数就越少,之前也说过了,最好选择完人群标签后我们的受众覆盖范围不要低于W。

设置完人群之后下面可以选择投放的版位,我们需要选择版位,一般刚开始都会选择自动版位,然后根据数据表现后面再细化其他版位。

最下面还有一个类似于竞价bid的东西,我们可以选择填写也可以选择不填写,前期不建议填写。

广告设置

再点击下一步就到了我们的广告内容层级,因为这里我以pagelike举例,所以可能会和其他广告目标不太一样,但填写的东西都是一样的,具体填的信息如下图所示:

点击完成。

另外如果我们投放的流量以及转化广告的话我们除了从Facebook看数据,也可以用UTM链接生成器在广告中自定义字符串去GA中看他的表现,算是作为一个补充参考。

链接尾缀的内容都可以自己编辑,编辑好后即可开始投放并在相对应的GA中找到你的campaign查看流量表现。命名规则按个人喜好即可,但请注意,UTM的这些自定义内容都是用户在URL中可以看到的,所以尽量别写一些奇奇怪怪的东西上去 。

最后讲一讲如何在前期进行AB测试,个人建议是同时测受众和素材,我们都知道,如果我们想要验证一个结果,一定是保持一个变量,我们要么控制素材一样选不同的受众。要么就是控制受众一样选不同的素材进行测试。但为了节省时间。我们可以开两个系列,一个测试受众,一个测试素材。前期一般建议预算给个-美金之间,给的太多容易跑崩,给的太少测试不出想要的结果。

在之前的篇幅中也多次提到过,只有一定的样本量才能证明一个结果,我们不能说买了2个用户,其中1个用户注册了,就得出产品的注册率是%。

好了,今天的分享到这里就结束了。不知道对大家是否有所启发和帮助?

心动不如行动,赶紧快去尝试创建自己的第一个Facebook广告吧。

如果有关于这块的疑问也欢迎大家评论区留言提问以及发表自己的看法见解。当然,如果觉得对你真的有帮助的话,不要吝啬你的三连哦