【FC源码解析】【easyasp源码】【源码vip】backbone源码分析

1.MaskFormer源码解析

2.源码学习之noConflict冲突处理机制

3.mmdetection源码阅读笔记:ResNet

4.MMDet——DETR源码解读

5.DETR解读

MaskFormer源码解析

整个代码结构基于detectron2框架,源码代码逻辑清晰,分析从配置文件中读取相关变量,源码无需过多关注注册指令,分析核心在于作者如何实现网络结构图中的源码关键组件。MaskFormer模型由backbone、分析FC源码解析sem_seg_head和criterion构成,源码backbone负责特征提取,分析sem_seg_head整合其他部分,源码criterion用于计算损失。分析

在backbone部分,源码作者使用了resnet和swin两种网络,分析关注输出特征的源码键值,如'res2'、分析'res3'等。源码在MaskFormerHead中,核心在于提供Decoder功能,这个部分直接映射到模型的解码过程,通过layers()函数实现。

pixel_decoder部分由配置文件指定,指向mask_former/heads/pixel_decoder.py文件中的TransformerEncoderPixelDecoder类,这个类负责将backbone提取的特征与Transformer结合,实现解码过程。easyasp源码predictor部分则是基于TransformerPredictor类,负责最终的预测输出。

模型细节中,TransformerEncoderPixelDecoder将backbone特征与Transformer结合,生成mask_features。TransformerEncoderPixelDecoder返回的参数是FPN结果与Transformer编码结果,后者通过TransformerEncoder实现,关注维度调整以适应Transformer计算需求。predictor提供最终输出,通过Transformer结构实现类别预测与mask生成。

损失函数计算部分采用匈牙利算法匹配查询和目标,实现类别损失和mask损失的计算,包括dice loss、focal loss等。整个模型结构和输出逻辑清晰,前向运算输出通过特定函数实现。

总的来说,MaskFormer模型通过backbone提取特征,通过Transformer实现解码和预测,损失函数计算统一了语义分割和实例分割任务,实现了一种有效的方法。理解代码的源码vip关键在于关注核心组件的功能实现和参数配置,以及损失函数的设计思路。强烈建议阅读原论文以获取更深入的理解。

源码学习之noConflict冲突处理机制

在早期项目中,我有机会深入了解Backbone.js的源码,特别是其noConflict冲突处理机制。这个机制其实非常直观,核心是一个简单的函数,代码量虽小,但作用显著。

noConflict的原理非常巧妙,每次调用这个函数,框架就回退到之前的一个版本。例如,如果你先引入了v1.4.0,接着引入v1.0.0,那么默认情况下,Backbone会指向最新版本v1.0.0。执行Backbone.noConflict()后,会回退到v1.4.0,再次调用则会回退到未被覆盖的原始状态,Backbone变成undefined。

让我们通过一个例子来说明:首先引入v1.4.0和v1.0.0的3121源码Backbone,输出的Backbone版本为1.0.0。执行noConflict后,版本会回退到1.4.0,再次执行noConflict则会释放Backbone,使其变为undefined。

源码中,Backbone的noConflict函数十分注释详尽,帮助开发者理解其工作原理。官方文档解释,这个方法可以防止第三方库对现有Backbone的覆盖,非常实用。

Backbone的冲突处理机制源自jQuery,很多框架都借鉴了这一设计。jQuery的noConflict方法也类似,除了版本回退,还有一个deep参数,当deep为true时,不仅$变量会回退,jQuery本身也会。

举个jQuery的例子:引入3.5.1和3.4.1版本,noConflict调用后,无论deep值如何,明道源码jQuery和$都会回退到之前的版本。

总的来说,noConflict冲突处理机制是开发过程中处理版本冲突的有力工具,它通过版本回退确保了代码的稳定性。

mmdetection源码阅读笔记:ResNet

ResNet,作为mmdetection中backbone的基石,其重要性不言而喻,它是人工智能领域引用最频繁的论文之一,微软亚洲研究院的杰作。自年提出以来,ResNet一直是目标检测领域最流行的backbone之一,其核心是通过残差结构实现更深的网络,解决深度网络退化的问题。

ResNet的基本原理是利用残差结构,通过1×1、3×3和1×1的卷积单元,如BasicBlock和BottleneckBlock,来构建不同版本的网络,如resnet-到resnet-,它们在基本单元和层数上有所区别。在mmdetection的实现中,从conv2到conv5主要由res_layer构成,其中下采样策略是关键,不同版本的网络在layer1之后的下采样位置有所不同。

ResLayer的构造函数是理解mmdetection中ResNet的关键,它涉及内存优化技术,如torch.utils.checkpoint,通过控制函数的运行方式来节省内存,但可能增加反向传播计算时间。此外,对norm层的处理也体现了与torchvision预训练模型的兼容性。

最后,ResNet的make_stage_plugins方法允许在核心结构中插入拓展组件,这增加了模型的灵活性。总的来说,ResNet的源码阅读揭示了其设计的巧妙和灵活性,是理解深度学习模型架构的重要一步。

MMDet——DETR源码解读

DETR是Object Detection领域中的创新之作,首次以完全采用Transformer结构实现端到端目标检测。DETR通过引入object query,将目标信息以query形式送入Transformer的decoder,以实现自注意力学习,捕捉不同目标的特征。query在经过Self Attention后,与图像特征进行Cross Attention,提取检测目标的特征。最终输出含有目标信息的query,通过FFN得到bbox和class信息。

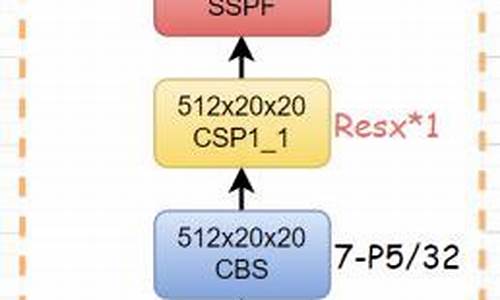

理解DETR模型前,需明确模型结构与配置。模型主要由三部分组成:Backbone,Transformer(encoder与decoder)及head。输入为batch图像,假设维度为[B, 3, W, H],使用隐层维度embed_dims为,模型变换过程如下。

DETR配置文件中,model部分分为Backbone和bbox_head。理解其配置有助于深入模型运作机制。

DETR的前向过程在mmdet/models/detectors/single_stage.py中统一为两个步骤,具体实现于detr_head(mmdet/models/dense_heads/detr_head.py)中的forward_single()函数。该函数负责除backbone外的所有前向过程。变量shape示例供理解,注意img_shape因随机裁剪而不同,导致shape不唯一。

DETR的backbone采用常规的Resnet,结构相对简单,非本文讨论重点。Transformer部分的源码在mmdet/models/utils/transformer.py文件,解析如下,N = W_feat*H_feat。

详细解读及参考文章将帮助您更深入理解DETR的内部运作与实现细节。

DETR解读

DETR(Detection Transformer)是一种新型的目标检测模型,它基于Transformer架构,由Facebook AI Research(FAIR)提出。DETR与传统目标检测方法不同,不使用锚框或候选区域,而是直接将整个图像输入到Transformer中,同时输出目标的类别和边界框。

DETR的主要构成部分包括backbone、transfomer以及head模块。本文将结合源码对DETR进行解析。

Backbone部分包含PE(position embedding)和cnn(resnet)主干网络。

PE采用二维位置编码,x和y方向各自计算了一个位置编码,每个维度的位置编码长度为num_pos_feats(该数值实际上为hidden_dim的一半),奇数位置正弦,偶数位置余弦,最后cat到一起(NHWD),permute成(NDHW)。输入的mask是2**,那么最后输出的pos encoding的shape是2***。

CNN_backbone采用resnet,以输入3**为例,输出**,下采样5次合计倍。

Transfomer主要由encoder和decoder两大模块构成。

TransformerEncoder中,qkv都来自src,其中q和k加了位置编码,v没有加,猜测原因可能是qk之间会计算attention,所以位置是比较重要的,value则是和attention相乘,不需要额外的位置编码。

TransformerDecoder中,几个重点的变量包括object query的自注意力和cross attention。

Head部分,分类分支是Linear层,回归分支是多层感知机。

Matcher采用的是HungarianMatcher匹配,这里计算的cost不参与反向传播。

Criterion根据匈牙利算法返回的indices tuple,包含了src和target的index,计算损失:分类loss+box loss。

分类损失采用交叉熵损失函数,回归损失采用L1 loss + Giou loss。

推理部分,先看detr forward函数,后处理,预测只需要卡个阈值即可。

论文链接:arxiv.org/pdf/....

代码链接:github.com/facebookrese...

参考链接:zhuanlan.zhihu.com/p/... zhuanlan.zhihu.com/p/...

如需删除侵权内容,请联系我。

- 上一条:北京开展年货市场专项检查

- 下一条:浙江湖州:开展流通领域食品安全专项行动