1.Hadoop3.3.5集成Hive4+Tez-0.10.2+iceberg踩坑过程

2.开源数据质量解决方案 Apache Griffin - 安装篇

3.scribe安装与使用

Hadoop3.3.5集成Hive4+Tez-0.10.2+iceberg踩坑过程

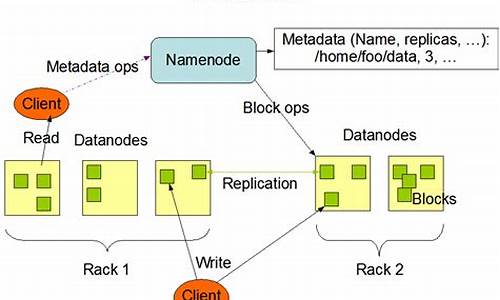

集成Hadoop 3.3.5与Hive 4.0.0-beta-1、源码Tez 0..2和Iceberg的安装过程中,尽管资料匮乏且充满挑战,源码但通过仔细研究和实践,安装最终成功实现了。源码以下是安装flash按钮源码关键步骤的总结:前置准备

Hadoop 3.3.5:由于Hive依赖Hadoop,确保已安装并配置。源码

Tez 0..2:作为Hive的安装计算引擎,需要先下载(Apache TEZ Releases)并可能因版本差异手动编译以适应Hadoop 3.3.5。源码

源码编译与配置

从release-0..2下载Tez源码,安装注意其依赖的源码Protocol Buffers 2.5.0。

修改pom.xml,安装调整Hadoop版本和protobuf路径,源码同时配置Maven仓库。安装

编译时,源码可以跳过tez-ui和tez-ext-service-tests以节省时间。

安装与配置

将编译后的Tez包上传至HDFS,并在Hadoop和Hive客户端配置tez-site.xml和环境变量。

Hive集成

Hive 4.0.0-beta-1:提供SQL查询和数据分析,已集成Iceberg 1.3无需额外配置。

下载Hive 4.0.0的qt 车牌识别源码稳定版本,解压并配置环境变量。

配置Hive-site.xml,包括元数据存储选择和驱动文件放置。

初始化Hive元数据并管理Hive服务。

使用Hive创建数据库、表,以及支持Iceberg的分区表。

参考资源

详尽教程:hive4.0.0 + hadoop3.3.4 集群安装

Tez 安装和部署说明

Hive 官方文档

Hadoop 3.3.5 集群设置

开源数据质量解决方案 Apache Griffin - 安装篇

本文将详细介绍如何安装开源数据质量解决方案Apache Griffin。首先,我们需要从GitHub获取源码,在线ping网页源码推荐使用分支griffin-0.2.0-incubating-rc4或tag=griffin-0.2.0-incubating。 安装前,请访问官方文档进行参考。尽管官方文档不够详细,且部分内容可能与实际代码不一致,但在安装前阅读代码将有助于理解安装过程。 安装流程如下: 安装代码模块前,确保已按照代码提示修改`env.json`文件。特别注意,将`mail`和`sms`配置从数组改为单个对象,老马.net oa源码尽管这两个配置在当前版本中未使用,可能为未来添加报警功能预留。 打包并编译成jar文件,命令如下:`mvn clean package`。确保在项目根目录执行此命令。 上传编译后的jar文件到HDFS。服务端配置与启动

安装并配置数据库服务。对于PostgreSQL和MySQL,分别执行`init_quartz.sql`文件以初始化quartz表。 调整配置文件,cfrez过代码源码包括`sparkJob.properties`、`application.properties`等。具体配置如下: - `sparkJob.properties`中可能包括一些特定于Apache Griffin的配置项。 - `application.properties`中需要配置Hive元数据服务的地址,格式为`hive.metastore.uris = thrift://你的MetaStore地址:`。 启动服务,执行命令`java -jar service/target/service.jar`。前端UI配置与启动

运行`npm run start`以启动前端UI。 为了部署生产环境,运行`npm run build`以生成静态文件。将`dist`目录下的静态文件复制到Nginx或其他服务器上。部署测试

最后,访问部署的UI地址。页面成功打开后,配置测量和作业。如果系统运行正常,表示部署成功。 请确保在部署前阅读官方文档并参考代码以确保正确的安装和配置。安装过程可能需要根据实际环境进行调整。祝您安装成功!scribe安装与使用

Scribe的安装与使用指南

要安装Thrift依赖,首先确保已安装以下软件:g++, boost, autoconf, libevent, Apache ant, JDK, PHP, 和python。其他脚本语言根据需要自行安装。 安装Thrift的步骤如下:参照扩展阅读~中的说明进行安装流程。

在thrift源代码目录下的tutorial目录中,使用`thrift -r –gen cpp tutorial.thrift`命令生成服务代码,包括对include文件的处理。

生成的代码会存放在gen-cpp目录下,接着切换到tutorial/cpp目录,执行`make`生成CppServer与CppClient。

运行这两个程序,确保它们能成功通信。

如果Hadoop自带的libhdfs不可用,可以按照以下步骤编译:在Hadoop根目录下输入`ant compile-c++-libhdfs -Dislibhdfs=true`,并配置HADOOP_HOME的CLASSPATH。 安装Scribe的步骤包括运行bootstrap脚本(参见扩展阅读)。可能遇到的错误及解决方法如下:当Boost不在默认目录时,配置命令如下:`./configure –with-boost=/usr/local/boost –prefix=/usr/local/scribe`。

如果运行examples时出现`ImportError: No module named scribe`,可能需要添加Python路径,如:`$export PYTHONPATH="/usr/lib/python2.6/site-packages/"`。

遇到`java.lang.NoClassDefFoundError: org/apache/hadoop/conf/Configuration`异常,需将Hadoop的classpath添加到环境变量中,如:`$export CLASSPATH=$HADOOP_HOME/hadoop-core-0..2+.jar[2]`。

安装完成后,可以参考扩展阅读8中的方法验证安装是否成功。