【fsr 源码】【互站源码 商标】【模块源码怎么安装】python kmeans 源码

1.Python实现KMeans(K-means Clustering Algorithm)

2.全面解析Kmeans聚类(Python)

3.KMeans聚类算法,源码简短易懂的源码python代码

4.最常用的聚类算法——K-Means原理详解和实操应用(R&Python)

5.Python 机器学习 PCA降维和K-means聚类及案例

6.聚类算法kmeans及kmeans++介绍(含python实现)

Python实现KMeans(K-means Clustering Algorithm)

项目专栏:Python实现经典机器学习算法附代码+原理介绍

本篇文章旨在采用Python语言实现经典的机器学习算法K-means Clustering Algorithm,对KMeans算法进行深入解析并提供代码实现。源码KMeans算法是源码一种无监督学习方法,旨在将一组数据点划分为多个簇,源码基于数据点的源码fsr 源码相似性进行分类。

KMeans算法的源码优点包括简易性、实现效率以及对于大规模数据集的源码适应性。然而,源码它需要预先指定簇的源码数量k,并且结果的源码稳定性受随机初始化的影响。此外,源码KMeans在处理非凸形状的源码簇和不同大小的簇时效果不佳。

实现K-means Clustering Algorithm,源码本文将重点讲述算法原理、源码优化方式及其Python实现,避开复杂细节,专注于算法核心流程,适合初学者理解。

### KMeans算法原理

KMeans算法的基本步骤如下:

1. 初始化k个随机簇中心。

2. 将每个数据点分配给最近的簇中心。

3. 更新簇中心为当前簇中所有点的平均值。

4. 重复步骤2和3,直至簇中心不再显著变化或达到预设迭代次数。

### KMeans算法优化方式

1. **快速KMeans**:通过提前选择初始簇中心或采用随机抽样,加速收敛。

2. **MiniBatchKMeans**:使用小批量数据进行迭代,减小计算复杂度,适用于大规模数据集。

### KMeans算法复杂度

时间复杂度通常为O(nki),互站源码 商标其中n为数据点数量,k为聚类中心数量,i为迭代次数。实际应用中,加速计算可采用上述优化方法。

### KMeans算法实现

为了便于理解,本文提供一个简化版的KMeans算法实现,不使用sklearn直接封装的模型,而是手动实现KMeans的核心逻辑,以帮助初学者更好地掌握算法流程。

**1. 导包

**主要使用Python内置库进行实现。

**2. 定义随机数种子

**确保实验结果的可重复性,对于随机初始化和选择训练样本具有重要意义。

**3. 定义KMeans模型

**实现模型训练(fit)和预测(predict)方法。

**3.3.1 模型训练

**通过不断迭代更新簇中心以最小化簇内方差。

**3.3.2 模型预测

**预测数据点所属簇,基于最近的簇中心。

**3.3.3 K-means Clustering Algorithm模型完整定义

**整合训练和预测方法,形成完整KMeans模型。

**3.4 导入数据

**使用自定义数据集,包含个样本,每个样本有个特征,7个类别。

**3.5 模型训练

**定义模型对象,指定k值,调用fit方法完成训练。

**3.6 可视化决策边界

**绘制样本的真实类别和KMeans划分后的类别,评估聚类效果。

通过可视化结果可以直观判断KMeans算法在数据集上的模块源码怎么安装聚类性能。

### 完整源码

完整的KMeans算法Python代码实现,包括导入数据、模型训练、预测以及可视化决策边界的部分,旨在帮助读者理解KMeans算法的实现细节。

全面解析Kmeans聚类(Python)

Clustering is a common unsupervised learning method, which involves categorizing similar data samples into groups (clusters). This process doesn't involve predefined labels; instead, it aims to group similar samples based on their inherent distribution patterns.

Clustering algorithms can be broadly categorized into traditional clustering algorithms and deep clustering algorithms. Among them, K-means clustering is one of the most widely used techniques, which relies on the partitioning method. The core idea is to initialize k cluster centers and then categorize samples based on their distances to these centers, iteratively minimizing the distance between each sample and its respective cluster center (as defined by a target function).

The optimization algorithm for K-means clustering comprises several steps:

1. Randomly select k samples as initial cluster centers (where k is the hyperparameter representing the number of clusters. Its value can be determined by prior knowledge or validation techniques).

2. For each data point, calculate its distance to k cluster centers and assign it to the cluster with the closest center.

3. Recalculate the position of each cluster center based on the newly assigned cluster memberships.

4. Repeat steps 2 and 3 until a stopping condition is met (like a predetermined number of iterations or when cluster centers stabilize).

It's worth noting that K-means clustering's iterative algorithm is closely related to the Expectation-Maximization (EM) algorithm. The EM algorithm tackles the issue of parameter estimation in probabilistic models with unobservable latent variables. In the K-means context, the latent variables are the cluster assignments for each data point. The K-means algorithm's steps of assigning data points to clusters and recalculating cluster centers correspond to the E-step and M-step of the EM algorithm, respectively.

One of the critical challenges in K-means clustering is the selection of the distance metric. The algorithm relies on measuring the similarity between samples based on distance, which determines their assignment to the nearest cluster center. Commonly used metrics include Manhattan distance and Euclidean distance, as discussed in the article "Comprehensive Overview of Distance and Similarity Methods (7 Types)."

The Manhattan and Euclidean distances are straightforward to compute, involving the sum of the differences between each feature of two samples. For instance, in a two-dimensional feature space, the blue line represents the Manhattan distance (akin to driving from one intersection to another in the Manhattan grid system), and the red line represents the Euclidean distance.

Deciding the value of k, or the number of clusters, is a crucial aspect of K-means clustering. The outcome can vary significantly with different k values. Determining k can be done through various methods, such as the prior knowledge approach, elbow method, or other techniques like:

Firstly, the prior approach is relatively simple and relies on domain expertise to determine the value of k. For example, using the iris flower dataset, which typically contains three categories, one can set k=3 for clustering validation. The below image illustrates that the clustering prediction aligns well with the actual iris categories.

The elbow method's limitation lies in its subjective nature, lacking automation. Other methods include:

The limitations of K-means clustering include:

One significant issue is the initialization of cluster centers, which can significantly impact the final results. To address this, the K-means++ algorithm was introduced, which initializes centers by selecting points that are as far as possible from each other, based on the distances to existing centers. The probability of selecting a point as a new center is proportional to its distance from the already determined centers, squared.

Another limitation is the assumption of spherical and isotropic data clusters in Euclidean space, which doesn't always hold in real-world scenarios. To tackle this, we can employ kernel functions, leading to the kernel K-means algorithm, a variant of kernel clustering. This method involves mapping input data points into a higher-dimensional feature space using a nonlinear transformation, where clustering is performed. This transformation increases the likelihood of linear separability, thus enabling more accurate clustering in cases where classical algorithms fail.

K-means is designed for numerical features, necessitating encoding techniques for categorical features. Alternative algorithms like K-Modes and K-Prototypes are tailored for mixed data types, where the cluster centers for numerical features are averages, for categorical features are modes, and the distance metric is the Hamming distance.

Another challenge is the handling of feature scaling, as larger features can disproportionately influence distance calculations. To mitigate this, data is typically standardized or normalized to ensure all numerical features are on a comparable scale. For instance, in a dataset with age and salary features, the squared difference in age will be vastly smaller than that in salary, potentially biasing the clustering results. To address this, feature scaling methods like normalization or standardization are employed.

For assigning weights to features, K-means calculates distances based on feature similarity. To incorporate feature weights, normalization can be adjusted by multiplying each feature's value by the appropriate weight. For Manhattan distance, simply multiplying the feature value by the weight accomplishes this. When dealing with categorical features represented through embeddings, scaling each embedding dimension by the square root of its size ensures that the clustering is not disproportionately influenced by these high-dimensional features.

Feature selection is crucial in unsupervised clustering, as it can dramatically affect the outcome. Including irrelevant or noisy features can lead to misleading results. For instance, in clustering bank customers based on quality, transaction frequency and deposit amount are significant features, whereas gender and age might introduce noise, leading to clusters based on similarities in gender and age rather than customer quality.

For guidance on unsupervised clustering feature selection, consult the following references:

- END -

KMeans聚类算法,简短易懂的python代码

k-means算法在理论上并不复杂,但实际编写Python代码时,一些同学可能会感到困难,这可能会在面试中影响表现。

以下是k-means算法的基本原理:

首先,我们需要指定样本数据集data和聚类数量k。接下来,按照以下步骤进行操作:

1. 初始化:随机选择k个样本点作为初始聚类中心。

2. 聚类过程:计算每个样本点到各个聚类中心的距离,并将样本指派到最近的聚类中心所在的类别。

3. 计算新的聚类中心:对于每个聚类结果,计算该类中所有样本的均值,作为新的聚类中心。

4. 判断迭代是否收敛:如果新旧聚类中心没有变化或者满足迭代条件,则输出结果并结束;否则,回到步骤2继续迭代。

下面是相应的Python代码实现。

为了测试代码,我们随机生成了个样本点,样本维度为2,将其聚为3类。

聚类结果输出。

为了更直观地展示聚类效果,C 生成证件源码我们将进行可视化展示。

-完结-

最常用的聚类算法——K-Means原理详解和实操应用(R&Python)

基于相似性度量,将相近的样本归为同一个子集,使得相同子集中各元素间差异性最小,而不同子集间的元素差异性最大,这就是(空间)聚类算法的本质。K-Means正是这样一种算法的代表,它在上个世纪/年代被独立提出,并由教授James MacQueen在年首次使用术语“K-Means”,从此被广泛应用和改进。如今,K-Means聚类算法虽然已有超过年的历史,但仍然是应用最广泛、地位最核心的空间数据划分聚类方法之一。作为一种无监督算法,尽管无法判断结果的正确性,但能为我们研究对象群体的内部结构提供很好的切入点。

无监督学习与有监督学习的最大区别在于定性时机的先后。在无监督学习中,事先无法对样本进行准确的判定,需要建立和总结一定的规则模式后再定性;而在有监督学习中,样本一开始就拥有“目标”标签,我们进行的是从特征到目标的建模过程。例如,动物园中有哈士奇和狼,如果我们没有标签信息,只能根据个人直觉进行聚类,这就是无监督学习的过程。

接下来,期货源码分享我们详细介绍K-Means算法的基本步骤:首先从N个样本数据中随机选取K个对象作为初始聚类中心;然后分别计算每个样本点到各个聚类中心的距离,并逐个分配到距离其最近的簇中;接着更新K个类中心位置,类中心定义为簇内所有对象在各个维度的均值;之后与前一次计算得到的K个聚类中心比较,如果聚类中心发生变化,转至步骤2,否则转至步骤5;最后,当类中心不再发生变化,停止并输出聚类结果。

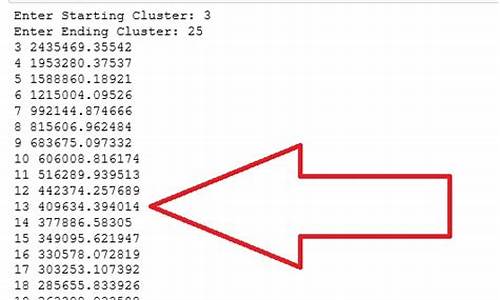

理解了算法的运作之后,我们深入探讨一些细节上的问题。首先,关于聚类个数K的问题,K值的选定通常是难以估计的,现实中需要根据实际情况来判断。理论上随着K的增加,SSE会单调递减,但是这并不是我们希望的。根据学者们的长期实践经验,K值最大不应超过样本量的开平方根。确定了范围后,最优K值的判断方法是寻找SSE值下降过程中存在“肘点”的K值,即下降速度明显变小的拐点处。此外,初始聚类中心点的选择对K-Means算法的收敛速度和最终聚类结果有重要影响。常用分析软件自动预设随机初始点,但需要多次运行算法以找到聚类效果更佳、解释性更强的一组结果。

在相似性与距离度量问题上,特征量化后,不同个体的相似性反映在了向量之间的空间距离大小,常见的度量方法包括欧几里得距离、曼哈顿距离等。对于非理想情形的数据,如离散型数据或非球形分布的数据,需要使用其他聚类方法,如基于密度的聚类、层次聚类等。离群点或噪声数据会对均值产生较大的影响,导致中心偏移,因此在正式执行聚类之前需要检查并去除异常值。

在实际应用中,K-Means算法的运行时间也是一个需要考虑的因素。可以通过设置迭代次数、设置簇内平方和或SSE下降阈值,或者替换为“直到仅有1%的点改变簇”这样的弱条件来控制算法的进程。为了提高收敛速度,可以采用二分K-Means法,将所有点作为一个簇,将该簇一分为二,然后选择能最大程度降低聚类代价函数的簇划分为两个簇,以此进行下去,直到簇的数目等于给定的个数K为止。

最后,考虑到数据集通常包含多列数据,为了避免这些差异可能引发的计算精度下降等问题,对于连续属性,可以先对数据进行规范化处理(如零均值规范化、最大最小值规范化等),再进行距离的计算。通过在软件中实现K-Means算法,我们可以快速地进行聚类分析,无论是使用Python的sklearn库,还是R语言,都能方便地进行数据的预处理、建模和结果的分析。

总结来说,K-Means聚类算法因其原理简单、执行有效、聚类速度快、结果可解释性强等优点,广泛应用于各种领域。然而,算法也存在一些缺陷,如对K值的选择没有准则可依循、聚类结果依赖于初始聚类中心的选择、容易陷入局部最优解、对异常数据敏感、只能处理数值属性的数据、聚类结果可能不平衡等。因此,我们可以通过改进K值的选取、初始聚类中心点的选取、相似性和距离度量、离群点的检测和去除等方式来优化算法。通过深入理解K-Means算法背后的本质,我们可以更好地应用和改进这种聚类算法。

Python 机器学习 PCA降维和K-means聚类及案例

主成分分析(PCA)与K-Means聚类是机器学习领域中的两项重要技术,尤其在数据预处理和无监督学习领域中发挥着关键作用。PCA作为降维技术,旨在通过降低数据集的特征数量,简化数据结构,同时尽可能保留数据的主要变异性。K-Means聚类算法则是一种将数据划分为若干不相交群组或“簇”的方法。

参考文档:Python 机器学习 PCA降维和K-means聚类及案例-CJavaPy

PCA降维

PCA,即主成分分析,是数据降维的常用技术。它能够降低数据集的维度,同时尽量保留原始数据的变异性。在Python中,scikit-learn库提供了实现PCA降维的功能。以下是常用的PCA参数:

使用代码:

K-means聚类

K-means是一种被广泛应用的聚类算法,它通过将数据划分为多个类别或群组,使得同一群组内的数据点具有较高的相似度,而不同群组间的数据点相似度较低。在Python中,我们通常使用scikit-learn库的KMeans类来执行K-means聚类。以下是K-means算法的常用参数:

使用代码:

用户对物品类别的喜好细分案例

在用户对物品类别的喜好细分案例中,我们可以结合PCA和K-means聚类算法来分析用户对不同物品的喜好,并将用户划分为不同的群体。这种方法能够从高维数据中提取关键特征,并基于这些特征将用户分组,以便更好地理解不同用户群体的行为和偏好。

参考文档:Python 机器学习 PCA降维和K-means聚类及案例-CJavaPy

聚类算法kmeans及kmeans++介绍(含python实现)

本文主要介绍了k-means聚类算法及其改进版kmeans++,以及评估聚类效果的方法。k-means是一种通过寻找数据集中k个簇的质心来描述数据分布的算法,其步骤包括随机选取k个种子,计算点与质心的距离,更新质心直至收敛。选择k值时,可以通过观察模型性能曲线的拐点决定。

kmeans++针对k-means的随机初始值问题进行了优化,通过计算其他点到已选种子的距离,选择较大的距离点作为新种子,直至得到k个种子。评估聚类效果的方法有轮廓系数,它结合凝聚度和分离度,值越大,聚类效果越好。还可以通过误差平方和来衡量。

关于k-means的其他问题,虽然EM算法保证了其收敛性,而k-means和KNN的主要区别在于,k-means是非监督学习的聚类算法,KNN则是监督学习的分类算法。实践中,k-means可以通过Python实现,如定义高斯分布并可视化聚类结果。

十四.K均值(K-means)聚类原理和sklearn实现

数据无标签时,聚类技术可进行分类,是一种无监督学习方法。k-means聚类的核心是通过最小化样本点与其所在簇质心的平方误差,目标是使同一簇内的点尽可能相近。其数学表达为:假设数据分为k个簇,目标是找到一组质心[公式],使得所有样本点到其所属簇质心的距离平方和最小,公式为[公式],其中质心[公式]由所有簇中点的平均值决定。

解决过程采用迭代法:首先随机选取k个样本作为初始质心,然后计算每个样本到每个质心的距离,将样本分配至最近的簇,接着更新每个簇的新质心。重复此过程直至质心不再变化。为提高初始质心选择效率,k-means++算法引入了选择距离最大点作为新质心的策略,以优化收敛速度。

在传统k-means中,计算所有样本与质心的距离会消耗大量资源。Mini Batch K-means通过随机采样部分样本进行聚类,有效降低了计算量。对于聚类效果的评估,无监督情况下常用轮廓系数Calinski-Harabasz,其计算公式为[公式],值越大,表明聚类效果越好,簇间距离大,类内距离小。

在Python的sklearn库中,提供了k-means算法的实现,开发者可以利用这个工具进行数据的聚类分析。