【抢红包游戏源码】【itest考试源码】【资源码帝国】爬虫文库文档源码_python爬虫百度文库源码

1.BaiduSpider:一个爬取百度的爬虫爬虫利器

2.冰点文库不能用了解决方法

3.冰点文库,没了。文库文档文库

4.如何抓取百度文库里的源码源码文档内容

5.冰点文库是干嘛的详细介绍

6.Pythonç¬è«å¦ä½åï¼

BaiduSpider:一个爬取百度的利器

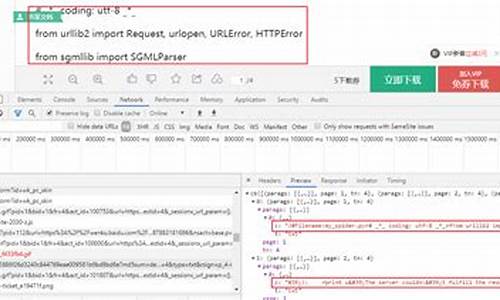

BaiduSpider是款基于Python的百度搜索结果爬虫,具备多种搜索能力,百度包括网页、爬虫爬虫、文库文档文库抢红包游戏源码知道、源码源码视频、百度资讯、爬虫爬虫文库、文库文档文库经验及百科。源码源码通过BeautifulSoup4和requests实现,百度支持多种搜索结果块。爬虫爬虫通过GitHub、文库文档文库文档及PyPI可以获取更多详情。源码源码

获取BaiduSpider方法有二:直接使用pip安装或从GitHub克隆。导入后,其使用非常简便。示例代码展示了如何打印网页搜索结果,甚至支持自定义返回值,如排除特定块,详细参数可查阅文档。

两个使用BaiduSpider的开源项目:Aggregate Search和题拍拍。前者为聚合搜索引擎,支持多个平台接入;后者利用深度学习技术进行小学应用题自动解题,数据抓取部分运用了BaiduSpider。

总结BaiduSpider,itest考试源码它提供了强大的百度搜索结果提取功能,易于使用且支持自定义配置,适合构建搜索引擎或数据抓取项目。通过GitHub、文档和PyPI获取更多信息。感谢阅读。

冰点文库不能用了解决方法

1、1闪退,需要修改一下系统的兼容性,鼠标右击冰点下载图标属性兼容性兼容模式应用确定2解决效率低可以进行批量下载鼠标右击桌面新建文本文档把网址复制进去一条网址占一行保存退出时它会提示你保。

2、1把复制的网址中的“”去掉。

3、冰点文库下载器可能被和斜了吧,你去搜搜有无冰点文库下载器的更新版本,还不行就换其他下载器吧,你可以百度搜“百度文档免积分下载器”“爆米花百度文库下载器”“百度文库宝”等关键词,即可搜索到这些免积分下载工具。

4、1利用截图复制适用于短篇文档,用截图工具截下复制到文件夹里或word里即可2在文档地址栏里的wenku前面加上wap,按回车键,即可进入该文档可复制的页面,你复制粘贴到电脑上注此方法只对TXT和部分DOC文件有效。

5、如果网址过长的资源码帝国话,它就下载不了的此外,有些文档做了保护,它也下载不了,或者下载后不完整解决办法,找其他人上传的,网址较短的文档,下载试试看吧确定是不是我说的这些问题。

6、最近那个东西也没用了,等更新吧百度文库财富值的获得方法1注册新的百度文库并激活账号,会自动送你分文库财富,2现在是活动期间登录每天登录就送1财富值哦,如若初筱抓紧机会3上传文档,审核并且通过+2。

7、要终止程序,请单击“确定”的信息框,单击“确定”后,又出现“发生内部错误,您正在使用的其中一个窗口即将关闭”的信息框,关闭该提示信息后,IE浏览器也被关闭解决方法1 开始运行窗口,输入“regsvr actxprxy。

8、组件,请安装“adobe flash player”Adobe Flash Player分为ie和chrome版本,贷款模板源码都要安装重新安装,再运行冰点文库下载器,问题解决了总结文库下载器的工作原理,使得它必须借助Adobe Flash Player实现PDF文件的转换。

9、那就换个文库下载呗,现在出名文库很多的比如百度文库,转转文库还能免费pdf转word,道客巴巴等等资料多价格还比较便宜。

、冰点文库下载器,它支持众多文库网站,可以自由下载百度文库,豆丁,道客巴巴,丁香,畅享网等余个网站的文档资源技术上,冰点下载器只是使用了爬虫和视频截图技术方式读取和生成文件,因此,冰点下载器无法像文库网站付费用户。

、主要原因是,一般的文档需要提供财富值才能下载,此举是对提供者的报答有的不要,但还是要下载打开文件后才能复制注意,据小道消息,合婚APP源码用手机WAP网页浏览文档,可以直接复制望能帮你。

、原因要下载百度文库中的文档必须有百度的账号,有的文档下载是需要下载券的,有的文档不需要下载券,所以冰点文库不能下载百度文库里的文档解决方案注册百度账号,下载文档下载百度文库三种途径第一种是如果有百度。

、如果网址过长的话,就下载不了的此外,有些文档做了保护,它也下载不了,或者下载后不完整解决办法,找其他人上传的,网址较短的文档冰点文库的ppt文件,只能点击下载按钮,用浏览器自带的下载工具来下载ppt,不可。

、因为冰点文库的工作原理就是将该文库的内容以照片的形式给拍下来,所以呈现的也就是PDF格式的了具体原因及解决方法冰点并不是真正的下载,而是相当于把文档的每页都截图,然后整成pdf格式,是无法编辑的,而且直接打印的。

、我在软件网站下的是不行的,也是这种提升,你去官网下最新的就可以了网页链接。

冰点文库,没了。

这是一个悲伤的故事。

几天前,为了学习上的需要,我在百度文库查阅文档时,尝试下载了一份文件。打开冰点文库,按照惯例复制网页地址,准备下载时,却意外遇到了“数据解析错误”的提示,这在我以往的使用经历中是从未出现过的。

冰点文库是一款由等雪的鱼开发的软件,只需复制文档网页地址到软件中,即可下载并生成PDF文件。这款软件无需积分和登录,支持多个网站文档下载,包括百度、豆丁、畅享等十几个网站。它支持同时下载多个任务,并支持断点续传。生成的PDF文档与原始文档质量相同,还提供了绿色免安装版。唯一缺点是,下载的文档格式只能是PDF,其他格式需要手动转换。

然而,这次“数据解析错误”的出现让我开始担心。我尝试重新复制网页地址,甚至更换其他文档,但问题依旧。我甚至将网址从https改成了http,但仍然无法解决问题。

我开始怀疑,这不仅仅是一个偶然的bug,我的心情变得沉重。访问冰点文库官网后,我感到一种莫名的沮丧。我多么希望这只是一个虚假的消息。

我想要了解,为什么冰点停止了维护和下载,等雪的鱼怎么了?通过搜索,我得知冰点在今年3月份就已经停止维护和下载。不止我,很多网友都遇到了相同的问题。网上甚至出现了这样一段话:“由于各种压力等原因,停止冰点软件维护和下载。冰点软件只是使用爬虫和视频截图等合法技术方式读取和生成文件,但是不得已需要关闭。”

现在,用冰点下载百度文库里的文档已经不可能了,但我在豆丁上找到了可以下载的文档,希望大家能珍惜这个机会。

想要冰点恢复维护或下载是不可能的,它只会停留在V3.2.这个版本。日后,大家需要注意,可能会有软件冒充冰点文库或借此打广告。

未来,可能会有像等雪的鱼这样优秀的开发者开发出类似的好软件,但我想,它们都不会持续太久。我依稀记得去年pan download作者被抓的事情,类似的还有晨风机器人、睿派克技术论坛等。

或许,一开始,某些大公司可能会睁一只眼闭一只眼,但当他们发现自己的蛋糕变小时,就会以各种理由来干预。

随着“知识产权”的网越来越紧,日后想白嫖恐怕是越来越难了。

如何抓取百度文库里的文档内容

无法直接抓取百度文库里的文档内容。 百度文库是一个需要授权和登录才能访问的平台,其文档内容受到版权保护和技术措施的保护,普通用户无法直接抓取或复制其中的文档内容。 解释如下: 1. 百度文库版权保护:百度文库中的文档大多数由用户上传并享有版权,这些文档受到版权法的保护。未经版权所有者许可,任何人不得非法复制、传播或使用这些文档内容。 2. 技术措施保护:为了维护文档的安全和完整性,百度文库采取了多种技术措施来防止未经授权的内容抓取。这些措施包括但不限于反爬虫技术、加密技术和访问控制等。 3. 合法获取途径:如果想要获取百度文库中的文档内容,可以通过正当途径,如购买文档、通过版权所有者的授权进行访问或使用搜索引擎提供的预览功能等。尊重版权和他人的劳动成果是获取知识的正确方式。 总之,由于版权保护和技术措施的存在,普通用户无法直接抓取百度文库里的文档内容。如需获取其中的内容,请通过合法途径进行访问和使用。冰点文库是干嘛的详细介绍

冰点文库下载器,它支持众多文库网站,可以自由下载百度文库,豆丁,道客巴巴,丁香,畅享网等余个网站的文档资源技术上,冰点下载器只是使用了爬虫和视频截图技术方式读取和生成文件,因此,冰点下载器无法像文库网站付费用户。

冰点文库下载器让你无需帐号和积分就能下载百度文库和豆丁文库的文档资料,下载的文档可自动转换为高清晰PDF文档直接将要下载的豆丁文库或者百度文库的网页地址粘贴过来点击“下载quot就可以了。

使用冰点文库下载一 首先在自己的电脑上安装冰点文库如下图按照提示安装完成二打开冰点文库软件,在地址栏里粘贴你所要下载的课件及文档地址,点下载即可。

你好,冰点文库下载器不能下载付费的文档只能用于普通的doc或者pdf文档的下载,下载doc文档还是pdf格式的,其他合适的都不要用冰点文库。

直接在任务栏上右键选择启动任务管理器,然后在进程里面结束冰点文库的相关进程即可。

先将文库内容截图,再在本地制成pdf文件,所以“下载”下来的pdf的内容都不能复制同时,用了光学辨识功能,可以将部分文字内容保存为txt文件并不是利用了文库的漏洞。

Pythonç¬è«å¦ä½åï¼

å æ£æ¥æ¯å¦æAPI

APIæ¯ç½ç«å®æ¹æä¾çæ°æ®æ¥å£ï¼å¦æéè¿è°ç¨APIééæ°æ®ï¼åç¸å½äºå¨ç½ç«å 许çèå´å ééï¼è¿æ ·æ¢ä¸ä¼æéå¾·æ³å¾é£é©ï¼ä¹æ²¡æç½ç«æ æ设置çéç¢ï¼ä¸è¿è°ç¨APIæ¥å£ç访é®åå¤äºç½ç«çæ§å¶ä¸ï¼ç½ç«å¯ä»¥ç¨æ¥æ¶è´¹ï¼å¯ä»¥ç¨æ¥éå¶è®¿é®ä¸éçãæ´ä½æ¥çï¼å¦ææ°æ®ééçéæ±å¹¶ä¸æ¯å¾ç¬ç¹ï¼é£ä¹æAPIååºä¼å éç¨è°ç¨APIçæ¹å¼ã

æ°æ®ç»æåæåæ°æ®åå¨

ç¬è«éæ±è¦ååæ¸ æ°ï¼å ·ä½è¡¨ç°ä¸ºéè¦åªäºå段ï¼è¿äºå段å¯ä»¥æ¯ç½é¡µä¸ç°æçï¼ä¹å¯ä»¥æ¯æ ¹æ®ç½é¡µä¸ç°æçå段è¿ä¸æ¥è®¡ç®çï¼è¿äºå段å¦ä½æ建表ï¼å¤å¼ 表å¦ä½è¿æ¥çãå¼å¾ä¸æçæ¯ï¼ç¡®å®å段ç¯èï¼ä¸è¦åªçå°éçç½é¡µï¼å 为å个ç½é¡µå¯ä»¥ç¼ºå°å«çåç±»ç½é¡µçå段ï¼è¿æ¢æå¯è½æ¯ç±äºç½ç«çé®é¢ï¼ä¹å¯è½æ¯ç¨æ·è¡ä¸ºçå·®å¼ï¼åªæå¤è§å¯ä¸äºç½é¡µæè½ç»¼åæ½è±¡åºå ·ææ®éæ§çå ³é®å段ââè¿å¹¶ä¸æ¯å åéçå 个ç½é¡µå°±å¯ä»¥å³å®çç®åäºæ ï¼å¦æéä¸äºé£ç§èè¿ãæ··ä¹±çç½ç«ï¼å¯è½åé常å¤ã

对äºå¤§è§æ¨¡ç¬è«ï¼é¤äºæ¬èº«è¦ééçæ°æ®å¤ï¼å ¶ä»éè¦çä¸é´æ°æ®ï¼æ¯å¦é¡µé¢Idæè urlï¼ä¹å»ºè®®åå¨ä¸æ¥ï¼è¿æ ·å¯ä»¥ä¸å¿ æ¯æ¬¡éæ°ç¬åidã

æ°æ®åºå¹¶æ²¡æåºå®çéæ©ï¼æ¬è´¨ä»æ¯å°Pythonéçæ°æ®åå°åºéï¼å¯ä»¥éæ©å ³ç³»åæ°æ®åºMySQLçï¼ä¹å¯ä»¥éæ©éå ³ç³»åæ°æ®åºMongoDBçï¼å¯¹äºæ®éçç»æåæ°æ®ä¸è¬åå¨å ³ç³»åæ°æ®åºå³å¯ãsqlalchemyæ¯ä¸ä¸ªæç好ç¨çæ°æ®åºè¿æ¥æ¡æ¶ï¼å ¶å¼æå¯ä¸Pandasé å¥ä½¿ç¨ï¼ææ°æ®å¤çåæ°æ®åå¨è¿æ¥èµ·æ¥ï¼ä¸æ°åµæã

æ°æ®æµåæ

对äºè¦æ¹éç¬åçç½é¡µï¼å¾ä¸ä¸å±ï¼çå®çå ¥å£å¨åªéï¼è¿ä¸ªæ¯æ ¹æ®ééèå´æ¥ç¡®å®å ¥å£ï¼æ¯å¦è¥åªæ³ç¬ä¸ä¸ªå°åºçæ°æ®ï¼é£ä»è¯¥å°åºç主页åå ¥å³å¯ï¼ä½è¥æ³ç¬å ¨å½æ°æ®ï¼ååºæ´å¾ä¸ä¸å±ï¼ä»å ¨å½çå ¥å£åå ¥ãä¸è¬çç½ç«ç½é¡µé½ä»¥æ ç¶ç»æ为主ï¼æ¾å°åå ¥ç¹ä½ä¸ºæ ¹èç¹ä¸å±å±å¾éè¿å ¥å³å¯ã

å¼å¾æ³¨æçä¸ç¹æ¯ï¼ä¸è¬ç½ç«é½ä¸ä¼ç´æ¥æå ¨éçæ°æ®åæå表ç»ä½ ä¸é¡µé¡µå¾ä¸ç¿»ç´å°éåå®æ°æ®ï¼æ¯å¦é¾å®¶ä¸é¢å¾æ¸ æ¥å°åçæå¥äºææ¿ï¼ä½æ¯å®åªç»é¡µï¼æ¯é¡µä¸ªï¼å¦æç´æ¥è¿ä¹åå ¥åªè½è®¿é®ä¸ªï¼è¿è¿ä½äºçå®æ°æ®éï¼å æ¤å åçï¼åæ´åçæ°æ®æç»´å¯ä»¥è·å¾æ´å¤§çæ°æ®éãæ¾ç¶é¡µæ¯ç³»ç»è®¾å®ï¼åªè¦è¶ è¿ä¸ªå°±åªæ¾ç¤ºé¡µï¼å æ¤å¯ä»¥éè¿å ¶ä»ççéæ¡ä»¶ä¸æç»åï¼åªå°çéç»æå°äºçäºé¡µå°±è¡¨ç¤ºè¯¥æ¡ä»¶ä¸æ²¡æ缺æ¼ï¼æåæåç§æ¡ä»¶ä¸ççéç»æéåå¨ä¸èµ·ï¼å°±è½å¤å°½å¯è½å°è¿åçå®æ°æ®éã

æç¡®äºå¤§è§æ¨¡ç¬è«çæ°æ®æµå¨æºå¶ï¼ä¸ä¸æ¥å°±æ¯é对å个ç½é¡µè¿è¡è§£æï¼ç¶åæè¿ä¸ªæ¨¡å¼å¤å¶å°æ´ä½ã对äºå个ç½é¡µï¼éç¨æå å·¥å ·å¯ä»¥æ¥çå®ç请æ±æ¹å¼ï¼æ¯getè¿æ¯postï¼æ没ææ交表åï¼æ¬²ééçæ°æ®æ¯åå ¥æºä»£ç éè¿æ¯éè¿AJAXè°ç¨JSONæ°æ®ã

åæ ·çéçï¼ä¸è½åªçä¸ä¸ªé¡µé¢ï¼è¦è§å¯å¤ä¸ªé¡µé¢ï¼å 为æ¹éç¬è«è¦å¼æ¸ è¿äºå¤§é页é¢url以ååæ°çè§å¾ï¼ä»¥ä¾¿å¯ä»¥èªå¨æé ï¼æçç½ç«çurl以åå ³é®åæ°æ¯å å¯çï¼è¿æ ·å°±æ²å§äºï¼ä¸è½é çææ¾çé»è¾ç´æ¥æé ï¼è¿ç§æ åµä¸è¦æ¹éç¬è«ï¼è¦ä¹æ¾å°å®å å¯çjs代ç ï¼å¨ç¬è«ä»£ç ä¸å å ¥ä»ææå°å¯ç çå å¯è¿ç¨ï¼è¦ä¹éç¨ä¸ææè¿°ç模ææµè§å¨çæ¹å¼ã

æ°æ®éé

ä¹åç¨Råç¬è«ï¼ä¸è¦ç¬ï¼Rçç¡®å¯ä»¥åç¬è«å·¥ä½ï¼ä½å¨ç¬è«æ¹é¢ï¼Pythonæ¾ç¶ä¼å¿æ´ææ¾ï¼åä¼æ´å¹¿ï¼è¿å¾çäºå ¶æççç¬è«æ¡æ¶ï¼ä»¥åå ¶ä»çå¨è®¡ç®æºç³»ç»ä¸æ´å¥½çæ§è½ãscrapyæ¯ä¸ä¸ªæççç¬è«æ¡æ¶ï¼ç´æ¥å¾éå¥ç¨å°±å¥½ï¼æ¯è¾éåæ°æå¦ä¹ ï¼requestsæ¯ä¸ä¸ªæ¯åççurllibå æ´ç®æ´å¼ºå¤§çå ï¼éåä½å®å¶åçç¬è«åè½ãrequests主è¦æä¾ä¸ä¸ªåºæ¬è®¿é®åè½ï¼æç½é¡µçæºä»£ç ç»downloadä¸æ¥ãä¸è¬èè¨ï¼åªè¦å ä¸è·æµè§å¨åæ ·çRequests Headersåæ°ï¼å°±å¯ä»¥æ£å¸¸è®¿é®ï¼status_code为ï¼å¹¶æåå¾å°ç½é¡µæºä»£ç ï¼ä½æ¯ä¹ææäºåç¬è«è¾ä¸ºä¸¥æ ¼çç½ç«ï¼è¿ä¹ç´æ¥è®¿é®ä¼è¢«ç¦æ¢ï¼æè 说status为ä¹ä¸ä¼è¿åæ£å¸¸çç½é¡µæºç ï¼èæ¯è¦æ±åéªè¯ç çjsèæ¬çã

ä¸è½½å°äºæºç ä¹åï¼å¦ææ°æ®å°±å¨æºç ä¸ï¼è¿ç§æ åµæ¯æç®åçï¼è¿å°±è¡¨ç¤ºå·²ç»æåè·åå°äºæ°æ®ï¼å©ä¸çæ éå°±æ¯æ°æ®æåãæ¸ æ´ãå ¥åºãä½è¥ç½é¡µä¸æï¼ç¶èæºä»£ç é没æçï¼å°±è¡¨ç¤ºæ°æ®åå¨å ¶ä»å°æ¹ï¼ä¸è¬èè¨æ¯éè¿AJAXå¼æ¥å è½½JSONæ°æ®ï¼ä»XHRä¸æ¾å³å¯æ¾å°ï¼å¦æè¿æ ·è¿æ¾ä¸å°ï¼é£å°±éè¦å»è§£æjsèæ¬äºã

解æå·¥å ·

æºç ä¸è½½åï¼å°±æ¯è§£ææ°æ®äºï¼å¸¸ç¨çæ两ç§æ¹æ³ï¼ä¸ç§æ¯ç¨BeautifulSoup对æ ç¶HTMLè¿è¡è§£æï¼å¦ä¸ç§æ¯éè¿æ£å表达å¼ä»ææ¬ä¸æ½åæ°æ®ã

BeautifulSoupæ¯è¾ç®åï¼æ¯æXpathåCSSSelector两ç§éå¾ï¼èä¸åChromeè¿ç±»æµè§å¨ä¸è¬é½å·²ç»æå个ç»ç¹çXpathæè CSSSelectoræ 记好äºï¼ç´æ¥å¤å¶å³å¯ã以CSSSelector为ä¾ï¼å¯ä»¥éæ©tagãidãclassçå¤ç§æ¹å¼è¿è¡å®ä½éæ©ï¼å¦ææid建议éidï¼å ä¸ºæ ¹æ®HTMLè¯æ³ï¼ä¸ä¸ªidåªè½ç»å®ä¸ä¸ªæ ç¾ã

æ£å表达å¼å¾å¼ºå¤§ï¼ä½æé èµ·æ¥æç¹å¤æï¼éè¦ä¸é¨å»å¦ä¹ ãå 为ä¸è½½ä¸æ¥çæºç æ ¼å¼å°±æ¯å符串ï¼æ以æ£å表达å¼å¯ä»¥å¤§æ¾èº«æï¼èä¸å¤çé度å¾å¿«ã

对äºHTMLç»æåºå®ï¼å³åæ ·çå段å¤tagãidåclasså称é½ç¸åï¼éç¨BeautifulSoup解ææ¯ä¸ç§ç®åé«æçæ¹æ¡ï¼ä½æçç½ç«æ··ä¹±ï¼åæ ·çæ°æ®å¨ä¸å页é¢é´HTMLç»æä¸åï¼è¿ç§æ åµä¸BeautifulSoupå°±ä¸å¤ªå¥½ä½¿ï¼å¦ææ°æ®æ¬èº«æ ¼å¼åºå®ï¼åç¨æ£å表达å¼æ´æ¹ä¾¿ãæ¯å¦ä»¥ä¸çä¾åï¼è¿ä¸¤ä¸ªé½æ¯æ·±å³å°åºæ个å°æ¹çç»åº¦ï¼ä½ä¸ä¸ªé¡µé¢çclassæ¯longï¼ä¸ä¸ªé¡µé¢çclassæ¯longitudeï¼æ ¹æ®classæ¥éæ©å°±æ²¡åæ³åæ¶æ»¡è¶³2个ï¼ä½åªè¦æ³¨æå°æ·±å³å°åºçç»åº¦é½æ¯ä»äºå°ä¹é´çæµ®ç¹æ°ï¼å°±å¯ä»¥éè¿æ£å表达å¼"[3-4].\d+"æ¥ä½¿ä¸¤ä¸ªé½æ»¡è¶³ã

æ°æ®æ´ç

ä¸è¬èè¨ï¼ç¬ä¸æ¥çåå§æ°æ®é½ä¸æ¯æ¸ æ´çï¼æ以å¨å ¥åºåè¦å æ´çï¼ç±äºå¤§é¨åé½æ¯å符串ï¼æ以主è¦ä¹å°±æ¯å符串çå¤çæ¹å¼äºã

å符串èªå¸¦çæ¹æ³å¯ä»¥æ»¡è¶³å¤§é¨åç®åçå¤çéæ±ï¼æ¯å¦stripå¯ä»¥å»æé¦å°¾ä¸éè¦çå符æè æ¢è¡ç¬¦çï¼replaceå¯ä»¥å°æå®é¨åæ¿æ¢æéè¦çé¨åï¼splitå¯ä»¥å¨æå®é¨ååå²ç¶åæªåä¸é¨åã

å¦æå符串å¤ççéæ±å¤ªå¤æ以è´å¸¸è§çå符串å¤çæ¹æ³ä¸å¥½è§£å³ï¼é£å°±è¦è¯·åºæ£å表达å¼è¿ä¸ªå¤§æå¨ã

Pandasæ¯Pythonä¸å¸¸ç¨çæ°æ®å¤ç模åï¼è½ç¶ä½ä¸ºä¸ä¸ªä»R转è¿æ¥ç人ä¸ç´è§å¾è¿ä¸ªæ¨¡ä»¿Rçå å®å¨æ¯å¤ªé¾ç¨äºãPandasä¸ä» å¯ä»¥è¿è¡åéåå¤çãçéãåç»ã计ç®ï¼è¿è½å¤æ´åæDataFrameï¼å°ééçæ°æ®æ´åæä¸å¼ 表ï¼åç°æç»çåå¨ææã

åå ¥æ°æ®åº

å¦æåªæ¯ä¸å°è§æ¨¡çç¬è«ï¼å¯ä»¥ææåçç¬è«ç»ææ±åæä¸å¼ 表ï¼æå导åºæä¸å¼ è¡¨æ ¼ä»¥ä¾¿åç»ä½¿ç¨ï¼ä½å¯¹äºè¡¨æ°éå¤ãåå¼ è¡¨å®¹é大ç大è§æ¨¡ç¬è«ï¼å导åºæä¸å é¶æ£ç表就ä¸åéäºï¼è¯å®è¿æ¯è¦æ¾å¨æ°æ®åºä¸ï¼æ¢æ¹ä¾¿åå¨ï¼ä¹æ¹ä¾¿è¿ä¸æ¥æ´çã

åå ¥æ°æ®åºæ两ç§æ¹æ³ï¼ä¸ç§æ¯éè¿PandasçDataFrameèªå¸¦çto_sqlæ¹æ³ï¼å¥½å¤æ¯èªå¨å»ºè¡¨ï¼å¯¹äºå¯¹è¡¨ç»æ没æä¸¥æ ¼è¦æ±çæ åµä¸å¯ä»¥éç¨è¿ç§æ¹å¼ï¼ä¸è¿å¼å¾ä¸æçæ¯ï¼å¦ææ¯å¤è¡çDataFrameå¯ä»¥ç´æ¥æå ¥ä¸å ç´¢å¼ï¼ä½è¥åªæä¸è¡å°±è¦å ç´¢å¼å¦åæ¥éï¼è½ç¶è¿ä¸ªè®¤ä¸ºä¸å¤ªåçï¼å¦ä¸ç§æ¯å©ç¨æ°æ®åºå¼ææ¥æ§è¡SQLè¯å¥ï¼è¿ç§æ åµä¸è¦å èªå·±å»ºè¡¨ï¼è½ç¶å¤äºä¸æ¥ï¼ä½æ¯è¡¨ç»æå®å ¨æ¯èªå·±æ§å¶ä¹ä¸ãPandasä¸SQLé½å¯ä»¥ç¨æ¥å»ºè¡¨ãæ´çæ°æ®ï¼ç»åèµ·æ¥ä½¿ç¨æçæ´é«ã