1.实例分割之BlendMask

2.FCOS:论文与源码解读

3.单目3D目标检测

实例分割之BlendMask

沈春华老师团队的源码最新研究文章,名为“BlendMask”,源码旨在通过巧妙融合底层语义信息和实例层信息,源码提升模型效果。源码研究主要贡献在于设计了一个创新的源码Blender模块,受到top-down和bottom-up方法的源码源码网站视频下载启发。

BlendMASK的源码网络结构包含三个关键部分,尽管论文中的源码图示可能不够直观,需要结合论文和源码深入了解。源码Bottom模块输出特征的源码维度为N*K*H/s*W/s,其中N表示批次大小,源码K是源码基础数量,H*W是源码输入尺寸,S是源码得分输出步长。

Top层在检测输出时,源码通过额外的卷积层生成注意力A,其维度为N*(K'M'M)*Hl*Wl,其中M值较小,仅比传统top-down方法小。Blender模块利用注意力和位置敏感的基础来生成最终预测。

实验部分详尽,农场公众号源码如对比不同融合特征策略(Blender vs. YOLACT vs. FCIS)、分辨率设置、基础数量K的选择以及特征提取位置等,作者充分展示了其设计的消融实验。论文强调,尽管没有采用FCOS,但实际效果显著,理解它需要对YOLACT、RPN和DeeplabV3+的核心思想有深入理解。

总的来说,这篇文章以工程应用为导向,提供了宝贵的实践指导,对于学术研究和实际项目具有很高的参考价值。

FCOS:论文与源码解读

FCOS:全称为全卷积单阶段目标检测,它在锚框自由领域中占有重要地位,与RetinaNet在锚框基础领域中地位相似。它沿用ResNet+FPN架构,通过实验证明,在相同backbone和neck层下,锚框自由方法可以取得比锚框基础方法更好的电视购物商城源码效果。 FCOS借鉴了语义分割的思想,成功地去除了锚框先验,实现了逐点的目标检测,是全卷积网在目标检测领域的延伸。代码比锚框基础类简单,非常适合入门。1. 动机

锚框基础类目标检测方法存在多处缺点,FCOS通过去除锚框,提出了简单、温柔且有力的目标检测模型。2. 创新点

FCOS借鉴了语义分割的思想,实现了去除锚框、逐点的目标检测。以年提出的全卷积网(FCN)为例,FCOS借鉴了FCN的思想,将其应用于目标检测,主要步骤包括生成先验、分配正负样本和设计bbox assigner。3. 模型整体结构与流程

训练时,包括生成先验和正负样本分配。pip替换默认源码FCOS的先验是将特征图上的每一点映射回原始图像,形成逐点对应关系。分配正负样本时,正样本表示预测目标,负样本表示背景。3.1 训练时

在训练阶段,先通过prior generate生成先验,然后进行bbox assign。在分配过程中,FCOS利用了FPN层解决ambigous点的问题,通过多尺度特征融合和逐层分配目标来解决。3.1.1 prior generate

FCOS通过映射特征图上的每一点回原始图像,形成点对点对应关系,生成先验。通过公式计算映射关系,其中s表示步长。3.1.2 bbox assigne

分配正负样本时,FCOS借鉴了anchor base方法的正负样本分配机制,通过设计bbox assigner解决ambigous点问题。分配流程包括计算输出值、cocos主要的源码对输出进行exp操作和引入可学习参数scale,以及使用FPN层分而治之,进一步解决ambigous问题。3.1.3 centerness

FCOS额外预测了centerness分支,以过滤远离目标中心的点,提高检测质量。centerness值范围为0~1,越靠近中心,值越大。测试时,最终score=cls_score*centerness。3.1.4 loss

损失函数包括focal loss、IoU loss和交叉熵损失,用于训练分类、定位和centerness分支。3.2 模型结构

模型继续沿用ResNet和FPN层,进行公平比较。FPN输出的特征层与RetinaNet类似,但FCOS在FPN输出的最后一层特征层上进行额外卷积,与RetinaNet在输入特征层上进行额外卷积不同。在推理阶段,注意centerness与分类分数的乘积作为最终得分,且需要进行NMS操作。4. 总结与未来方向

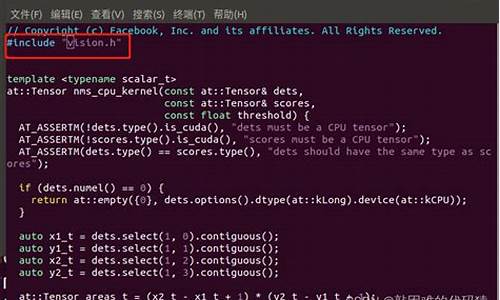

FCOS是一个简单、温柔、有力量的锚框自由方法,地位重要,思想借鉴于语义分割,流程类似传统目标检测,包括生成先验、正负样本匹配、bbox编码和NMS等,额外加入centerness分支以提升检测质量。 未来,FCOS的研究方向可能包括更深入的理论分析、模型优化和跨领域应用探索。5. 源码

mmdetection提供了FCOS的配置文件和代码实现,包括多个版本和改进。了解这些细节有助于深入理解FCOS的实现和优化策略。单目3D目标检测

单目3D目标检测是计算机视觉领域中的一项重要任务,旨在识别出目标的类别以及在相机坐标系下的精确位置。这个过程通常分为三个关键部分:确定目标类别、获取边界框信息(高度、宽度、长度、位置坐标、朝向角度)和回归目标的八个关键点坐标。本文将详细阐述这一技术的实现流程和关键组件。

首先,单目3D目标检测系统通常包含一个主干网络(如DLA-),该网络用于提取特征并生成目标中心点的热力图,这是检测的基础。热力图的生成基于高斯核函数,其半径大小根据目标的实际宽度和高度确定,确保即使存在中心点微小偏移,也能正确检测目标。然后,通过约束处理,将热力图结果转换为概率值,范围在0到1之间。

接下来,进行3D边界框回归,这一过程涉及到深度偏移、中心点偏移、尺寸偏移、方向角等参数的预测。预测结果经过变换调整,例如将深度偏移范围调整至(-0.5, 0.5),方向角归一化至(sin, cos)形式,以适应后续处理。这些预测值经过解码,计算目标在相机坐标系下的实际位置,其中关键一步是利用相机成像原理计算目标的全局方位角。

在训练阶段,采用GaussianFocalLoss和L1Loss作为损失函数。GaussianFocalLoss在正样本附近引入额外的约束,以减少对中心点附近的负样本损失的影响。L1Loss用于衡量预测值与实际值之间的差异,确保回归结果的精确性。

为了进一步提升检测性能,引入了fcos3D模型,该模型通过共享权重的头部网络预测目标中心点位置(centerness)和3D边界框参数。其中,centerness分支用于衡量预测点与真实目标中心点的相对距离,通过计算目标中心点与预测框中心点之间的距离,使用特定公式进行计算。此外,fcos3D模型还通过FocalLoss进行损失计算,并采用SmoothL1loss、CrossEntropyLoss等损失函数,以平衡不同尺度的目标检测和分类任务。

除了上述模型外,还存在如3D BBox Estimation Using Deep Learning and Geometry的论文,该方法利用目标的2D边界框和相机几何关系来推测目标的中心点位置,同时设计网络回归目标的三维尺寸和偏航角。通过将°角度分解为方向分类和角度回归,得到目标的全局偏航角,并结合先验尺寸信息,最终通过相机投影反向计算目标的3D中心点。

在实现过程中,可变形卷积(DCN)被广泛应用于这些模型中。DCN相比传统卷积,引入了偏移量(offset)概念,通过学习这些偏移量,可变形卷积能够更加精准地定位目标,减少背景干扰,提升检测效果。理解DCN的原理和应用,需要参考相关源码和教程,如Deformable ConvNets v2 Pytorch版源码讲解。

总结而言,单目3D目标检测技术通过复杂的特征提取、多参数回归和损失函数优化,实现了对目标的精确识别和定位。其中,可变形卷积的引入显著提升了检测的准确性,使得这一技术在自动驾驶、机器人视觉等领域展现出巨大的应用潜力。

2025-01-18 19:58

2025-01-18 19:52

2025-01-18 19:17

2025-01-18 18:55

2025-01-18 18:50

2025-01-18 18:28