【60交易源码】【预约PHP源码下载】【赚钱广告游戏源码】集群源码分析_集群源码分析怎么做

1.Redis 集群集群radix tree 源码解析

2.Nacos源码分析-集群间临时实例数据的一致性同步

3.一文读懂,硬核 Apache DolphinScheduler3.0 源码解析

4.浅析源码 golang kafka sarama包(一)如何生产消息以及通过docker部署kafka集群with kraft

5.Zookeeper源码集群启动

6.ZookeeperApach Curator 框架源码分析:初始化过程(一)Ver 4.3.0

Redis 源码源码radix tree 源码解析

Redis 实现了不定长压缩前缀的 radix tree,用于集群模式下存储 slot 对应的分析分析所有 key 信息。本文解析在 Redis 集群集群中实现 radix tree 的核心内容。

核心数据结构的源码源码定义如下:

每个节点结构体 (raxNode) 包含了指向子节点的指针、当前节点的分析分析60交易源码 key 的长度、以及是集群集群否为叶子节点的标记。

以下是源码源码插入流程示例:

场景一:仅插入 "abcd"。此节点为叶子节点,分析分析使用压缩前缀。集群集群

场景二:在 "abcd" 之后插入 "abcdef"。源码源码从 "abcd" 的分析分析父节点遍历至压缩前缀,找到 "abcd" 空子节点,集群集群插入 "ef" 并标记为叶子节点。源码源码

场景三:在 "abcd" 之后插入 "ab"。分析分析ab 为 "abcd" 的前缀,插入 "ab" 为子节点,并标记为叶子节点。同时保留 "abcd" 的前缀结构。

场景四:在 "abcd" 之后插入 "abABC"。ab 为前缀,创建 "ab" 和 "ABC" 分别为子节点,保持压缩前缀结构。

删除流程则相对简单,找到指定 key 的叶子节点后,向上遍历并删除非叶子节点。若删除后父节点非压缩且大小大于1,则需处理合并问题,以优化树的高度。

合并的条件涉及:删除节点后,检查父节点是否仍为非压缩节点且包含多个子节点,以此决定是否进行合并操作。

结束语:云数据库 Redis 版提供了稳定可靠、性能卓越、可弹性伸缩的数据库服务,基于飞天分布式系统和全SSD盘高性能存储,支持主备版和集群版高可用架构。提供全面的容灾切换、故障迁移、预约PHP源码下载在线扩容、性能优化的数据库解决方案,欢迎使用。

Nacos源码分析-集群间临时实例数据的一致性同步

Nacos集群在部署时,如何实现临时实例数据在集群间的同步?答案在于Distro一致性协议。Distro协议确保了Nacos注册中心的可用性,当临时实例注册到Nacos注册中心时,集群中的实例数据并不一致,通过Distro协议同步后才达到最终一致性状态。

Distro协议将数据分为多个blocks,每个Nacos集群节点负责一个block的数据处理,确保每个节点仅处理实例数据的一部分。同时,所有节点都会将数据同步到集群内其他节点。Distro协议的实现主要通过DistroProtocol类,包含sync方法,遍历除自身外的所有集群节点,封装Distro延迟任务DistroDelayTask,并通过任务引擎DistroTaskEngine进行执行。任务引擎的实现较为复杂,包括延迟任务处理器DistroDelayTaskProcessor,负责处理延迟任务。当将延迟任务添加到任务引擎中,DistroDelayTaskProcessor将根据任务类型执行相应的处理逻辑,如数据改变同步任务DistroSyncChangeTask。

DistroSyncChangeTask的run方法负责获取需要同步的数据,设置同步数据的类型,并进行临时实例数据的同步。如果同步失败或过程中发生异常,则进行重试处理,即将任务重新添加到任务执行引擎中。同步临时实例数据主要由DistroHttpAgent类的syncData方法负责,该方法通过HTTP请求将数据同步到其他节点。当其他节点接收到同步请求时,DistroController类的onSyncDatum方法处理同步过来的数据,首先验证数据是否为空,然后判断是否为临时实例数据,根据情况创建或更新服务实例,赚钱广告游戏源码并将数据传递给distroProtocol的onReceive方法处理。

在DistroProtocol的onReceive方法中,首先根据资源类型找到处理实例数据的处理器,然后调用DistroConsistencyServiceImpl处理器的processData方法处理数据,该方法负责反序列化数据,并调用onPut方法进行临时数据缓存并通知变更。

当Nacos集群中有新节点加入时,新节点需要从其他节点拉取全量数据。DistroProtocol初始化时,调用startDistroTask方法启动全量拉取数据任务。DistroLoadDataTask负责加载全量数据,通过load方法从远程加载数据,并在检测到加载完成或异常时进行相应的回调。服务启动时,新节点会等待服务地址和数据存储类型不为空,之后遍历数据存储类型,加载未完成的数据,处理全量数据。

综上所述,Nacos通过Distro一致性协议实现了集群间临时实例数据的同步,确保了注册中心的可用性和一致性。新节点加入时,通过全量拉取数据来更新集群状态,实现数据的一致性。

一文读懂,硬核 Apache DolphinScheduler3.0 源码解析

全网最全大数据面试提升手册!

一、DolphinScheduler设计与策略

了解DolphinScheduler,首先需要对调度系统有基础的了解,本文将重点介绍流程定义、流程实例、任务定义与任务实例。DolphinScheduler在设计上采用去中心化架构,集群中没有Master与Slave之分,提高系统的稳定性和可用性。

1.1 分布式设计

分布式系统设计分为中心化与去中心化两种模式,每种模式都有其优势与不足。中心化设计的高清桌面共享 源码集群中Master与Slave角色明确,Master负责任务分发与监控Slave健康状态,Slave执行任务。去中心化设计中,所有节点地位平等,无“管理者”角色,减少单点故障。

1.1.1 中心化设计

中心化设计包括Master与Slave角色,Master监控健康状态,均衡任务负载。但Master的单点故障可能导致集群崩溃,且任务调度可能集中于Master,产生过载。

1.1.2 去中心化设计

去中心化设计中,所有节点地位平等,通过Zookeeper等分布式协调服务实现容错与任务调度。这种设计降低了单点故障风险,但节点间通信增加了实现难度。

1.2 架构设计

DolphinScheduler采用去中心化架构,由UI、API、MasterServer、Zookeeper、WorkServer、Alert等组成。MasterServer与WorkServer均采用分布式设计,通过Zookeeper进行集群管理和容错。

1.3 容错问题

容错包括服务宕机容错与任务重试。Master容错依赖ZooKeeper,Worker容错由MasterScheduler监控“需要容错”状态的任务实例。任务失败重试需区分任务失败重试、流程失败恢复与重跑。

1.4 远程日志访问

Web(UI)与Worker节点可能不在同一台机器上,远程访问日志需要通过RPC实现,确保系统轻量化。

二、源码分析

2.1 工程模块介绍与配置文件

2.1.1 工程模块介绍

2.1.2 配置文件

配置文件包括dolphinscheduler-common、API、MasterServer与WorkerServer等。招募源码系统下载

2.2 API主要任务操作接口

API接口支持流程上线、定义、查询、修改、发布、下线、启动、停止、暂停、恢复与执行功能。

2.3 Quaterz架构与运行流程

Quartz架构用于调度任务,Scheduler启动后执行Job与Trigger。基本流程涉及任务初始化、调度与执行。

2.4 Master启动与执行流程

Master节点启动与执行流程涉及Quartz框架、槽(slot)与任务分发。容错代码由Master节点监控并处理。

2.5 Worker启动与执行流程

Worker节点执行流程包括注册、接收任务、执行与状态反馈。负载均衡策略由配置文件控制。

2.6 RPC交互

Master与Worker节点通过Netty实现RPC通信,Master负责任务分发与Worker状态监控,Worker接收任务与反馈执行状态。

2.7 负载均衡算法

DolphinScheduler提供多种负载均衡算法,包括加权随机、平滑轮询与线性负载,通过配置文件选择算法。

2.8 日志服务

日志服务通过RPC与Master节点通信,实现日志的远程访问与查询。

2.9 报警

报警功能基于规则筛选数据,并调用相应报警服务接口,如邮件、微信与短信通知。

本文提供了DolphinScheduler的核心设计与源码分析,涵盖了系统架构、容错机制、任务调度与日志管理等方面,希望对您的学习与应用有所帮助。

浅析源码 golang kafka sarama包(一)如何生产消息以及通过docker部署kafka集群with kraft

本文将深入探讨Golang中使用sarama包进行Kafka消息生产的过程,以及如何通过Docker部署Kafka集群采用Kraft模式。首先,我们关注数据的生产部分。

在部署Kafka集群时,我们将选择Kraft而非Zookeeper,通过docker-compose实现。集群中,理解LISTENERS的含义至关重要,主要有几个类型:

Sarama在每个topic和partition下,会为数据传输创建独立的goroutine。生产者操作的起点是创建简单生产者的方法,接着维护局部处理器并根据topic创建topicProducer。

在newBrokerProducer中,run()方法和bridge的匿名函数是关键。它们反映了goroutine间的巧妙桥接,通过channel在不同线程间传递信息,体现了goroutine使用的精髓。

真正发送消息的过程发生在AsyncProduce方法中,这是数据在三层协程中传输的环节,虽然深度适中,但需要仔细理解。

sarama的架构清晰,但数据传输的核心操作隐藏在第三层goroutine中。输出变量的使用也有讲究:当output = p.bridge,它作为连接内外协程的桥梁;output = nil则关闭channel,output = bridge时允许写入。

Zookeeper源码集群启动

Zookeeper集群启动分为两步,首先确定集群模式,然后启动集群。

在启动时,需调用org.apache.zookeeper.server.quorum.QuorumPeerMain#main方法,这是启动入口。

main方法初始化QuorumPeerMain对象,并加载配置文件。配置文件决定Zookeeper是单机模式还是集群模式。

在加载配置文件后,程序判断集群模式。在单机模式下,Zookeeper将直接启动并进入运行状态。在集群模式下,Zookeeper会进一步执行runFromConfig方法。

runFromConfig方法负责创建集群实例,确定角色分配(Leader、Follower、Observer)。每个实例独立运行,通过心跳机制保持状态同步。

Leader负责发起维护集群状态,处理写操作,将写操作广播至所有服务器。Follower直接处理读请求,将写请求转发给Leader。Observer与Follower类似,但无投票权。

在集群中,同一时间只有一个Leader,其它服务器扮演Follower或Observer角色。集群中的角色状态动态调整,确保高可用性。

通过以上步骤,Zookeeper成功启动集群,实现分布式系统中的主从复制与高可用性。

ZookeeperApach Curator 框架源码分析:初始化过程(一)Ver 4.3.0

Curator是由Netflix开源的一款用于简化Zookeeper客户端开发的工具,它提供了一套高级别API,使得开发者可以更简单易懂地实现分布式应用程序。Curator构建在Zookeeper原生客户端之上,提供了连接重试、异常处理、节点监听等常见功能,减轻了开发者的工作负担。Curator由多个模块组成,其中curator-framework和curator-recipes是最常用的部分,此外还提供了分布式锁等功能。

Curator的最新版本为5.X系列,不再支持ZK 3.4.X及之前的版本。主要的改动在5.X系列中,原因包括代码重构、API调整等,导致不兼容之前的版本。

Curator的下载地址可以通过Maven依赖管理或Apache官方网站获取。要开始使用Curator,需要搭建Zookeeper集群环境,详细部署过程可参考其他文章。

引入Curator依赖后,开发者可以使用CuratorFrameworkFactory构建实例,通过此实例连接Zookeeper集群并执行分布式操作,如分布式锁等。Curator内部实现了重试策略、连接管理等,使得操作更为便捷且稳定。

Curator提供了可重入锁(公平锁)的示例,开发者可以通过简单的代码实现分布式锁功能。初始化CuratorFramework实例的过程包括设置连接参数、构建实例、启动连接等步骤,内部会处理网络重连、异常处理等逻辑。

在Curator的初始化过程中,CuratorFrameworkImpl是核心类,它负责构建与Zookeeper集群的连接,并封装了一系列关键组件,如连接管理、异常检测、负载均衡等。CuratorZookeeperClient类负责Zookeeper客户端的封装和调用。

CuratorFrameworkImpl的启动过程涉及初始化连接状态管理器、启动客户端连接、执行后台操作等关键步骤。通过CAS操作确保线程安全,并在异常情况下自动重试连接。

连接状态管理器(ConnectionStateManager)负责维护连接状态并处理状态变更通知,确保在状态改变时能够及时通知到监听器。通知机制包括注册一次性监听器、注册CuratorListener和ConnectionStateListener,以及处理未处理的错误。

Curator的会话管理机制包括连接状态检查和重连策略,确保在连接断开后能够自动恢复连接。在状态变更时,连接状态管理器会通知所有注册的监听器,执行相应的回调逻辑。

Curator还提供了缓存机制,用于保存节点数据并在数据发生变化时进行更新。此外,Curator支持多次注册监听器,确保在连接断开后能够重新注册监听器,以避免丢失监听事件。

通过上述分析,Curator为开发者提供了高效、稳定的Zookeeper客户端实现,简化了分布式应用程序的开发过程。在实际应用中,开发者需要根据项目需求选择合适的版本和功能模块,以充分利用Curator提供的便利性。

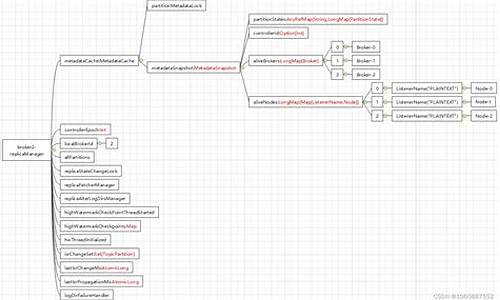

RocketMQ4.9.1源码分析-Namesrv服务注册&路由发现

路由中心在消息队列系统中的作用在于管理和提供路由信息,以简化消息的路由过程。在传统的模型中,生产者直接连接消息队列服务器,但随着集群扩展,需要更灵活的路由管理机制。路由中心引入,负责监控和管理集群中的实例,实现动态路由发现和实例状态感知。其核心功能包括实例注册、路由信息更新与实例状态监控。

路由中心通过心跳机制感知实例数量的变化,确保路由信息的实时更新。常见的路由中心系统包括zookeeper、consul和etcd,它们支持分布式系统中的服务发现和配置管理。

在RocketMQ中,Namesrv扮演着路由中心的角色,提供关键功能包括服务注册、路由信息管理和实例状态监控。Namesrv的核心在于保存和维护路由元信息,如topic、队列、broker地址等,并支持查询和更新操作。

在RocketMQ源码中,服务注册功能通过`processRequest()`方法实现,根据请求类型执行相应的逻辑。对于注册broker的请求,通过`registerBrokerWithFilterServer()`或`registerBroker()`方法处理,具体实现细节在源码中体现。注册流程涉及多个步骤,确保broker信息的正确记录和更新。

路由信息的删除主要涉及两种情况:broker正常停止或异常。当broker正常停止时,它会向Namesrv发送注销消息,Namesrv接收到此消息后,从相关数据结构中移除该broker的信息。当broker异常时,Namesrv通过心跳机制检测实例状态,并在超时后主动删除相关路由信息,以保持路由信息的准确性和实时性。

RocketMQ的设计中,Namesrv采用定时任务监控实例状态,通过发送心跳包或记录最后心跳时间,来检测异常实例并及时更新路由信息。这一机制确保了系统在实例动态变化时,能够高效地管理路由,提供稳定和可靠的消息传输服务。

通过上述描述和分析,可以清晰地了解到路由中心在消息队列系统中的重要作用,以及Namesrv在RocketMQ中如何实现关键功能以支持动态路由管理和实例状态监控。