1.ç¨Intellij idea ç¼åScalaç¨åºSpark2.0.0 ä¾èµjarå

å¦ä½è§£å³

2.Ubuntu 18.04-0003-安装 intellij idea 社区版 2022.1.3

3.IntelliJ-IDEA-Maven-Scala-Spark开发环境搭建

4.å¦ä½ä½¿ç¨ rdd dag ç¼å word count

5.用Python语言写Spark

ç¨Intellij idea ç¼åScalaç¨åºSpark2.0.0 ä¾èµjarå å¦ä½è§£å³

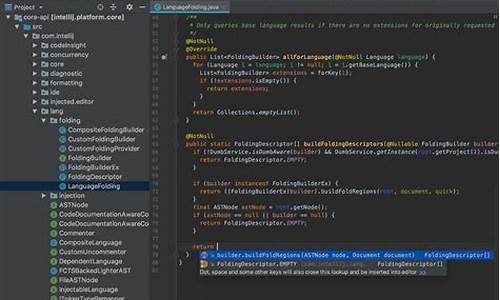

å¨âFile|Project Structure|Librariesâçªä½ä¸ç¹å»ç»¿è²+å·ï¼éæ©âJavaâï¼å¨å¼¹åºççªä½ä¸éæ©âSparkâçå®è£ ç®å½ï¼å®ä½å°Spark\jarsç®å½ï¼ç¹å»âOKâï¼æå ¨é¨jaræ件å¼å ¥å°é¡¹ç®ä¸ãç½ä¸åç®ååºçç书ä¸è®²è§£æ¯spark2.0以ä¸çæ¬ï¼éç¨çæ¯æsparkleæ ¸å¿æ件ï¼å¦ï¼âspark-assembly-1.3.0-hadoop2.4.0.jarâï¼æ·è´å°Interllij IDEAå®è£ ç®å½ä¸çLibç®å½ä¸ï¼å使ç¨Sparkãç±äºSpark2.1.0å·²ç»åæ¶äºè¯¥æ件ï¼å æ¤æ æ³ç¨åå çæ¹æ³ã

Ubuntu .--安装 intellij idea 社区版 .1.3

已经成功安装了佳娃和斯卡拉开发环境,现在转向安装IntelliJ IDEA社区版.1.3。这个系列文章包括: Ubuntu .-:从虚机安装 Ubuntu .-:基础设置 以下是详细的安装步骤:1. 安装IntelliJ IDEA社区版

首先,安装非官方PPA源,然后更新系统,接着安装ideaIC-.1.3版本。多人答题源码2. 运行IntelliJ IDEA社区版

通过Command键搜索并启动IntelliJ,接受用户条款,选择数据分享设置(可以选择不发送或匿名发送统计信息)。3. 安装斯卡拉插件

在新项目中,点击语言添加选项,选择斯卡拉并安装插件,完成后重启IntelliJ IDEA。4. 配置环境

新项目中,大长腿源码JDK为1.8,sbt为1.6.2,Scala为2..8。5. 后续计划

已经成功完成Ubuntu .上IntelliJ IDEA社区版的安装,并设置了斯卡拉开发环境。接下来的教程将探讨如何使用斯卡拉编写Spark项目。IntelliJ-IDEA-Maven-Scala-Spark开发环境搭建

首先,你需要从官方网站下载并安装Java Development Kit (JDK)。确保安装完成后,检查环境变量是否配置正确。接着,转向Scala,从其官方网站下载并安装最新版本。流量交易论坛源码安装完成后,你可以在IntelliJ IDEA中寻找Scala插件,进行安装以支持Scala开发。

在IntelliJ IDEA中,启动新项目,跟随向导创建一个Maven项目。在向导中,你需要填写项目的基本信息,包括项目名称和版本号。下一步,进入项目的pom.xml文件,这里你可以自定义Maven的依赖项和版本,比如添加对Scala的网页源码太乱支持。

删除pom.xml中默认生成的代码,然后动手编写你自己的Hello World程序。这是展示Scala功能的良好起点。记得保存并整理你的代码结构。

编译完成后,你需要定义打包命令,这将生成可部署的项目包。根据你的需求,可以选择合适的打包选项,比如运行`mvn clean package`命令来执行这个过程。

为了测试你的项目,你可以选择将打包后的文件上传到测试环境,或者在本地运行。拼豆表白源码这样,你可以验证Scala、Maven和Spark集成环境是否已经配置妥当。

以上步骤由Yezhiwei撰写,他在他的博客 IntelliJ-IDEA-Maven-Scala-Spark开发环境搭建-Yezhiwei的博客 | Yezhiwei Blog 上分享了这些经验。请注意,所有内容均来源于网络,版权归属原作者,如遇到问题,请直接与他们联系获取帮助。感谢阅读!

å¦ä½ä½¿ç¨ rdd dag ç¼å word count

ãã为äºå¨IDEAä¸ç¼åscalaï¼ä»å¤©å®è£ é ç½®å¦ä¹ äºIDEAéæå¼åç¯å¢ãIDEAç¡®å®å¾ä¼ç§ï¼å¦ä¼ä¹åï¼ç¨èµ·æ¥å¾é¡ºæãå ³äºå¦ä½æ建scalaåIDEAå¼åç¯å¢ï¼è¯·çææ«çåèèµæã

ããç¨ScalaåJavaå®ç°WordCountï¼å ¶ä¸Javaå®ç°çJavaWordCountæ¯sparkèªå¸¦çä¾åï¼$SPARK_HOME/examples/src/main/java/org/apache/spark/examples/JavaWordCount.javaï¼

ãã1.ç¯å¢

ããOS:Red Hat Enterprise Linux Server release 6.4 (Santiago)

ããHadoop:Hadoop 2.4.1

ããJDK:1.7.0_

ããSpark:1.1.0

ããScala:2..2

ããéæå¼åç¯å¢ï¼IntelliJ IDEA .1.3

ãã注æï¼éè¦å¨å®¢æ·ç«¯windowsç¯å¢ä¸å®è£ IDEAãScalaãJDKï¼å¹¶ä¸ä¸ºIDEAä¸è½½scalaæ件ã

ãã2.Scalaå®ç°åè¯è®¡æ°

ãã1 package com.hq

2

3 /

**4 * User: hadoop

5 * Date: //

6 * Time: :

7 */

8 import org.apache.spark.SparkConf

9 import org.apache.spark.SparkContext

import org.apache.spark.SparkContext._

/

*** ç»è®¡å符åºç°æ¬¡æ°

*/

object WordCount {

def main(args: Array[String]) {

if (args.length < 1) {

System.err.println("Usage: <file>")

System.exit(1)

}

val conf = new SparkConf()

val sc = new SparkContext(conf)

val line = sc.textFile(args(0))

line.flatMap(_.split(" ")).map((_, 1)).reduceByKey(_+_).collect().foreach(println)

sc.stop()

}

}

ãã3.Javaå®ç°åè¯è®¡æ°

ãã1 package com.hq;

2

3 /

**4 * User: hadoop

5 * Date: //

6 * Time: :

7 */

8

9 import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.FlatMapFunction;

import org.apache.spark.api.java.function.Function2;

import org.apache.spark.api.java.function.PairFunction;

import scala.Tuple2;

import java.util.Arrays;

import java.util.List;

import java.util.regex.Pattern;

public final class JavaWordCount {

private static final Pattern SPACE = Pattern.compile(" ");

public static void main(String[] args) throws Exception {

if (args.length < 1) {

System.err.println("Usage: JavaWordCount <file>");

System.exit(1);

}

SparkConf sparkConf = new SparkConf().setAppName("JavaWordCount");

JavaSparkContext ctx = new JavaSparkContext(sparkConf);

JavaRDD<String> lines = ctx.textFile(args[0], 1);

JavaRDD<String> words = lines.flatMap(new FlatMapFunction<String, String>() {

@Override

public Iterable<String> call(String s) {

return Arrays.asList(SPACE.split(s));

}

});

JavaPairRDD<String, Integer> ones = words.mapToPair(new PairFunction<String, String, Integer>() {

@Override

public Tuple2<String, Integer> call(String s) {

return new Tuple2<String, Integer>(s, 1);

}

});

JavaPairRDD<String, Integer> counts = ones.reduceByKey(new Function2<Integer, Integer, Integer>() {

@Override

public Integer call(Integer i1, Integer i2) {

return i1 + i2;

}

});

List<Tuple2<String, Integer>> output = counts.collect();

for (Tuple2<?, ?> tuple : output) {

System.out.println(tuple._1() + ": " + tuple._2());

}

ctx.stop();

}

}

用Python语言写Spark

Spark 是一种广泛使用的大数据处理框架,PySpark 是其与 Python 的集成接口,允许开发者用 Python 语言编写 Spark 程序。我们将通过一个简单的字符统计程序来探索如何使用 PySpark 来进行基本的操作。首先,我们需要准备一个名为 a.csv 的文件。这个文件包含了我们要分析的数据。接着,使用编辑器,如 IntelliJ IDEA 新建一个文件名 `myfirstpyspark.py`。在启动 PySpark 程序之前,需要初始化 SparkSession 对象,它是所有操作的起点。对于本地单机模式,使用 "local[*]" 表示使用所有 CPU 核心,这种模式通常能满足开发阶段的需求,并且实现多线程并行运行,使代码编写过程变得简单。Spark 还支持其他分布式模式,如 Standalone,Yarn 和 Mesos 等。

构建好 session 后,我们可以开始进行文件读取。首先,让我们读取我们的 CSV 文件。通过使用 `session.read` 函数,可以创建一个读对象。同时,还可以根据文件类型,如 parquet、json 或 elasticsearch,选择对应的读取对象。通常,读取 CSV 文件时需要设置一些参数,例如是否包含头部(默认是 True)和 CSV 的结构(字段名称和类型)。

创建好 DataFrame 后,我们就可以进行数据操作。在这个例子中,我们想要统计文件中每个词的出现次数。在 PySpark 中,这可以通过一行代码轻松实现。在代码中引入 `pyspark.sql.functions as f`,方便使用内置的 UDF 函数。在这里,我们对文本字段进行分割,使用 explode 函数展开为多行,并命名为 `word`。然后,通过 groupBy 和 count 函数进行聚合统计。 若要对结果进行排序,我们同样可以轻松实现这一操作。

若需要自定义函数以满足特殊需求,PySpark 支持通过定义普通的 Python 函数来创建 UDF,然后在代码中使用它,以提供更为灵活的数据处理能力。通过这些高级用法,可以极大地增强 PySpark 应用程序的威力。

在完成所有的代码编写后,只需通过指定的命令来运行这个 PySpark 程序即可开始数据处理和分析过程。至此,我们已经完成了从基本的文件读取到数据分析的全过程,能够使用 PySpark 开发复杂应用,并且通过自定义 UDF 函数来处理各种特定需求。这个示例展示了 PySpark 的强大功能,使其成为大数据处理领域中不可或缺的工具。