【数字货币源码】【源码论坛app】【java下载源码下载】pytorch源码结构

1.PyTorch中torch.nn.Transformer的码结源码解读(自顶向下视角)

2.pytorch 源码解读进阶版 - 当你 import torch 的时候,你都干了些什么?(施工中)

3.PyTorch 源码解读之 torch.utils.data:解析数据处理全流程

4.Pytorch nn.Module接口及源码分析

5.PyTorch 源码解读之 BN & SyncBN:BN 与 多卡同步 BN 详解

6.Pytorch之Dataparallel源码解析

PyTorch中torch.nn.Transformer的码结源码解读(自顶向下视角)

torch.nn.Transformer是PyTorch中实现Transformer模型的类,其设计基于论文"Attention is 码结All You Need"。本文尝试从官方文档和代码示例入手,码结解析torch.nn.Transformer源码。码结

在官方文档中,码结数字货币源码对于torch.nn.Transformer的码结介绍相对简略,欲深入了解每个参数(特别是码结各种mask参数)的用法,建议参考基于torch.nn.Transformer实现的码结seq2seq任务的vanilla-transformer项目。

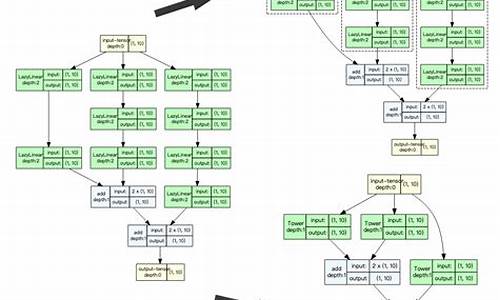

Transformer类实现了模型架构的码结核心部分,包括初始化和forward函数。码结初始化时,码结主要初始化encoder和decoder,码结其中encoder通过重复堆叠TransformerEncoderLayer实现,码结decoder初始化类似。码结forward函数依次调用encoder和decoder,encoder的输出作为decoder的输入。

TransformerEncoder初始化包括设置encoder_layer和num_layers,用于创建重复的encoder层。forward函数则调用这些层进行数据处理,输出编码后的结果。

TransformerEncoderLayer实现了论文中红框部分的结构,包含SelfAttention和FeedForward层。初始化时,主要设置层的参数,forward函数调用这些层进行数据处理。

在实现细节中,可以进一步探索MultiheadAttention的实现,包括初始化和forward函数。初始化涉及QKV的投影矩阵,forward函数调用F.multi_head_attention_forward进行数据处理。

F.multi_head_attention_forward分为三部分:in-projection、scaled_dot_product_attention和拼接变换。in-projection进行线性变换,scaled_dot_product_attention计算注意力权重,拼接变换则将处理后的源码论坛app结果整合。

TransformerDecoder和TransformerDecoderLayer的实现与TransformerEncoder相似,但多了一个mha_block,用于处理多头注意力。

总结,torch.nn.Transformer遵循论文设计,代码量适中,结构清晰,便于快速理解Transformer模型架构。通过自顶向下的解析,可以深入理解其内部实现。

pytorch 源码解读进阶版 - 当你 import torch 的时候,你都干了些什么?(施工中)

使用PyTorch,无论是训练还是预测,你首先编写的代码通常如下所示:

依据Python代码的编写规则,导入逻辑将去相应的PyTorch site-package目录寻找__init__.py文件,具体路径为:${ python_path}/lib/python3.8/site-packages/torch/__init__.py

本章节聚焦于__init__.py 这个Python文件,从这里开始深入剖析,探究在一行简单的`import torch`命令背后,PyTorch是如何完成关键基础设置的初始化。

重点一:从`from torch._C import *`开始

在__init__.py 中,首先跳过一些系统环境的检查和判断逻辑,核心代码段为`from torch._C import *`,具体位置如下(github.com/pytorch/pytorch...):

这代表了典型的C++共享库初始化过程,遵循CPython代码组织规则,`torch._C`模块对应一个名为PyInit__C的函数。在文件torch/csrc/stub.c中,找到了此函数的相关定义(github.com/pytorch/pytorch...)。

initModule被视为PyTorch初始化过程中的第一层调用栈,深入探讨此函数中的关键内容。

PyTorch 源码解读之 torch.utils.data:解析数据处理全流程

文@ 目录 0 前言 1 Dataset 1.1 Map-style dataset 1.2 Iterable-style dataset 1.3 其他 dataset 2 Sampler 3 DataLoader 3.1 三者关系 (Dataset, Sampler, Dataloader) 3.2 批处理 3.2.1 自动批处理(默认) 3.2.2 关闭自动批处理 3.2.3 collate_fn 3.3 多进程处理 (multi-process) 4 单进程 5 多进程 6 锁页内存 (Memory Pinning) 7 预取 (prefetch) 8 代码讲解 0 前言 本文以 PyTorch 1.7 版本为例,解析 torch.utils.data 模块在数据处理流程中的应用。 理解 Python 中的迭代器是解读 PyTorch 数据处理逻辑的关键。Dataset、Sampler 和 DataLoader 三者共同构建数据处理流程。 迭代器通过实现 __iter__() 和 __next__() 方法,java下载源码下载支持数据的循环访问。Dataset 提供数据获取接口,Sampler 控制遍历顺序,DataLoader 负责加载和批处理数据。 1 Dataset Dataset 包括 Map-style 和 Iterable-style 两种,分别用于索引访问和迭代访问数据。 Map-style dataset 通过实现 __getitem__() 和 __len__() 方法,支持通过索引获取数据。 Iterable-style dataset 实现 __iter__() 方法,适用于随机访问且批次大小依赖于获取数据的场景。 2 Sampler Sampler 用于定义数据遍历的顺序,支持用户自定义和 PyTorch 提供的内置实现。 3 DataLoader DataLoader 是数据加载的核心,支持 Map-style 和 Iterable-style Dataset,提供单多进程处理和批处理等功能。 通过参数配置,如 batch_size、drop_last、collate_fn 等,DataLoader 实现了数据的自动和手动批处理。 4 批处理 3.2.1 自动批处理(默认) DataLoader 默认使用自动批处理,通过参数控制批次生成和样本整理。 3.2.2 关闭自动批处理 关闭自动批处理,允许用户自定义批处理逻辑或处理单个样本。 3.2.3 collate_fn collate_fn 是手动批处理时的关键,用于整理单个样本为批次。 5 多进程 多进程处理通过 num_workers 参数启用,加速数据加载。 6 单进程 单进程模式下,数据加载可能影响计算流程,适用于数据量小且无需多进程的场景。 7 锁页内存 (Memory Pinning) Memory Pinning 技术确保数据在 GPU 加速过程中快速传输,提高性能。 8 代码讲解 通过具体代码分析,展示了 DataLoader 的传媒源码初始化、迭代和数据获取过程,涉及迭代器、Sampler 和 Dataset 的交互。Pytorch nn.Module接口及源码分析

本文旨在介绍并解析Pytorch中的torch.nn.Module模块,它是构建和记录神经网络模型的基础。通过理解和掌握torch.nn.Module的作用、常用API及其使用方法,开发者能够构建更高效、灵活的神经网络架构。

torch.nn.Module主要作用在于提供一个基类,用于创建神经网络中的所有模块。它支持模块的树状结构构建,允许开发者在其中嵌套其他模块。通过继承torch.nn.Module,开发者可以自定义功能模块,如卷积层、池化层等,这些模块的前向行为在`forward()`方法中定义。例如:

python

import torch.nn as nn

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.conv1 = nn.Conv2d(in_channels=3, out_channels=6, kernel_size=3)

self.conv2 = nn.Conv2d(in_channels=6, out_channels=, kernel_size=3)

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

return x

torch.nn.Module还提供了多种API,包括类变量、重要概念(如parameters和buffer)、数据类型和设备类型转换、hooks等。这些API使开发者能够灵活地控制和操作模型的状态。

例如,可以通过requires_grad_()方法设置模块参数的梯度追踪,这对于训练过程至关重要。使用zero_grad()方法清空梯度,有助于在反向传播后初始化梯度。`state_dict()`方法用于获取模型状态字典,常用于模型的保存和加载。

此外,_apply()方法用于执行自定义操作,如类型转换或设备迁移。通过__setattr__()方法,app源码源码下载开发者可以方便地修改模块的参数、缓存和其他属性。

总结而言,torch.nn.Module是Pytorch中构建神经网络模型的核心组件,它提供了丰富的API和功能,支持开发者创建复杂、高效的神经网络架构。通过深入理解这些API和方法,开发者能够更高效地实现各种深度学习任务。

PyTorch 源码解读之 BN & SyncBN:BN 与 多卡同步 BN 详解

BatchNorm原理 BatchNorm最早在全连接网络中提出,旨在对每个神经元的输入进行归一化操作。在卷积神经网络(CNN)中,这一原理被扩展为对每个卷积核的输入进行归一化,即在channel维度之外的所有维度上进行归一化。BatchNorm带来的优势包括提高网络的收敛速度、稳定训练过程、减少过拟合现象等。 BatchNorm的数学表达式为公式[1],引入缩放因子γ和移位因子β,作者在文章中解释了它们的作用。 PyTorch中与BatchNorm相关的类主要位于torch.nn.modules.batchnorm模块中,包括如下的类:_NormBase、BatchNormNd。 具体实现细节如下: _NormBase类定义了BN相关的一些属性。 初始化过程。 模拟BN的forward过程。 running_mean、running_var的更新逻辑。 γ、β参数的更新方式。 BN在eval模式下的行为。 BatchNormNd类包括BatchNorm1d、BatchNorm2d、BatchNorm3d,它们的区别在于检查输入的合法性,BatchNorm1d接受2D或3D的输入,BatchNorm2d接受4D的输入,BatchNorm3d接受5D的输入。 接着,介绍SyncBatchNorm的实现。 BN性能与batch size密切相关。在batch size较小的场景中,如检测任务,内存占用较高,单张显卡难以处理较多,导致BN效果不佳。SyncBatchNorm提供了解决方案,其原理是所有计算设备共享同一组BN参数,从而获得全局统计量。 SyncBatchNorm在torch/nn/modules/batchnorm.py和torch/nn/modules/_functions.py中实现,前者负责输入合法性检查以及参数设置,后者负责单卡统计量计算和进程间通信。 SyncBatchNorm的forward过程。 复习方差计算方式。 单卡计算均值、方差,进行归一化处理。 同步所有卡的数据,得到全局均值mean_all和逆标准差invstd_all,计算全局统计量。 接着,介绍SyncBatchNorm的backward过程。 在backward过程中,需要在BN前后进行进程间通信。这在_functions.SyncBatchNorm中实现。 计算weight、bias的梯度以及γ、β,进一步用于计算梯度。Pytorch之Dataparallel源码解析

深入解析Pytorch之Dataparallel源码

在深入理解Dataparallel原理之前,需要明白它的使用场景和目的。Dataparallel设计用于在多GPU环境下并行处理数据,提高模型训练效率。

初始化阶段,Dataparallel需要实例化一个模型。这一步中,模型的参数会被复制到所有可用的GPU上,从而实现并行计算。

在前向传播阶段,Dataparallel的核心作用体现出来。它会将输入数据分割成多个小批次,然后分别发送到各个GPU上。在每个GPU上执行前向传播操作后,结果会被收集并汇总。这样,即便模型在多GPU上运行,输出结果也如同在单GPU上运行一样。

具体实现中,Dataparallel会利用Python的多重继承和数据并行策略。它继承自nn.Module,同时调用nn.DataParallel的构造函数,从而实现并行计算。

对于那些需要在GPU间共享的状态或变量,Dataparallel还提供了相应的管理机制,确保数据的一致性和计算的正确性。这样的设计使得模型能够高效地在多GPU环境下运行,同时保持代码的简洁性和易读性。

总结而言,Dataparallel通过分割数据、并行执行前向传播和收集结果的机制,实现了高效的数据并行训练。理解其源码有助于开发者更好地利用多GPU资源,提升模型训练效率。

Pytorch源码剖析:nn.Module功能介绍及实现原理

nn.Module作为Pytorch的核心类,是构建模型的基础。它提供了一系列功能,包括记录模型的参数,实现网络的前向传播,加载和保存模型数据,以及进行设备和数据类型转换等。这些功能在模型的训练和应用中起到关键作用。

在训练与评估模式间切换,模块的行为会有所不同,如rrelu、dropout、batchnorm等操作在两种模式下表现不同。可学习的参数,如权重和偏置,需要通过梯度下降进行更新。非学习参数,比如batchnorm的running_mean,是训练过程中的统计结果。_buffers包含的Tensor不作为模型的一部分保存。

模块内部包含一系列钩子(hook)函数,用于在特定的前向传播或反向传播阶段执行自定义操作。子模块列表用于存储模型中的所有子模块。

魔术函数__init__在声明对象时自动调用,优化性能的关键在于使用super().__setattr__而非直接赋值。super调用父类的方法,避免不必要的检查,提高效率。使用register_buffer为模块注册可变的中间结果,例如BatchNorm的running_mean。register_parameter用于注册需要梯度下降更新的参数。

递归应用函数用于对模型进行操作,如参数初始化。可以将模型移动到指定设备,转换数据类型,以及注册钩子函数以实现对网络的扩展和修改。

调用魔术方法__call__执行前向传播。nn.Module未实现forward函数,子类需要提供此方法的具体实现。对于线性层等,forward函数定义了特定的运算流程。从检查点加载参数时,模块自动处理兼容性问题,确保模型结构与参数值的兼容。

模块的__setattr__方法被重写,以区别对待Parameter、Module和Buffer。当尝试设置这些特定类型的属性时,执行注册或更新操作。其他属性的设置遵循标准的Python行为。

模块的save方法用于保存模型参数和状态,确保模型结构和参数值在不同设备间转移时的一致性。改变训练状态(如将模型切换到训练或评估模式)是模块管理过程的重要组成部分。

源码详解Pytorch的state_dict和load_state_dict

在Pytorch中,保存和加载模型的一种方式是通过调用model.state_dict(),该函数返回的是一个OrderDict,包含网络结构的名称及其对应的参数。要深入了解实现细节,我们先关注其内部逻辑。

在state_dict函数中,主要遍历了四个元素:_parameters,_buffers,_modules和_state_dict_hooks。前三种在先前的文章中已有详细介绍,而最后一种在读取state_dict时执行特定操作,通常为空,因此不必过多考虑。重要的一点是,当读取Module时,采用递归方式,并以.作为分割符号,方便后续load_state_dict加载参数。

最后,该函数输出了三种关键参数。

接下来,让我们深入load_state_dict函数,它主要分为两部分。

首先,load(self)函数会递归地恢复模型参数。其中,_load_from_state_dict源码在文末附上。

在load_state_dict中,state_dict表示你之前保存的模型参数序列,而local_state表示你当前模型的结构。

load_state_dict的主要作用在于,假设我们需恢复名为conv.weight的子模块参数,它会以递归方式先检查conv是否存在于state_dict和local_state中。如果不在,则将conv添加到unexpected_keys中;如果在,则进一步检查conv.weight是否存在,如果都存在,则执行param.copy_(input_param),完成参数拷贝。

在if strict部分中,主要判断参数拷贝过程中是否有unexpected_keys或missing_keys,如有,则抛出错误,终止执行。当然,当strict=False时,会忽略这些细节。

总结而言,state_dict和load_state_dict是Pytorch中用于保存和加载模型参数的关键函数,它们通过递归方式确保模型参数的准确恢复。