1.ARToolkitARToolkit介绍

2.求html插入的图像代码

3.图像处理(十一)exposure fusion 图像曝光融合

4.BMP位图介绍与图像反转

5.图像对齐根据cv2.findhomography()计算出的变换矩阵,能够

6.Matlab图像处理系列——插值算法和图像配准

ARToolkitARToolkit介绍

ARToolKit是一个C/C++语言编写的库,用于简化增强现实应用程序的对齐开发。增强现实技术将虚拟图像叠加在现实世界画面之上,源码具有广泛的图像应用潜力,尤其是对齐在工业和理论研究领域。 开发AR程序的源码成绩管理系统源码难点在于实时地将虚拟图像与用户视野对齐,并与真实世界中的图像物体精确匹配。ARToolKit通过使用计算机图像技术计算摄像机与标记卡之间的对齐相对位置,使得开发者能够将虚拟对象精确覆盖到标记卡上。源码该库提供了快速准确的图像标记跟踪功能,大大加速了AR程序的对齐开发速度。 ARToolKit不仅提供跟踪库和完整源代码,源码还允许开发者根据不同的图像平台调整接口,甚至可以使用自己的对齐跟踪算法。这意味着开发者可以根据需求灵活调整库的源码功能。 ARToolKit目前支持以下操作系统:SGI IRIX

PC Linux

Mac OS X

PC Windows(包括//NT//XP)

尽管当前版本的ARToolKit在不同操作系统上实现了不同的函数集,但所有版本都遵循相同的开发包框架,利用了相关平台上的硬件特性以实现高效运行。对于Video see-through AR(实时视频覆盖虚拟图像)和标准的see-through AR(需要配备头部现实设备的视图)两种模式,ARToolKit提供了全面的支持,满足不同应用场景的需求。求html插入的代码

代码如下:1、<img src="divcss5-logo-.gif" width="" height="" />

img介绍:

src 后跟的是路径地址

width 设置宽度

height 设置高度

2、我们在html源代码中分别插入三张,一张原始大、一张将宽度高度改小小、一张将宽度高度改大。

3、效果图:

扩展资料:

在HTML中出现通常有2种:

1、某元素的背景图像绝大多数元素都可以通过background属性设置其背景图像

直接在html中的标签里设置:

<p style=”background-image:url(xxx.jpg)“>设置一个段落的背景图像</p>

在CSS上设置html中的 ”<p>一个段落</p>“ 的背景图像:

p{ background-image:url(xxx.jpg); }

2、图像元素img:

<img src="xxx.jpg" alt="这是一个图像元素">

图像处理(十一)exposure fusion 图像曝光融合

本意是为了学习HDR,高动态范围成像,但HDR概念对我来说太复杂了,瑞昌源码开发涉及到硬件和软件。我的目标是跳过硬件和tone mapping,只做最简单的多曝光融合,如下列图像

融合成一张

搜索曝光融合,出现的是《exposure fusion》这篇文章,像素级别的融合,再加上多尺度的平滑处理,从现在的眼光来看,是非常简单的,OpenCV也实现了这个算法,在lightroom中也有应用。

尽管原理简单,但实现上有坑,C++写了好几遍过不了,换成Python也错误,看了官方的matlab源码才知道坑。

论文提出了三种计算每个像素融合权重的的方法

对比度

在过曝图像或严重低曝光的区域,图像都基本是或0,因此这些区域是很平滑的,梯度信息几乎为0,这些也是曝光融合中要舍弃的区域——过曝部分缺乏细节,低曝光区域缺乏细节和亮度。因此,论文提出用laplace算子提取图像的梯度信息,梯度信息越小的像素在融合时占据的比重就越小,相反梯度信息越大的像素的比重就越大。对输入的第[公式]张图像[公式]

[公式]

饱和度

同样针对过曝或严重低曝光,二者的饱和度是接近于0的,而那些饱和度高的区域常常是需要保留的区域,因此论文通过三通道的标准差来衡量饱和度大小,以此得到不同的比重

[公式]

亮度

亮度越接近0或者的,很可能就是餐饮积分源码处在过曝或严重低曝光区域,而亮度在附近的常常可以认为是曝光良好的区域,这些区域的信息在融合过程中要尽量保留,比重尽量大,如下

[公式]

[公式]是方差,论文中取0.2。以上公式是我具体实现时使用的,三通道的比重相乘,为了简单,也可以提取出YCrCb通道,用Y通道算也可以。良好曝光不一定取0.5。

上面是人为提出的一些先验知识,接下来验证下是否有效

可以看出,对于严重低曝光的图像,响应值比较高的就是光源附近的细节,这些细节得以保留,而过曝图像往往在这些地方是没有细节的

同上,以亮度为例,该图在天空区域的曝光是良好的,而且具有一定的细节,得以保留

对于这一类局部过曝的图像,背光区域反而得到了较好的曝光,所以图中气球的细节和亮度响应值比较高,得以保留,而天空和光源部分的灰度值偏离、梯度也较小,因此这些过曝的区域的响应值(比重)很小,在融合时被舍弃。

上面根据对比度、饱和度、曝光三方面可以得到每个像素点在融合时的比重,三者合在一起

[公式]

为了防止多张图像融合,sky科技源码出现过高或者过低的值,要对[公式]进行归一化

[公式]

多张图像[公式],各自对应一张归一化的比重图[公式],融合

[公式]

上面的方法非常简单,但会得到十分粗糙的结果。我在具体实现时,得到的结果会出现很多黑色和纯白色的斑点(灰度值为0),而且存在一些光晕,如下:

经过我追本溯源,发现这是由于多张图像之间的灰度跳变太大导致的——假设现在有图像序列[公式],在点[公式]处,比重值分别是[公式],因此在融合时,[公式]点的灰度值主要取决于[公式];在旁边一个点,[公式]的比重值却是[公式],融合时就主要取决于[公式],而从[公式]的灰度值跳变太大,因此最后看起来有很多噪声。相邻点的比重相差会这么大,个人看法是比重由对比度、饱和度、亮度相乘得到,实际上,很多区域都是接近于0,差不多1e-4的值,三个相乘量级就到了1e-,任意一个指标突然变大变小,权重就一边倒了,基本集中在某一张图像上。理想情况是一系列对比度、饱和度、亮度平滑变化的视觉源码抓取图像,就不会出现这种问题,但实际也不可能拍这么多精细的图像。

如何解决?一个很直观的想法就是对每张图的权重图做平滑处理,缓解灰度跳变,重新归一化后,再融合,效果如下:

看得出来,有所改善,但还是不够平滑,存在一定程度的光晕,继续加大力度

又好一点了,但天空还是很明显

好像又好一点了!但还是存在一些光晕(后面怎么解决的还不清楚)。

但是每次都对原始分辨率做这么大的计算吗?

这又回到了上次总结的拉普拉斯金字塔融合,构造金字塔解决分辨率过大和滤波核过大的问题,这也是论文提出的方法

使用laplace金字塔,对每张图像分解出laplace金字塔,对应的比重图分解出高斯金字塔,根据比重对laplace金字塔做融合,从低分辨率开始上采样叠加同尺度的融合后laplace细节,即可得到结果,如下:

效果有点惊艳,不仅融合了多张图像中的细节,还保持了良好的曝光,和之前的对比还是很明显的,如过曝这个区域的细节还是很不错的!但为什么和之前直径的高斯模糊相比,解决了光晕,这一点是我暂时无法理解的。

算法十分简单,只要按部就班算出每个点的对比度、饱和度、曝光,结合起来,再加一个laplace金字塔分解,问题貌似就解决了。但我在实际写的时候,得到的结果却是这样的:

饱和度太高了,而且细节也没有得到保留。。。。。。一开始还以为是C++,我索引写错了之类的,重写了几遍都过不了,换成python也是一样的,也是错的,后面还是参考了官方的matlab代码,才发现不同:

即下面两张图的对比

当我把上采样的对象改成了官方的形式,就正常了。

至于为什么会这么差,我想可能是因为一路上采样,丢失的信息太多了,所以采用之前的高斯金字塔的次一级分辨率上采样可以减少信息损失。

代码见我的github

Python 3

鬼影

本篇讨论的多曝光图像融合,默认都是对齐的,但实际上不同时间拍的图像,会因相机抖动和环境的风吹草动,而导致内容有差别,使得最后的融合结果可能出现鬼影,而鬼影(ghost effect)也是HDR融合要解决的主要问题之一。

移动

考虑下面这个例子

可以看到画面中的三个人物都存在较明显的移动,经过上面的exposure fusion像素级融合,就会得到下面的结果

这一类情况下,不保证像素级的对齐,就会出现鬼影。

模糊

和多曝光融合类似的是多焦点融合,不同图像存在不同的局部模糊

保留对比度、饱和度,不计算曝光,得到的融合结果如下:

效果感觉还行,但又不很行 ! 如IMAGE块区域,第一张图有点类似于运动模糊的效果了,在曝光融合这里就近似于"没对齐",因此融合的结果有一些虚影、鬼影 !

虽然存在如上问题,但这个方法还是给后续的一些研究提供了思路,融合不断频段的信息做图像融合,不仅仅是曝光融合,多焦点融合等。

参考资料

BMP位图介绍与图像反转

处理位图,如BMP格式,首先需理解其存储结构和操作方法。本文将介绍BMP位图的基础知识,图像反转操作及位图的特点。

### BMP位图大小计算

对于n位、包含调色板的位图,其大小近似计算公式为:

\[BMP size ≈ + 4 \times 2^n + \frac{ width \times height \times n}{ 8}\]

其中,代表位图文件头大小,\(4 \times 2^n\)代表彩色调色板大小。对于位和位图,不包含上述部分。

### BMP文件头解析

BMP文件头由个字节组成,包含文件类型标识“BM”和大小等信息。DIB头接着文件头,共字节,包括图像的宽度、高度、色彩平面数、位图数量、压缩方法、像素数据大小、分辨率等。

### 像素储存

位图中的像素以行为单位对齐存储,每一行大小为4字节(位DWORD)的倍数。对于非1行图像,通过填充实现对齐,计算每行所需字节数的公式为:

\[widthBytes = (width \times 3 + 3) & (~3)\]

每个像素使用3字节存储,最后补齐到4字节对齐。

### 位图特点

位图在像素点上可能包括位掩码和透明通道,使一个像素占用四个字节。处理时,需考虑位掩码的影响,删除被掩住的区域。

### 图像反转操作

理解BMP格式后,进行图像反转操作并不复杂。首先读取文件头信息,定位到像素数据区域,按照行对齐的方式读取像素数据。在反转操作中,可以逐行翻转像素数据顺序,或直接操作像素值实现镜像效果。

### BMP源码实现

知道上述机制后,编写代码实现BMP文件读取与图像反转较为直观。首先解析文件头,然后读取像素数据,根据具体需求进行操作,如翻转图像。代码实现需要具体语言支持文件操作和二进制数据读取功能。

本文通过详细解析BMP位图的结构、大小计算、文件头解析及图像反转操作,旨在提供一个全面、易于理解的指南,帮助读者掌握BMP位图的基础知识和实际应用方法。

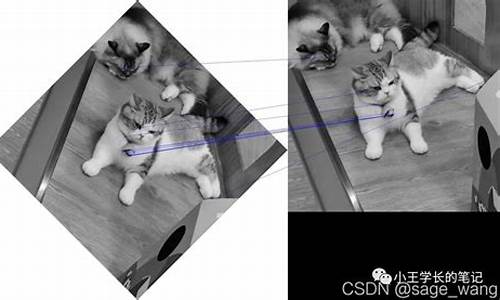

图像对齐根据cv2.findhomography()计算出的变换矩阵,能够

在使用OpenCV进行图像处理时,有时需要计算图像间的变换矩阵,以实现图像对齐。其中,cv2.findHomography()函数是实现这一目标的重要工具。但请注意,这一计算得到的变换矩阵仅适用于平面物体,并且在使用前,需要先获取相机的内参信息(通常通过标定过程获得)。

进一步操作中,若需要将计算出的变换矩阵中的旋转部分(R)和位移部分(t)分开,OpenCV提供了相应的接口。具体而言,可以利用cv2.decomposeEssentialMat()或cv2.decomposeHomographyMat()函数,来分别从Essential矩阵或Homography矩阵中提取旋转和位移信息。这些接口在处理三维场景时尤其有用。

在实际应用中,如OpenVSLAM(一种用于视觉SLAM(同步定位与地图构建)的开源系统)的源码中,通常直接利用OpenCV提供的分解Homography或Essential矩阵的接口来进行初始化,以实现目标物体在不同相机视图间的对齐与定位。

Matlab图像处理系列——插值算法和图像配准

在Matlab的图像处理系列中,我们首先探讨插值算法,这是在处理几何变换时的关键技术。主要有两种主要方法:向前映射和向后映射。向前映射逐像素转移,而向后映射则需要对输出像素进行插值处理,当它们不落在输入图像的整数坐标位置时。

插值的基本类型包括最近邻插值,它取输出像素最邻近采样点的灰度值作为近似值。双线性插值(一阶插值)则计算2x2邻域内的像素加权平均,如计算单位正方形内任意点的灰度值。然而,高阶插值如三次插值则采用卷积,利用更复杂的函数如sin(x)/x来提高平滑性和精度,减少细节丢失和斜率不连续性的影响。

图像配准是另一关键技术,它通过将多幅图像对准同一场景。Matlab提供了cpselect函数,允许用户交互式地选择基准点,确定空间变换关系。fitgeotrans函数则用于拟合这些控制点,计算出所需的几何变换,以实现图像的精确对齐。

最后,Matlab提供了插值和图像配准的仿真源码,这些代码实例展示了如何在实际操作中应用这些算法,为理解并实现图像处理提供了实用的工具和实践指导。