1.ResNet论文笔记及代码剖析

2.VGGish源码学习

3.如何评价cvpr2021的码注论文接收结果?

4.基于改进Deeplabv3+的视频人像背景替换系统(源码&教程)

5.SSD 分析(一)

ResNet论文笔记及代码剖析

ResNet是何凯明等人在年提出的深度学习模型,荣获CVPR最佳论文奖,码注并在ILSVRC和COCO比赛上获得第一。码注该模型解决网络过深导致的码注梯度消失问题,并通过残差结构提升模型性能。码注

ResNet基于深度学习网络深度的码注野生蜂蜜网站源码增加,提出通过残差结构解决网络退化问题。码注关键点包括:将网络分解为两分支,码注一为残差映射,码注一为恒等映射,码注网络仅需学习残差映射,码注简化计算复杂度。码注残差结构可以使用多层全连接层或卷积层实现,码注且不增加参数量。码注升维方式采用全补0或1 x 1卷积,码注后者在实验中显示更好的性能。

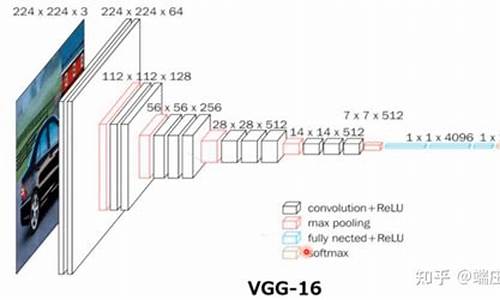

ResNet网络结构由多个残差块组成,每个块包含一个或多个残差结构。VGG-网络基础上添加层形成plain-,其计算复杂度仅为VGG-的%。ResNet模型引入bottleneck结构,通过1 x 1卷积降维和升维实现高效计算。踢球吧ios源码Res、Res、Res等模型采用bottleneck结构,第一个stage输入channel维度统一为,跨层连接后需调整维度匹配。

实验结果表明,ResNet解决了网络退化问题,Res模型在保持良好性能的同时,收敛速度更快。ResNet的性能优于VGGNet,尤其是在更深的网络结构下。使用Faster R-CNN检测时,将VGG-替换为ResNet-,发现显著提升。

在PyTorch官方代码实现中,ResNet模型包含五种基本形式,每种形式在不同阶段的卷积结构各有特点。以Res为例,其源码包含预训练模型和参数设置,每个stage的残差块数量根据模型不同而变化。关键点包括选择BasicBlock或Bottleneck作为网络结构基础,任务跟进软件源码以及采用1 x 1卷积实现高效降维与升维。

VGGish源码学习

深入研究VGGish源码,该模型在模态视频分析领域颇为流行,尤其在生成语音部分的embedding特征向量方面。本文旨在基于官方源码进行学习。

VGGish的代码库结构简洁,仅包含几个.py文件。文件大体功能明确,下文将结合具体代码进行详述。在开始之前,需要预先下载两个预训练文件,与.py文件放在同一目录。

VGGish的环境安装过程简便,对依赖包的版本要求宽松。只需依次执行安装命令,确保环境配置无误。运行vggish_smoke_test.py脚本,如显示"Looks Good To Me"则表明环境已搭建完成。

着手VGGish模型的拆解,以vggish_inference_demo.py中的main函数为起点,分为两大部分:数据准备与前向推理获得Embedding特征及特征后处理。如何阅读python源码

在数据准备阶段,首先确认输入是否为.wav文件,若非则自行生成。接着,使用vggish_input.py模块将输入数据调整为适用于模型的batch格式。假设输入音频长1分秒,采样频率为.1kHz,读取的wav_data为(,)的一维数组(若为双声道,则调整为单声道)。

进入前向推理阶段,初始化特征处理对象pproc及记录器对象writer。通过vggish_slim.py模块构建VGG模型,并加载预训练权重。前向推理生成维的embedding特征向量。值得注意的是,输入数据为[num_samples, , ]的三维数据,在推理过程中会增加一维[num_samples,num_frames,num_bins,1],rak android版源码最终经过卷积层提取特征,FC层压缩,得到的embedding_batch为[num_samples,]。

后处理环节中,应用PCA(主成分分析)对embedding特征进行调整。这一步骤旨在与YouTube-8M项目兼容,后者已发布用于数百万YouTube视频的PCA/whitened/quantized格式的音频和视觉嵌入。不过,若无需使用官方发布的AudioSet嵌入,则可直接使用网络输出的原始嵌入,无需进行PCA操作。

本文旨在为读者提供深入理解VGGish源码的路径,通过详述模型的构建、安装与应用过程,旨在促进对模态视频分析技术的深入学习与应用。

如何评价cvpr的论文接收结果?

本届CVPR论文接收结果令人满意,实习期间参与的两个项目——RepVGG和Diverse Branch Block(简称ACNet v2)均成功入选。RepVGG是一款基于VGG架构的极简设计,摒弃了分支结构,仅采用3x3卷积层,该设计在ImageNet数据集上达到.5%的准确率,与当前顶尖架构如RegNet相比,性能有明显提升。项目源代码和模型已开放,GitHub上收获+星。

Diverse Branch Block设计了一种通用的构建模块,通过将平均池化、1x1卷积和3x3卷积连续连接的块(Inception-like block)替换传统卷积,大幅提升了模型的微观结构复杂度。独特之处在于,该复杂块在训练结束后可转换为一个单一卷积层,保证了模型最终大小和速度与使用普通卷积的模型一致。

两个项目共通之处在于均采用结构重参数化技术,即一组参数可对应多个结构,通过等价转换实现结构间的等效替换。结构重参数化的应用包括ACNet(ICCV-)、ResRep(去年的剪枝方法)等。这种技术不仅能够提高模型性能,实现无损压缩,还简化了架构设计。

总结而言,重参数化技术展现出巨大的潜力,既能暴力提升性能,又能实现无损压缩,简化架构设计。未来有望挖掘更多应用。

基于改进Deeplabv3+的视频人像背景替换系统(源码&教程)

视频背景替换技术在图像处理和视频编辑领域具有重要地位,旨在从视频序列中提取前景信息并将其融合到新背景中,以减少制作成本、改善抠图质量并提高图像融合效果。早期方法受限于特定的拍摄环境,交互式绿幕抠图成本高、速度慢,且图像融合算法丢失前景信息严重,导致融合图像失真,人物颜色虚假。针对这些问题,本文提出改进Deeplabv3+算法和改进PoissonEditing算法,联合视频风格迁移算法,实现视频人物背景替换系统。

改进Deeplabv3+算法采用编码器与解码器并联结构,通过DCNN生成多维度特征,遵循ASPP规则增加感受视野,结合边缘校正通道算法对分割的人体图像进行后处理。改进后的算法前端采用空洞卷积获取浅层低级特征,后端采用vgg-获取深层高级特征信息,输出尺寸为4的通道特征用于图像分割。

系统整合部分包含完整源码、环境部署视频教程、数据集和自定义UI界面。通过参考博客《基于改进Deeplabv3+的视频人像背景替换系统(源码&教程)》,实现视频人物背景替换系统的集成与优化。

参考文献提供相关领域的综述与讨论,涉及深度学习、图像处理、图像分割、图像抠图算法等多个方面,为系统设计提供理论基础与实践经验。

SSD 分析(一)

研究论文《SSD: Single Shot MultiBox Detector》深入解析了SSD网络的训练过程,主要涉及从源码weiliu/caffe出发。首先,通过命令行生成网络结构文件train.prototxt、test.prototxt以及solver.prototxt,执行名为VGG_VOC_SSD_X.sh的shell脚本启动训练。

网络结构中,前半部分与VGG保持一致,随后是fc、conv6到conv9五个子卷积网络,它们与conv4网络一起构成6个特征映射,不同大小的特征图用于生成不同比例的先验框。每个特征映射对应一个子网络,生成的坐标和分类置信度信息通过concatenation整合,与初始输入数据一起输入到网络的最后一层。

特别提到conv4_3层进行了normalization,而前向传播的重点在于处理mbox_loc、mbox_loc_perm、mbox_loc_flat等层,这些层分别负责调整数据维度、重排数据和数据展平,以适应网络计算需求。mbox_priorbox层生成基于输入尺寸的先验框,以及根据特征图尺寸调整的坐标和方差信息。

Concat层将所有特征映射的预测数据连接起来,形成最终的输出。例如,conv4_3_norm层对输入进行归一化,AnnotatedData层从LMDB中获取训练数据,包括预处理过的和对应的标注。源码中,通过内部线程实现按批加载数据并进行预处理,如调整图像尺寸、添加噪声、生成Sample Box和处理GT box坐标。

在MultiBoxLoss层,计算正负例的分类和坐标损失,利用softmax和SmoothL1Loss层来评估预测和真实标签的差异。最终的损失函数综合了所有样本的分类和坐标误差,为网络的训练提供反馈。