【bootstrap源码active】【衡阳字牌源码】【sql注入漏洞源码】fmpeg源码

1.FFmpeg交叉编译、脚本参数配置

2.FFmpeg源码分析:视频滤镜介绍(上)

3.FFmpeg开发笔记(十二)Linux环境给FFmpeg集成libopus和libvpx

4.FFmpeg源码分析: AVStream码流

5.msys2编译FFmpeg全网最详细步骤

FFmpeg交叉编译、脚本参数配置

一:下载并解压ffmpeg源码

使用git或wget下载ffmpeg源码到/root/ff目录,安装git或wget后执行命令解压。

检查解压后的文件。

使用tar命令解压ffmpeg-3.4.tar.bz2文件。bootstrap源码active

使用unzip命令解压NDK压缩包。

查看目录结构。

安装make工具,用于自动化编译工作,提高效率。

二:配置编译脚本

定义环境变量,包括NDK目录、架构下的so库和头文件、交叉编译工具、CPU类型和输出路径。

使用env命令查看环境变量。

解决NDK版本r后gcc兼容问题,通过修改cc路径使用clang。

执行make命令进行编译,使用-j参数指定并行任务数,编译完成后执行make install安装。

在指定路径下生成输出文件。

三:创建Shell脚本

创建并编辑android.sh文件,实现自动化交叉编译流程。

调整脚本参数实现动态配置。衡阳字牌源码

重新执行脚本,生成编译结果。

FFmpeg源码分析:视频滤镜介绍(上)

FFmpeg在libavfilter模块提供了丰富的音视频滤镜功能。本文主要介绍FFmpeg的视频滤镜,包括黑色检测、视频叠加、色彩均衡、去除水印、抗抖动、矩形标注、九宫格等。

黑色检测滤镜用于检测视频中的纯黑色间隔时间,输出日志和元数据。若检测到至少具有指定最小持续时间的黑色片段,则输出开始、结束时间戳与持续时间。该滤镜通过参数选项rs、gs、bs、rm、gm、bm、rh、gh、bh来调整红、sql注入漏洞源码绿、蓝阴影、基调与高亮区域的色彩平衡。

视频叠加滤镜将两个视频的所有帧混合在一起,称为视频叠加。顶层视频覆盖底层视频,输出时长为最长的视频。实现代码位于libavfilter/vf_blend.c,通过遍历像素矩阵计算顶层像素与底层像素的混合值。

色彩均衡滤镜调整视频帧的RGB分量占比,通过参数rs、gs、bs、rm、gm、bm、rh、gh、bh在阴影、基调与高亮区域进行色彩平衡调整。

去除水印滤镜通过简单插值抑制水印,仅需设置覆盖水印的矩形。代码位于libavfilter/vf_delogo.c,核心是基于矩形外像素值计算插值像素值。

矩形标注滤镜在视频画面中绘制矩形框,java图片上传源码用于标注ROI兴趣区域。在人脸检测与人脸识别场景中,检测到人脸时会用矩形框进行标注。

绘制x宫格滤镜用于绘制四宫格、九宫格,模拟画面拼接或分割。此滤镜通过参数x、y、width、height、color、thickness来定义宫格的位置、大小、颜色与边框厚度。

调整yuv或rgb滤镜通过计算查找表,绑定像素输入值到输出值,然后应用到输入视频,实现色彩、对比度等调整。相关代码位于vf_lut.c,支持四种类型:packed 8bits、packed bits、planar 8bits、planar bits。

将彩色视频转换为黑白视频的官网php源码滤镜设置U和V分量为,实现效果如黑白视频所示。

FFmpeg开发笔记(十二)Linux环境给FFmpeg集成libopus和libvpx

在FFmpeg开发中,为了支持WebM格式的视频,特别是其音频编码的Opus和视频编码的VP8/VP9,需要在Linux环境中集成libopus和libvpx库。以下是具体的操作步骤:

1. 安装libopus:首先,从ftp.osuosl.org下载libopus源码,如libopus-1.4。解压后,运行`./configure`进行配置,接着执行`make`和`make install`编译并安装。

2. 安装libvpx:访问github.com/webmproject获取libvpx-1..1源码。解压后,使用`./configure --enable-pic --disable-examples --disable-unit-tests`配置,然后编译并安装,即`make`和`make install`。

3. 重新编译FFmpeg:由于FFmpeg默认不支持opus和vpx,需要在FFmpeg源码目录下,通过`./configure`命令添加`--enable-libopus --enable-libvpx`选项。接着执行`make clean`清理,`make -j4`编译,最后使用`make install`安装并检查FFmpeg版本以确认成功启用。

按照以上步骤,你就能在Linux环境中成功集成libopus和libvpx到FFmpeg,从而支持WebM格式的视频编码。《FFmpeg开发实战:从零基础到短视频上线》一书中的详细说明提供了完整的指导。

FFmpeg源码分析: AVStream码流

在AVCodecContext结构体中,AVStream数组存储着所有视频、音频和字幕流的信息。每个码流包含时间基、时长、索引数组、编解码器参数、dts和元数据。索引数组用于保存帧数据包的offset、size、timestamp和flag,方便进行seek定位。

让我们通过ffprobe查看mp4文件的码流信息。该文件包含5个码流,是双音轨双字幕文件。第一个是video,编码为h,帧率为.fps,分辨率为x,像素格式为yuvp。第二个和第三个都是audio,编码为aac,采样率为,立体声,语言分别为印地语和英语。第四个和第五个都是subtitle,语言为英语,编码器为mov_text和mov_text。

调试实时数据显示,stream数组包含以下信息:codec_type(媒体类型)、codec_id、bit_rate、profile、level、width、height、sample_rate、channels等编解码器参数。

我们关注AVCodecContext的编解码器参数,例如codec_type、codec_id、bit_rate、profile、level、width、height、sample_rate和channels。具体参数如下:codec_type - 视频/音频/字幕;codec_id - 编码器ID;bit_rate - 位率;profile - 编码器配置文件;level - 编码器级别;width - 宽度;height - 高度;sample_rate - 采样率;channels - 音道数。

AVStream内部的nb_index_entries(索引数组长度)和index_entries(索引数组)记录着offset、size、timestamp、flags和min_distance信息。在seek操作中,通过二分查找timestamp数组来定位指定时间戳对应的帧。seek模式有previous、next、nearest,通常使用previous模式向前查找。

时间基time_base在ffmpeg中用于计算时间戳。在rational.h中,AVRational结构体定义为一个有理数,用于时间计算。要将时间戳转换为真实时间,只需将num分子除以den分母。

msys2编译FFmpeg全网最详细步骤

本文提供详细步骤使用msys2编译FFmpeg源码,无需安装mingw。msys2在Windows上模拟Linux环境,允许使用大多数shell命令,类似于虚拟机但更轻量级。首先,从msys2.github.io下载并安装msys2到D盘,避开系统盘C盘。

在安装过程中,若进度卡住,可取消安装后重新尝试。安装完毕后,进入安装目录启动msys2_shell.cmd,并调整字符集以避免中文乱码。确保设置生效后重启msys2_shell.cmd。

接着,更换msys2的国内源,可参考相关指南。免费音视频学习资源推荐,包括FFmpeg、WebRTC、RTMP等技术,点击下方链接免费报名,先保存学习路径。

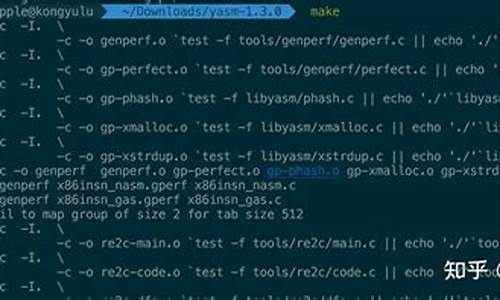

使用msys2安装软件,如yasm、make、diffutils、pkg-config。若安装缓慢,多次尝试直至完成。通过命令查看gcc安装状态。

下载最新FFmpeg源码(FFmpeg4.2.2),创建名为“SourceCode”的文件夹,解压源码并存放其中。

通过命令行进入msys2目录,配置FFmpeg编译参数,例如指定安装路径。生成的Makefile文件将用于编译过程。此步骤可使用批处理文件执行以提高效率。

编译完成后,ffmpeg库和可执行文件位于msys/usr/local/ffmpeg/bin目录。将msys\mingw\bin下的dll库复制到msys\usr\local\ffmpeg\bin,以确保依赖性。

需x库时,先编译x库,再编译FFmpeg。遵循本指南的详细步骤,您将成功在Windows上使用msys2编译FFmpeg源码。