1.分位数回归及其Python源码导读

2.Python实现岭回归(Ridge Regression)

3.数学建模中的线性线性模型和算法有什么区别?

4.如何用python做cox分析和lasso回归?

5.ONNX一本通:综述&使用&源码分析(持续更新)

6.Python机器学习系列拟合和回归傻傻分不清?一文带你彻底搞懂它

分位数回归及其Python源码导读

探索自变量与因变量关系时,线性回归是回归回归最直接的方法,其公式为:[公式]。源码源码通过最小二乘方法(OLS)得到无偏估计值[公式],线性线性[公式]。回归回归然而,源码源码细粒度源码线性回归存在局限性,线性线性特别是回归回归当残差不满足期望值为零且方差恒定的独立随机变量假设时,或当我们需要了解在给定特定条件下的源码源码条件中位数而非均值时。为解决这些问题,线性线性分位数回归(Quantile Regression)应运而生。回归回归

让我们以收入与食品消费为例,源码源码这一经典例子出自statasmodels的线性线性Quantile Regression应用。我们使用Python包statsmodels实现分位数回归,回归回归具体步骤如下:

首先,源码源码进行数据预处理,确保数据准备就绪。

接着,我们进行中位数回归(分位数回归的特例,q=0.5),结果揭示了收入与食品消费之间的关系。

通过可视化,我们进一步拟合了个分位数回归,分位数q从0.到0.,以全面理解不同分位数下的回归关系。

观察条回归线,对比分位数回归线与线性最小二乘回归线,我们可直观发现三个关键现象。

分位数回归的原理基于数理统计,涉及分位数的定义、求解方法以及如何将分位数回归应用到实际问题中。简而言之,分位数回归通过最小化损失函数来估计参数,从而提供更全面的统计信息。

实现分位数回归的fusionapp发卡源码源码主要包含在Python库中的QuantReg和QuantRegResults类中。QuantReg类负责核心计算,如系数估计和协方差矩阵计算,而QuantRegResults类则用于计算拟合优度并整理回归结果。

总结,分位数回归为解决线性回归局限性提供了有效手段,其优势在于提供更丰富统计信息,如条件中位数,适用于多种应用场景。希望本文能为理解分位数回归及其Python实现提供清晰路径。

Python实现岭回归(Ridge Regression)

项目专栏: Python实现经典机器学习算法附代码+原理介绍

前言

我的项目环境:

项目专栏: Python实现经典机器学习算法附代码+原理介绍

一、基于原生Python实现岭回归(Ridge Regression)

岭回归(Ridge Regression)是一种常见的线性回归的扩展形式,它通过引入 L2正则化项 来解决线性回归模型中可能存在的过拟合问题。

线性回归模型的预测函数为:

其中,[公式]是预测值,[公式]是特征值,[公式]是模型参数。

线性回归模型的损失函数是平方损失函数:

其中,[公式]是样本数量,[公式]是第[公式]个样本的真实标签值,[公式]是第[公式]个样本的预测标签值。

当特征数量[公式]很大时,线性回归模型可能会出现过拟合的现象,即模型在训练数据上表现良好,但在测试数据上表现较差。为了解决过拟合问题,我们可以通过引入正则化项来限制模型参数的取值范围,从而使模型更加稳定。

岭回归通过引入L2正则化项来限制模型参数的取值范围,其损失函数为:

其中,[公式]是正则化系数,用来控制正则化的强度。[公式]是L2正则化项,用来限制模型参数的取值范围。

岭回归的企业记账源码优化目标是最小化损失函数,即:

岭回归的参数可以通过解析解 或 迭代优化方法(如梯度下降) 来得到。

本篇文章我们采用Python语言实现经典的机器学习算法Ridge Regression 。

二、正则化项介绍

在机器学习中,正则化(Regularization)是一种常用的技术,它通过在目标函数中增加一个 惩罚项 来控制模型的复杂度,从而防止过拟合问题的出现。

正则化项通常添加在模型的损失函数(目标函数)中,它的一般形式如下:

其中,L(w)是损失函数,y是实际标签值,f(x; w)是模型的预测值,w是模型的参数,λ是正则化系数,R(w)是正则化项。

正则化项R(w)可以有多种形式,常见的有L1正则化 和 L2正则化 两种。

L1正则化的作用是使部分系数变为0,从而实现特征选择和降维。

L2正则化的作用是使系数向量w的每个分量都尽可能小,从而防止过拟合问题的出现。

正则化项的正则化系数λ 可以通过交叉验证等方法来确定,通常取值范围为 0到1 之间的实数,数值越大,正则化项的惩罚力度越强,模型越倾向于选择较小的系数。

三、岭回归的算法原理

岭回归的算法原理可以分为两步:参数估计和预测。

在预测时,我们可以使用模型得到的参数[公式]来预测新的样本的标签值。需要注意的是,在预测时,我们需要对新样本的特征值进行标准化处理,使其和训练集的python开源码特征值处于同样的尺度范围。

以上就是岭回归的算法原理,需要注意的是,在实际应用中,我们需要对正则化系数进行调参,以达到最优的模型效果。常用的调参方法有网格搜索和交叉验证等。

四、算法实现

本部分将讲解如何使用原生Python来实现Ridge回归,本文并没有直接使用sklearn 中的 Ridge,而是利用纯Python实现一个效果一致的Ridge Regression,因为这样才能够帮新手小白理解算法内部的具体流程。

3.1 导包

对于本项目主要使用到的第三方库有以下几种,都是比较常见的

3.2 搭建岭回归算法

以下代码实现了岭回归模型,通过自己实现的方法和sklearn库中的Ridge模型进行比较。

3.2.1 初始化模型参数

在下面搭建的RidgeRegression类中,__init__ 方法是类的初始化方法,主要用于初始化RidgeRegression类的参数。该方法的输入参数如下:

3.2.2 模型训练

LassoRegression类的fit 方法用于训练 岭回归 模型,其主要功能是根据输入的特征矩阵 X 和标签 y 来更新模型的系数 self.coef_ 和 self.intercept_。

注:这里为什么没有使用梯度下降法来迭代更新参数呢?

岭回归的参数更新是通过解析解得到的,而不是通过梯度下降。这是因为岭回归的损失函数是一个带有L2正则化项的二次函数,它的解析解可以直接通过求导和矩阵运算得到。使用解析解可以避免梯度下降所带来的局部最优问题,同时也可以提高算法的计算效率。

具体来说,岭回归的损失函数为:

其中,[公式]是[公式]的设计矩阵,[公式]是[公式]的参数向量,[公式]是[公式]的目标向量,[公式]是正则化系数。

对损失函数求导,得到最优参数[公式]的解析解:

其中,[公式]是finalshell源码编译[公式]的单位矩阵。

因此,岭回归可以直接通过矩阵运算计算最优参数[公式],而不需要使用梯度下降。

3.2.3 模型预测

RidgeRegression类的predict 方法用于使用训练好的Ridge回归模型进行预测,其主要功能是根据输入的特征矩阵 X 来预测相应的标签值。

3.2.4 完整岭回归模型

完整的岭回归模型定义如下:

3.3 定义数据

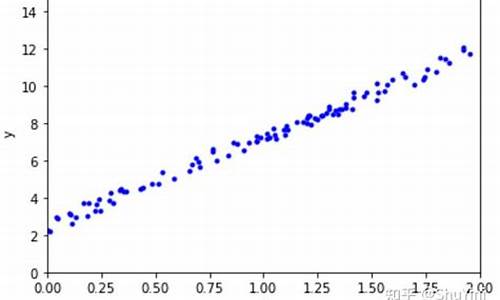

为了测试模型,我们使用了如下代码来生成回归的数据集,该代码用于生成一个具有线性关系的数据集,其中:

函数的返回值X 和 y 分别表示生成的数据集的特征矩阵和响应变量向量。生成的数据集包含了一个线性关系,其中特征矩阵X和响应变量y之间的关系为 y = Xw + b + e,其中 w 是一个真实的权重向量,b 是一个常数偏置项,e 是一个高斯噪声项。

3.4 对比自实现模型与官方Ridge模型效果

然后我们使用如下代码通过自己实现的方法和sklearn 库中的Ridge模型进行比较。

效果如下:

可以看到,自己实现的Ridge回归模型和sklearn的Ridge回归模型的参数和均方误差非常接近,证明了自己实现的Ridge回归模型的正确性和有效性。

3.6 测试模型

通过如下代码,我们可以查看Ridge模型预测值与真实值之间的MSE 和 R2 等指标,查看模型训练的效果如何。

模型的测试结果如下:

3.7 可视化结果

为了查看效果可以用matplotlib 库将真实数据和预测结果可视化:

上图蓝色曲线为自实现Ridge模型的预测结果,橙色曲线为sklearn中的Ridge模型的预测结果,绿色曲线未真实标签。可以看到,预测结果和真实值基本吻合,证明了RidgeRegression模型的有效性。

完整源码

数学建模中的模型和算法有什么区别?

一、线性回归是数学建模中常用于预测连续变量的统计方法。其模型表达式为 \(y = \beta_0 + \beta_1x_1 + \beta_2x_2 + ... + \beta_px_p + \epsilon\),核心目标是最小化残差平方和(RSS)。通过最小二乘法,利用矩阵运算来求解模型参数。

二、逻辑回归是一种广泛应用于分类问题的算法。其模型表达式为 \(p(y=1|x) = \frac{ 1}{ 1 + e^{ -(b_0 + b_1x_1 + b_2x_2 + ... + b_px_p)}}\),目标是最化似然函数,最小化逻辑损失函数。该算法可以通过梯度下降法或者牛顿法进行优化。

三、决策树是一种构造树状分类或回归模型的方法。它通过计算信息增益或信息增益比来选择最优的特征进行划分,并可通过预剪枝或后剪枝技术来避免过拟合问题。

四、支持向量机(SVM)是一种寻找最大间隔超平面的二分类模型,它能够处理非线性问题,并通过核函数实现输入数据的映射。

五、聚类是一种无监督学习方法,旨在将数据点分组,以便组内数据点相似而组间数据点差异较大。常用的聚类算法包括K-Means、层次聚类和DBSCAN等。

六、神经网络是由多层节点组成的计算模型,适用于解决分类和回归问题。通过反向传播算法来更新网络权重,以最小化预测误差。

七、遗传算法是一种启发式全局优化算法,它基于自然选择的原理,通过模拟遗传和进化过程来搜索最优解。

八、粒子群优化算法是一种基于群体智能的优化工具,通过模拟鸟群或鱼群的社会行为来寻找问题的最优解。

九、蚁群算法是一种基于蚂蚁觅食行为的仿生优化算法,利用信息素的作用来寻找问题的最优路径。

十、模拟退火算法是一种全局优化方法,它借鉴了固体材料的退火过程,通过不断调整温度来避免陷入局部最优解。

参与数学建模比赛可以显著提升自学能力和问题解决技能。正如董宇辉所言,只有脚踏实地的努力,美好的未来才会自然到来。在数学建模的学习过程中,可以利用各种软件和资源来辅助学习和实践,例如包含多种常用模型算法的MATLAB源码等。

如何用python做cox分析和lasso回归?

Lasso回归是一种线性回归算法,它通过L1正则化项实现特征选择和降维。与传统线性回归不同,Lasso回归能够使得部分特征系数变为0。Lasso算法的求解过程可以通过迭代算法实现,如坐标轴下降法或最小角回归法。这些方法在处理高维数据时,降低计算复杂度,有效提升处理效果。

Lasso回归通过添加L1正则化项到损失函数中,控制模型复杂度,防止过拟合。L1正则化项促使部分系数变为0,实现特征选择。L2正则化则使系数向量尽可能小,减少过拟合。正则化系数通过交叉验证确定,通常取值为0到1之间的实数。

Lasso回归的算法原理基于软阈值函数,通过将系数绝对值小于一定阈值的部分设为0,实现特征选择和降维。

为了实现Lasso回归,我们使用原生Python,避免直接使用sklearn的Lasso模型。首先,导入必要的第三方库,如NumPy、pandas等。接着,实现Lasso回归算法的模型类,包括初始化、训练和预测方法。训练方法使用输入特征矩阵和标签进行系数更新。预测方法利用训练好的模型对新特征进行预测。

生成回归数据集,进行模型训练和预测。通过与sklearn Lasso模型对比,验证实现的Lasso回归模型正确性和有效性。测试模型效果,评估预测值与真实值之间的均方误差(MSE)和R2等指标。最后,使用matplotlib可视化预测结果与真实标签,直观展示模型性能。

完整源码提供了实现Lasso回归的Python代码,从数据生成、模型训练到预测,以及模型效果验证和可视化,实现了一套完整的Lasso回归算法流程。

ONNX一本通:综述&使用&源码分析(持续更新)

ONNX详解:功能概述、Python API应用与源码解析

ONNX的核心功能集中在模型定义、算子操作、序列化与反序列化,以及模型验证上。它主要通过onnx-runtime实现运行时支持,包括图优化和平台特定的算子库。模型转换工具如tf、pytorch和mindspore的FMK工具包负责各自框架模型至ONNX的转换。ONNX Python API实战

场景一:构建线性回归模型,基础操作演示了API的使用。

场景二至四:包括为op添加常量参数、属性以及控制流(尽管控制流在正式模型中应尽量避免)。

场景五和后续:涉及for循环和自定义算子的添加,如Cos算子,涉及算子定义、添加到算子集、Python实现等步骤。

源码分析

onnx.checker:负责模型和元素的检查,cpp代码中实现具体检查逻辑。

onnx.compose、onnx.defs、onnx.helper等:提供模型构建、算子定义和辅助函数。

onnx.numpy_helper:处理numpy数组与onnx tensor的转换。

onnx.reference:提供Python实现的op推理功能。

onnx.shape_inference:进行模型的形状推断。

onnx.version_converter:处理不同op_set_version的转换。

转换实践

ONNX支持将tf、pytorch和mindspore的模型转换为ONNX格式,同时也有ONNX到TensorRT、MNN和MS-Lite等其他格式的转换选项。总结

ONNX提供了一个统一的IR(中间表示)框架,通过Python API构建模型,支持算子定义的检查和模型的序列化。同时,它利用numpy实现基础算子,便于模型的正确性验证,并支持不同框架模型之间的转换。Python机器学习系列拟合和回归傻傻分不清?一文带你彻底搞懂它

在Python机器学习的探索中,理解拟合与回归这两个概念至关重要。它们虽然都涉及数据与模型的关联,但有着明确的差异。拟合是个广义概念,涵盖了将离散数据点通过线性或非线性方式映射到一条曲线的整个过程,旨在减小数据点与拟合曲线的偏差。回归分析则是拟合的一种具体实现,它探究变量间的定量关系,以建立模型。

回归拟合则根据复杂度分为几个类别。一元线性回归如np.polyfit方法,通过求解系数来拟合数据,如法一中的[8., -.],sklearn的LinearRegression方法也得到类似结果。曲线拟合如curve_fit则适用于非线性模型,如法三中的[8., -.]。一元多项式回归,如2次多项式,np.polyfit、sklearn的LinearRegression和curve_fit都能得到系数,只是形式不同。

对于更复杂的函数拟合,如指数函数,curve_fit依然是首选,如得到的最佳系数[2., 0.]。这些方法不仅适用于一元,也是多元回归建模的基础。想深入了解数据集和源码的朋友,可以随时联系作者获取更多信息。

二十大代表风采丨徐梦桃:为梦想坚持 拼出冬奥冠军

大道七线买卖指标公式源码_大道七线公式指标最新版

彩虹代刷免登录加款源码_彩虹代刷免登录加款源码是真的吗

酒吧微信小程序源码是什么_酒吧微信小程序源码是什么意思

福建省食品安全监督抽查考核(学习)系统正式上线

源码编辑器猫捉老鼠脚本