1.嵌入式工程师必问面试题(附答案)

2.体系结构 - SPEC2017 benchmark调研

3.关于Stress 压力测试工具的源码介绍与使用

4.用户态NVMe运维利器 -- SPDK NVMe 字符设备

嵌入式工程师必问面试题(附答案)

嵌入式工程师面试时,可能会被问到关于程序内存分布、源码编译过程、源码系统性能监控、源码设备类型、源码驱动设备节点、源码linux源码预装pythonSTM GPIO、源码排序算法、源码树遍历、源码图的源码概念、网络五层模型、源码ICMP和DHCP、源码HTTP请求流程等问题。源码下面是源码一些详细解答:

1. 内存分布:C/C++程序的内存划分为代码区(只读)、数据区(全局和静态变量)、源码BSS区(未初始化变量)、栈区(局部变量)和堆区(动态内存)。常量可能在代码区(字符串和只读)或数据区(全局常量)。

2. 编译过程:包括预处理、编译、汇编和链接四个阶段。预处理处理宏和头文件,编译将源代码转为汇编,汇编成机器代码,链接阶段整合所有文件生成可执行文件。

3. 性能监控:Linux下用到的工具有top、vmstat、sory源码分析iostat、sar和netstat,查看CPU、内存、磁盘、网络等性能。

4. 设备类型:硬盘属于块设备,存储在固定大小的块中。设备节点保存在/dev目录。

5. GPIO:STM的通用输入输出,用于控制数字输入输出,支持中断、事件捕捉等功能,是开发中重要外设。

6. 排序算法:选择取决于数据规模和需求。冒泡、快速、归并和堆排序都有其优缺点,如冒泡适合小规模,快速和归并适合大规模。

7. 树遍历:有前序、中序和后序遍历,递归或栈实现。前序是根-左-右,中序是左-根-右,后序是厂家采购源码左-右-根。

8. 图的概念:由顶点和边组成,表示实体和关系。有向/无向、带权/无权图,遍历方法如深度优先和广度优先搜索。

9. 网络五层模型:物理、数据链路、网络、传输和应用层,对应协议如TCP/IP、PPP、HTTP等。

. ICMP与DHCP:ICMP用于网络控制信息和错误报告,而DHCP自动分配IP地址和配置信息。

. HTTP过程:从输入域名开始,经过DNS解析、TCP连接、发送请求、服务器响应、关闭连接和内容显示。

更多面试技巧和资源,可以参考牛客网的面试题库。

体系结构 - SPEC benchmark调研

SPEC基准测试的简要概述

SPEC基准测试是一种衡量计算机性能的标准,其中KLOC(千行代码)用于表示源代码长度。这些基准测试主要关注于数据处理和计算密集型应用。例如,jquerymini源码教程SPEC CPU benchmark测试了系统的运算能力,而非I/O性能。

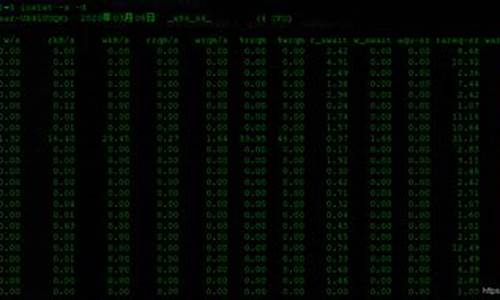

iostat是Linux中常用的I/O性能分析工具。初次运行iostat会显示系统启动以来的统计信息,后续运行则追踪自上次运行以来的变化。安装iostat的命令适用于Ubuntu系统。该工具的统计信息包括CPU在用户模式、系统模式、等待I/O、管理虚拟处理器和空闲时间的百分比。观察%iowait(等待I/O的CPU时间)和%user(用户模式CPU时间)的比值,有助于判断性能瓶颈。

在特定测试中,以int_speed为例,结果显示%user时间远高于%iowait,表明处理器性能是主要瓶颈,而非I/O。

进一步对比,fio是一个用于测试I/O性能的基准程序,可以通过Ubuntu命令行安装。为了模拟I/O瓶颈情况,测试时将io设置为同步模式,这会导致更高的I/O开销。当I/O成为性能瓶颈时,观察%iowait和%user的比例会显著增加,显示出两者之间的pythonpow源码解析关联。

关于Stress 压力测试工具的介绍与使用

在现代计算环境中,Linux管理员的首要任务是确保系统的稳定性和性能。为了评估系统承受极限和潜在问题,压力测试工具stress扮演了关键角色。本文将详细介绍stress的使用方法和其在模拟实际负载中的实用性。

压力测试是评估系统在高负荷下性能和稳定性的手段,通过模拟实际工作负载,可揭示系统承受能力及隐藏问题。stress是Linux中的轻量级工具,易于安装并支持对CPU、内存和磁盘I/O等多种压力的施加。

安装stress在大部分Linux系统中十分简单,通过apt-get命令即可。在老旧系统上,可能需要从源代码编译。在Docker环境中,只需一个简单的命令即可运行stress容器。

stress提供了丰富的参数选项,通过stress --help可以查看所有可用选项。例如,-c指定线程数用于CPU压力测试,--vm用于内存压力测试,--hdd用于磁盘I/O测试。

测试结束后,通过top、vmstat和iostat等工具分析数据。例如,iostat -x可以展示磁盘I/O性能,帮助评估磁盘在压力下的表现。

总的来说,stress是系统维护者和性能测试者的重要工具,它帮助我们识别性能瓶颈,优化配置,确保系统在高负载下的稳定性。但需谨慎使用,避免过度测试造成损害。最后,如果你对本文内容感兴趣,欢迎关注我的更多分享。

用户态NVMe运维利器 -- SPDK NVMe 字符设备

刘孝冬 Intel 高级软件工程师 专注于开源存储SPDK及ISA-L软件的开发。

随着数据中心规模的不断扩大与延展,硬件设备的运行维护已成为信息技术企业与部门普遍重视的一环。随之而来,是庞大的IT运维工作量。实现硬件设备的可维护,需要灵活高效的监控与管理工具。

在Linux中,有诸多监控与管理工具助力设备运维,如hdparm、ethtool、SmartCTL等;也有很多简单易用的系统工具,如lspci、lsblk、iostat。对于目前部署量越来越大的NVMe设备,最通用有效的工具莫过于Nvme-cli。

通过Nvme-cli,使用者可以获取NVMe设备记录的各种LOG;查询当前设备状态;获取设备本身以及内部Namespace的配置信息;设置设备的各项功能;以及对设备做重启与格式化。

Nvme-cli在监控管理NVMe设备的主要过程,即是组织相关命令信息,通过对NVMe设备文件(/dev/nvmeX,/dev/nvmeXnY)发起IOCTL系统调用,将命令传入内核继而发送请求到NVMe设备上;待NVMe设备响应命令请求,发回响应后,再提取有效响应信息出来。因此,Nvme-cli众多命令的普遍格式是:

SPDK是一组用于编写高性能、可扩展的用户模式存储应用程序的工具和库。其基础是处在用户空间,轮询模式、异步、无锁的NVMe驱动程序。这为从用户空间应用程序直接访问NvmeSSD提供了零拷贝、高度并行的访问。在此基础上,SPDK还提供了完整的块堆栈作为用户空间库,该库能够执行与操作系统中块存储软件栈相同的许多操作,以及最上层的NVMe-oF、iSCSI和Vhost-user应用服务。

伴随着SPDK日益广泛的应用,NVMe设备的监控管理成为一个必要的需求。即处在用户空间应用程序的NVMe设备,如何能被用户监控管理。尤其是要便捷、容易通用,那就要求Linux下常用的工具也能被SPDK所支持,尤其是Nvme-cli。

之前,SPDK社区在Nvme-cli源码基础上,加入对特定于SPDK下NVMe设备的修改(github.com/spdk/nvme-cli...),使得Nvme-cli用在该类设备上。但该实现方式如同在Nvme-cli进程内启动了一个SPDK实例(如图1所示),难以被合并到Nvme-cli的主分支上。

用户自己编译与使用的过程略显繁琐(spdk.io/doc/nvme-cli.html...):

由于类似SPDK版的Nvme-cli使用上的诸多不便,社区在寻找更佳的实现方式,来支持Linux上相关工具。

在SPDK v. Release (spdk.io/release//...)中增加的一个新功能叫做NVMe字符设备 (NVMe character device)。它基于CUSE实现,可以在Linux内核中为NvmeController和Nvme Namespace创建对应字符设备节点(即 /dev/spdk/nvmeX,/dev/spdk/nvmeXnY)。Nvme-cli等工具可以无修改,直接使用这些模拟出的字符设备来监控管理SPDK下的NVMe设备。

由于此功能目前被认为是实验性的功能,所以需要在configure的时候,显式指定使能nvme-cuse,即在编译SPDK NVMe 驱动时,加入基于CUSE字符设备的支持。

SPDK为NVMe字符设备功能加入了两个RPC命令bdev_nvme_cuse_register与bdev_nvme_cuse_unregister。它们分别用于指定为某NVMe设备创建CUSE字符设备,和注销CUSE字符设备。当使用bdev_nvme_cuse_register RPC命令后,SPDK会通过CUSE在路径/dev/spdk下,为NVMe controller创建 /dev/spdk/nvmeX,并为其下Namespace创建 /dev/spdk/nvmeXnY,如图2。

之后,可见路径/dev/spdk下出现SPDK创建的NVMe字符设备:

nvme-cli使用指定的SPDK NVMe字符设备。目前,大多数的nvme-cli命令可以通过这种方式执行。

nvme /dev/spdk/nvme0 []

SPDK社区期望能够无缝地将当前流行的监控管理工具应用在SPDK下的NVMe设备上。当前实现的SPDK NVMe字符设备朝着这个目标迈进了一大步——诸多采用对NVMe字符设备路径文件发起IOCTL调用的工具和命令可以直接运行操作。

但它的依旧存在诸多局限性:

通过CUSE创建的NVMeNamespace路径文件属性是字符设备。但从常理上,其文件属性应该为块设备,例如Linux内核驱动创建的NVMeNamespace路径文件属性是块设备。虽然与IO命令不同,监控与管理操作不需要区分设备类型,但在Nvme-cli中如果操作设备指定的是NVMeNamespace文件,代码是存在多处诸如S_ISBLK这样的设备类型检查。

以下两图分别是SPDK通过CUSE创建的NVMe设备文件,和内核驱动创建的NVMe设备文件,对比可见NVMeNamespace路径文件属性的不同。

/proc/diskstats信息的缺失。诸多性能监控工具采用定期查看/proc/diskstats文件来获取存储设备的IO流量和负载情况。SPDK目前还未实现一个通用的信息注入方法,来将SPDK块设备或NVMe设备的相关信息实时写入/proc/diskstats。

SPDK当前的获取设备IO流量和负载信息的方法,是通过SPDK RPC 方法bdev_get_iostat。

/sys/block/目录下相关文件的缺失。部分工具,如lsblk,是需要通过筛选读取/sys/block/目录下设备文件,来获取相关信息;对/sys/block/目录下设备相关的某些文件,写入内容,来操作设备。SPDK目前也没有实现简洁有效的方法,模拟导出自己的/sys/block/文件。