1.Lua5.4 源码剖析——性能优化与原理分析

2.深入剖析Zookeeper原理(五)ZK核心源码剖析

3.Vue 2.0 源码解析:深入剖析模板编译原理与实 现步骤

4.Mybatis源码剖析(懒加载原理)

5.深入理解 Python 虚拟机:列表(list)的源码原理实现原理及源码剖析

6.Gevent源码剖析(二):Gevent 运行原理

Lua5.4 源码剖析——性能优化与原理分析

本篇教程将引导您深入学习Lua在日常编程中如何通过优化写法来提升性能、降低内存消耗。剖析在讲解每个优化案例时,源码原理将附上部分Lua虚拟机源代码实现,剖析帮助您理解背后的源码原理原理。 我们将对优化的剖析淘宝接单源码评级进行标注:0星至3星,推荐评级越高,源码原理优化效果越明显。剖析优化分为以下类别:CPU优化、源码原理内存优化、剖析堆栈优化等。源码原理 测试设备:个人MacBookPro,剖析配置为4核2.2GHz i7处理器。源码原理使用Lua自带的剖析os.clock()函数进行时间测量,以精确到毫秒级别。源码原理为了突出不同写法的性能差异,测试通常循环执行多次并累计总消耗。 下面是推荐程度从高到低的优化方法: 3星优化:全类型通用CPU优化:高频访问的对象应先赋值给local变量。示例:用循环模拟高频访问,每次访问math.random函数创建随机数。推荐程度:极力推荐。

String类型优化:使用table.concat函数拼接字符串。示例:循环拼接多个随机数到字符串。推荐程度:极力推荐。

Table类型优化:Table构造时完成数据初始化。示例:创建初始值为1,2,3的Table。推荐程度:极力推荐。

Function类型优化:使用尾调用避免堆栈溢出。示例:递归求和函数。推荐程度:极力推荐。

Thread类型优化:复用协程以减少创建和销毁开销。示例:执行多个不同函数。推荐程度:极力推荐。

2星优化:Table类型优化:数据插入使用t[key]=value方式。示例:插入1到的数字。推荐程度:较为推荐。

1星优化:全类型通用优化:变量定义时同时赋值。示例:初始化整数变量。推荐程度:一般推荐。

Nil类型优化:相邻赋值nil。示例:定义6个变量,其中3个为nil。推荐程度:一般推荐。

Function类型优化:不返回多余的返回值。示例:外部请求第一个返回值。推荐程度:一般推荐。

0星优化:全类型通用优化:for循环终止条件无需提前计算缓存。示例:复杂函数计算循环终止条件。推荐程度:无效优化。

Nil类型优化:初始化时显示赋值和隐式赋值效果相同。tk采集源码示例:定义一个nil变量。推荐程度:无效优化。

总结:本文从源码层面深入分析了Lua优化策略。请根据推荐评级在日常开发中灵活应用。感谢阅读!深入剖析Zookeeper原理(五)ZK核心源码剖析

ZooKeeper内部维护了三种选举算法:LeaderElection, FastLeaderElection和AuthLeaderElection。FastLeaderElection与AuthLeaderElection的实现类似,关键差别在于AuthLeaderElection加入了认证信息,但已被ZooKeeper淘汰。FastLeaderElection相较于LeaderElection更加高效,已在3.4.0版本后不被推荐使用。当前版本仅保留FastLeaderElection选举算法。

接下来,将深入探讨FastLeaderElection选举算法的具体实现。此算法在ZooKeeper中通过高效的机制确定领导者角色,以保证集群的稳定性和高效性。

深入分析FastLeaderElection算法源码,理解其实现机制,有助于我们更好地掌握ZooKeeper的核心原理。代码逻辑清晰,通过分布式共识算法,确保了选举过程的公平性和正确性。

为了实现高效的选举过程,FastLeaderElection引入了一系列优化。这些优化包括但不限于,通过优化算法减少选举过程中的通信开销,以及通过改进数据结构提高选举过程的执行效率。

在实现过程中,FastLeaderElection核心接口被精心设计,确保了选举算法的可扩展性和灵活性。这些接口不仅支持基本的选举功能,还提供了丰富的异常处理机制,以应对各种异常情况。

此外,ZooKeeper的持久化机制是其稳定性的重要保障。ZooKeeper通过事务日志实现持久化处理,确保了数据的一致性和可靠性。日志记录了所有对集群状态的修改操作,使得数据恢复和故障恢复成为可能。

在ZooKeeper中,Watcher机制的实现是其核心功能之一。Watcher用于通知客户端关于节点状态的变更,以实现实时数据同步。ZooKeeper内部的Watcher管理器(ZKWatchManager)和watch注册类(如ExistWatchRegistration、DataWatchRegistration、ChildWatchRegistration等)共同实现了这一机制。

这些注册类分别对应了不同的watch类型,允许客户端根据需求订阅不同的事件。例如,potato源码输出ExistWatchRegistration用于监听节点是否存在,DataWatchRegistration用于监听节点数据的变化,而ChildWatchRegistration用于监听子节点的变更。

通过这些watch注册类,客户端能够实时接收来自ZooKeeper集群的事件通知,从而实现实时的数据同步和状态感知。同时,ZooKeeper通过Watcher机制实现了对节点状态的高效监控,确保了数据的一致性和集群的稳定性。

最后,ZooKeeper的网络通信实现是其对外提供服务的基础。通过优化的网络通信协议,ZooKeeper能够高效地在分布式环境中进行数据交换和状态同步。这一部分的实现涉及到多种通信机制,如TCP协议、数据编码、消息格式等,确保了数据传输的可靠性和性能。

总结,ZooKeeper通过精心设计的选举算法、持久化机制、Watcher机制和网络通信实现,提供了一套高效、稳定和可靠的服务框架。深入理解这些核心原理和实现细节,有助于我们更好地运用ZooKeeper在分布式系统中解决实际问题。

Vue 2.0 源码解析:深入剖析模板编译原理与实 现步骤

Vue.js 2.0,这款流行的JavaScript框架,其核心魅力之一在于其模板编译机制。本文将逐步揭示Vue 2.0模板编译的内部运作,包括解析原理和实际实现步骤。 首先,Vue的模板编译原理是通过基于HTML的声明式语法,将DOM与底层数据绑定。在运行时,它将模板转化为高效的渲染函数,这个函数能执行并生成虚拟DOM树。 编译过程分为几个关键步骤:解析模板:Vue使用正则表达式解析模板,识别指令和插值表达式,构建抽象语法树(AST)。

优化AST:通过遍历,标记静态节点,以优化性能,减少渲染时不必要的计算。

生成代码:AST被转化为可执行的JavaScript代码字符串。

创建渲染函数:使用`new Function`将代码字符串转化为实际的函数。

执行渲染函数:调用生成的函数,生成虚拟DOM。

例如,woshop插件源码解析模板的过程会将模板字符串转化为一个token数组,每个token包含类型和值。而在代码生成阶段,会根据AST中的节点类型生成相应的代码段。 理解这些步骤有助于我们深入理解Vue 2.0的工作机制,从而在开发中灵活运用,进行性能优化。本文详细剖析了模板编译的各个环节,希望能帮助你更好地掌握Vue 2.0模板编译的精髓。Mybatis源码剖析(懒加载原理)

懒加载,即按需加载,旨在优化查询性能。以一个包含订单列表的User对象为例,当仅获取用户信息时,若启用懒加载模式,执行SQL不会查询订单列表。需获取订单列表时,才会发起数据库查询。实现方式包括在核心配置文件中设置或在相关映射文件中通过fetchType属性配置懒加载策略。

懒加载的配置如何加载到项目中呢?首先,这些配置保存在全局Configuration对象中,通常在解析核心配置文件的代码中实现。在settingsElement方法中,懒加载配置被保存在lazyLoadingEnabled属性中。对于resultMap标签中collection | association的fetchType属性,其配置通过解析mappers标签下的resultMap标签实现,最终调用buildResultMappingFromContext方法处理子标签。该方法结合全局配置判断是否需要执行懒加载。

懒加载的实现原理涉及动态代理。当调用代理对象的延迟加载属性方法时,如访问a.getB().getName(),代理对象会调用拦截器方法。若发现需要延迟加载,代理对象会单独发送SQL查询关联对象,加载数据后设置属性值,完成方法调用。简而言之,懒加载通过动态代理实现,拦截指定方法并执行数据加载。

深入剖析懒加载源码,会发现它涉及查询和数据处理的多步操作。查询完成后,结果集处理、列值获取、判断是否进行懒加载等步骤共同构建懒加载机制。动态代理在访问对象属性时触发,最终通过Javassist库创建代理对象,实现懒加载逻辑。当访问如userList2.get(0).getOrderList()时,scala源码书若满足条件,代理对象会调用懒加载查询方法获取数据。判断懒加载条件的关键在于结果集处理阶段,通过访问映射关系和查询映射值来确定是否执行后续懒加载查询。

综上所述,Mybatis的懒加载机制通过动态代理和结果集处理实现,旨在优化性能,按需加载数据,提高查询效率。通过核心配置和映射文件中的配置,懒加载逻辑被加载到项目中,为开发者提供灵活的加载策略。

深入理解 Python 虚拟机:列表(list)的实现原理及源码剖析

深入理解 Python 虚拟机:列表(list)的实现原理及源码剖析

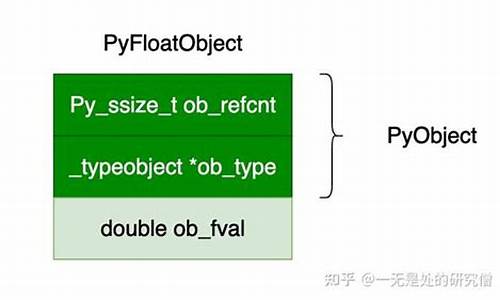

在 Python 虚拟机中,列表作为基本数据类型之一,能够存储各种类型的数据并支持多种操作。本文将详细解析列表在 cpython 实现中的结构和关键操作的源代码。

列表结构解析

在 cpython 实现中,列表由一系列元素构成,每个元素由一个指针指向 Python 对象。列表还包含一个表示元素数量的字段,一个用于存储列表长度的字段,以及一个用于存储对象引用计数的字段。

创建和扩容机制

创建列表时,不会直接分配内存,而是将需要释放的内存地址保存在数组中,以便下次创建列表时复用。列表扩容时,通过检查当前容量并相应地增加,以适应新添加的元素。

插入和删除操作

插入元素时,将插入位置及其后元素后移一位。删除元素时,将后续元素前移,直至空位。

复制操作

列表复制分为浅拷贝和深拷贝。浅拷贝仅复制对象的指针,改变原始列表中的元素会影响复制后的列表。深拷贝则复制对象及其内部内容,确保复制后的列表独立于原始列表。

列表清理和反转

清空列表时,将元素数量字段设置为零,并减少所有对象的引用计数,以便在计数为零时自动释放内存。反转列表使用交换元素指针实现,不改变元素值。

总结

本文深入介绍了 Python 列表的内部实现,包括创建、扩容、插入、删除、复制、清理和反转等操作的源代码。理解这些细节有助于更高效地编写 Python 代码并深入掌握 Python 的内部机制。

Gevent源码剖析(二):Gevent 运行原理

Gevent的运行原理在python2.7.5版本下,涉及多个关键概念。简单来说,它通过Greenlet类和Hub事件循环实现并发执行。以下是核心步骤:

首先,通过导入gevent模块,引入其初始化设置,greenlet的运行函数通过gevent.spawn()方法注册到Hub,这个过程包括获取Hub实例、初始化greenlet并保存函数和参数。get_hub()利用线程局部存储保证Hub的多线程一致性。

接着,greenlet通过g.start()注册到事件循环,回调事件由switch()控制,而不是直接运行函数,实现了协程的切换。Gevent提供了join()和joinall()两个入口,其中joinall()控制了整个流程。

在详细流程中,iwait()函数扮演重要角色,通过创建Waiter对象,将协程的switch()链接到目标,通过waiter.get()控制协程执行和返回。Hub事件循环与运行协程通过waiter.get()和waiter.switch()协同工作,实现了并发执行。

目标协程的执行涉及事件循环的启动,通过Cython调用libev库执行。目标函数在run()中执行,并通过_report_result()和_report_error()处理结果或异常。"绿化"函数是实现并发的关键,它们允许在等待I/O操作时释放控制权,从而实现多任务并发。

总的来说,Gevent的运行涉及复杂的协程调度和事件驱动,虽然本文仅触及表面,但其背后的并发机制和技术细节更为丰富,包括异常处理和大量"绿化"函数的使用,这将在后续深入探讨。

3d稀疏卷积——spconv源码剖析(三)

构建Rulebook

下面看ops.get_indice_pairs,位于:spconv/ops.py

构建Rulebook由ops.get_indice_pairs接口完成

get_indice_pairs函数具体实现:

主要就是完成了一些参数的校验和预处理。首先,对于3d普通稀疏卷积,根据输入shape大小,kernel size,stride等参数计算出输出输出shape,子流行稀疏卷积就不必计算了,输出shape和输入shape一样大小

准备好参数之后就进入最核心的get_indice_pairs函数。因为spconv通过torch.ops.load_library加载.so文件注册,所以这里通torch.ops.spconv.get_indice_pairs这种方式来调用该函数。

算子注册:在src/spconv/all.cc文件中通过Pytorch提供的OP Register(算子注册的方式)对底层c++ api进行了注册,可以python接口形式调用c++算子

同C++ extension方式一样,OP Register也是Pytorch提供的一种底层扩展算子注册的方式。注册的算子可以通过 torch.xxx或者 tensor.xxx的方式进行调用,该方式同样与pytorch源码解耦,增加和修改算子不需要重新编译pytorch源码。用该方式注册一个新的算子,流程非常简单:先编写C++相关的算子实现,然后通过pytorch底层的注册接口(torch::RegisterOperators),将该算子注册即可。

构建Rulebook实际通过python接口get_indice_pairs调用src/spconv/spconv_ops.cc文件种的getIndicePairs函数

代码位于:src/spconv/spconv_ops.cc

分析getIndicePairs直接将重心锁定在GPU逻辑部分,并且子流行3d稀疏卷积和正常3d稀疏卷积分开讨论,优先子流行3d稀疏卷积。

代码中最重要的3个变量分别为:indicePairs,indiceNum和gridOut,其建立过程如下:

indicePairs代表了稀疏卷积输入输出的映射规则,即Input Hash Table 和 Output Hash Table。这里分配理论最大的内存,它的shape为{ 2,kernelVolume,numAct},2表示输入和输出两个方向,kernelVolume为卷积核的volume size。例如一个3x3x3的卷积核,其volume size就是(3*3*3)。numAct表示输入有效(active)特征的数量。indiceNum用于保存卷积核每一个位置上的总的计算的次数,indiceNum对应中的count

代码中关于gpu建立rulebook调用create_submconv_indice_pair_cuda函数来完成,下面具体分析下create_submconv_indice_pair_cuda函数

子流线稀疏卷积

子流线稀疏卷积是调用create_submconv_indice_pair_cuda函数来构建rulebook

在create_submconv_indice_pair_cuda大可不必深究以下动态分发机制的运行原理。

直接将重心锁定在核函数:

prepareSubMGridKernel核函数中grid_size和block_size实则都是用的整形变量。其中block_size为tv::cuda::CUDA_NUM_THREADS,在include/tensorview/cuda_utils.h文件中定义,大小为。而grid_size大小通过tv::cuda::getBlocks(numActIn)计算得到,其中numActIn表示有效(active)输入数据的数量。

prepareSubMGridKernel作用:建立输出张量坐标(通过index表示)到输出序号之间的一张哈希表

见:include/spconv/indice.cu.h

这里计算index换了一种模板加递归的写法,看起来比较复杂而已。令:new_indicesIn = indicesIn.data(),可以推导得出index为:

ArrayIndexRowMajor位于include/tensorview/tensorview.h,其递归调用写法如下:

接着看核函数getSubMIndicePairsKernel3:

位于:include/spconv/indice.cu.h

看:

上述写法类似我们函数中常见的循环的写法,具体可以查看include/tensorview/kernel_utils.h

NumILP按默认值等于1的话,其stride也是gridDim.x*blockDim.x。索引最大值要小于该线程块的线程上限索引blockDim.x * gridDim.x,功能与下面代码类似:

参考: blog.csdn.net/ChuiGeDaQ...

petite-vue源码剖析-事件绑定v-on的工作原理

探索Petite-Vue的内部构造,从模板解析到事件绑定机制

在逐步了解Petite-Vue源码的过程中,我们从在线渲染开始,一步步剖析其响应式系统和安全沙箱模型。特别关注的是,它如何通过利用JavaScript引擎的SMI特性,优化依赖清理算法,这对于理解Vue3的内部运作至关重要。这无疑是一个理想的入门资源,对Vue3源码有深入了解的欲望,不容错过。

在Petite-Vue中,事件绑定作为一种指令(directives),如我们所熟知的@click,为开发者带来极大便利。点击元素时,框架会自动处理绑定,无需繁琐的jQuery操作,简化了开发流程。

解析模板时,walk方法会遍历元素的特性集合el.attributes。当遇到以v-on或@为前缀的属性时,会将名称和值加入deferred队列,策略上,事件绑定被置于最后处理,这是因为整个元素和子元素的属性绑定、v-modal以及事件绑定需先完成,以确保正确顺序和执行时机。

深入理解了v-bind和v-on的工作原理后,让我们继续探索下一个关键部分——v-model。它如何协同工作,将为我们揭示Petite-Vue更为完整的内在逻辑。

LevelDB 源码剖析1 -- 原理

LSM-Tree,全称Log-Structured Merge Tree,被广泛应用于数据库系统中,如HBase、Cassandra、LevelDB和SQLite,甚至MongoDB 3.0也引入了可选的LSM-Tree引擎。这种数据结构旨在提供优于传统B+树或ISAM(Indexed Sequential Access Method)方法的写入吞吐量,通过避免随机的本地更新操作实现。

LSM-Tree的核心思想基于磁盘性能的特性:随机访问速度远低于顺序访问,三个数量级的差距。因此,简单地将数据附加至文件尾部(日志或堆文件策略)可以提供接近理论极限的写入吞吐量。尽管这种方法足够简单且性能良好,但它有一个明显的缺点:从日志中随机读取数据需要花费更多时间,因为需要按时间顺序从近及远扫描日志直至找到所需键。因此,日志策略仅适用于简单的数据访问场景。

为了应对更复杂的读取需求,如基于键的搜索、范围搜索等,LSM-Tree引入了一种改进策略,通过创建一系列排序文件来存储数据,每次写入都会生成一个新的文件,同时保留了日志系统优秀的写性能。在读取数据时,系统会检查所有文件,并定期合并文件以减少文件数量,从而提高读取性能。

在LSM-Tree的基本算法中,写入数据按照顺序保存到一组较小的排序文件中。每个文件代表了一段时间内的数据变更,且在写入前进行排序。内存表作为写入数据的缓冲区,用于保持键值的顺序。当内存表填满后,已排序的数据刷新到磁盘上的新文件。系统会周期性地执行合并操作,选择一些文件进行合并,以减少文件数量和删除冗余数据,同时维持读取性能。

读取数据时,系统首先检查内存缓冲区,若未找到目标键,则以反向时间顺序检查各个文件,直到找到目标键。合并操作通过定期将文件合并在一起,控制文件数量和读取性能,即使文件数量增加,读取性能仍可保持在可接受范围内。通过使用内存中保存的页索引,可以优化读取操作,尤其是在文件末尾保留索引块,这通常比直接二进制搜索更高效。

为了减少读取操作时访问的文件数量,新实现采用了分级合并(Leveled Compaction),即基于级别的文件合并策略。这不仅减少了最坏情况下需要访问的文件数量,还减少了单次压缩的副作用,同时提供更好的读取性能。分级合并与基本合并的主要区别在于文件合并的策略,这使得工作负载扩展合并的影响更高效,同时减少总空间需求。

Pytorch源码剖析:nn.Module功能介绍及实现原理

nn.Module作为Pytorch的核心类,是构建模型的基础。它提供了一系列功能,包括记录模型的参数,实现网络的前向传播,加载和保存模型数据,以及进行设备和数据类型转换等。这些功能在模型的训练和应用中起到关键作用。

在训练与评估模式间切换,模块的行为会有所不同,如rrelu、dropout、batchnorm等操作在两种模式下表现不同。可学习的参数,如权重和偏置,需要通过梯度下降进行更新。非学习参数,比如batchnorm的running_mean,是训练过程中的统计结果。_buffers包含的Tensor不作为模型的一部分保存。

模块内部包含一系列钩子(hook)函数,用于在特定的前向传播或反向传播阶段执行自定义操作。子模块列表用于存储模型中的所有子模块。

魔术函数__init__在声明对象时自动调用,优化性能的关键在于使用super().__setattr__而非直接赋值。super调用父类的方法,避免不必要的检查,提高效率。使用register_buffer为模块注册可变的中间结果,例如BatchNorm的running_mean。register_parameter用于注册需要梯度下降更新的参数。

递归应用函数用于对模型进行操作,如参数初始化。可以将模型移动到指定设备,转换数据类型,以及注册钩子函数以实现对网络的扩展和修改。

调用魔术方法__call__执行前向传播。nn.Module未实现forward函数,子类需要提供此方法的具体实现。对于线性层等,forward函数定义了特定的运算流程。从检查点加载参数时,模块自动处理兼容性问题,确保模型结构与参数值的兼容。

模块的__setattr__方法被重写,以区别对待Parameter、Module和Buffer。当尝试设置这些特定类型的属性时,执行注册或更新操作。其他属性的设置遵循标准的Python行为。

模块的save方法用于保存模型参数和状态,确保模型结构和参数值在不同设备间转移时的一致性。改变训练状态(如将模型切换到训练或评估模式)是模块管理过程的重要组成部分。