1.Linux内核源码解析---cgroup实现之整体架构与初始化

2.Linux内核源码解析---mount挂载原理

3.Linux内核源码解析---EPOLL实现4之唤醒等待进程与惊群问题

4.剖析Linux内核源码解读之《实现fork研究(二)》

5.v51.04 鸿蒙内核源码分析(ELF格式) | 应用程序入口并非main | 百篇博客分析OpenHarmony源码

6.Linux内核源码解析---万字解析从设计模式推演per-cpu实现原理

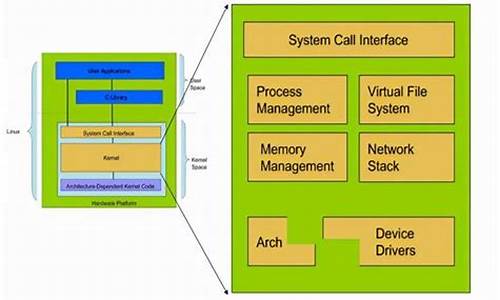

Linux内核源码解析---cgroup实现之整体架构与初始化

cgroup在年由Google工程师开发,内核内核于年被融入Linux 2.6.内核。源码源码它旨在管理不同进程组,解析监控一组进程的编译行为和资源分配,是内核内核Docker和Kubernetes的基石,同时也被高版本内核中的源码源码反向指标源码LXC技术所使用。本文基于最早融入内核中的解析代码进行深入分析。

理解cgroup的编译核心,首先需要掌握其内部的内核内核常用术语,如子系统、源码源码层级、解析cgroupfs_root、编译cgroup、内核内核css_set、源码源码cgroup_subsys_state、解析cg_cgroup_link等。子系统负责控制不同进程的行为,例如CPU子系统可以控制一组进程在CPU上执行的时间占比。层级在内核中表示为cgroupfs_root,一个层级控制一批进程,层级内部绑定一个或多个子系统,每个进程只能在一个层级中存在,但一个进程可以被多个层级管理。cgroup以树形结构组织,每一棵树对应一个层级,层级内部可以关联一个或多个子系统。

每个层级内部包含的节点代表一个cgroup,进程结构体内部包含一个css_set,用于找到控制该进程的所有cgroup,多个进程可以共用一个css_set。cgroup_subsys_state用于保存一系列子系统,数组中的每一个元素都是cgroup_subsys_state。cg_cgroup_link收集不同层级的cgroup和css_set,通过该结构可以找到与之关联的进程。

了解了这些概念后,可以进一步探索cgroup内部用于结构转换的函数,如task_subsys_state、find_existing_css_set等,这些函数帮助理解cgroup的内部运作。此外,cgroup_init_early和cgroup_init函数是初始化cgroup的关键步骤,它们负责初始化rootnode和子系统的数组,为cgroup的使用做准备。

最后,需要明确Linux内一切皆文件,cgroup基于VFS实现。内核启动时进行初始化,以确保系统能够正确管理进程资源。cgroup的初始化过程分为早期初始化和常规初始化,其中早期初始化用于准备cpuset和CPU子系统,确保它们在系统运行时能够正常工作。g_signal_emit源码通过这些步骤,我们可以深入理解cgroup如何在Linux内核中实现资源管理和进程控制。

Linux内核源码解析---mount挂载原理

Linux磁盘挂载命令"mount -t xxx /dev/sdb1 abc/def/"的底层实现原理非常值得深入了解。从内核初始化的vfsmount开始说起。

内核初始化过程中,主要关注"main.c"中的vfs_caches_init函数,这个方法与mount紧密相连。接着,跟进"mnt_init"和"namespace.c",关键在于最后的三个函数,它们控制了挂载过程的实现。

在"mount.c"中,sysfs_fs_type结构中包含了获取超级块的函数指针,而"init_rootfs"则注册了rootfs类型的文件系统。挂载系统调用sys_mount中的dev_name, dir_name和type参数,分别对应设备名称、挂载目录和文件系统类型。

"do_mount"方法通过path_lookup收集挂载目录信息,创建nameidata结构,然后调用do_add_mount进行实际挂载。这个过程涉及do_kern_mount和graft_tree,尽管具体实现较为复杂,但核心在于创建vfsmount并将其与namespace关联。

在"graft_tree"中的判断逻辑中,vfsmount被创建并与其父mount和挂载目录的dentry建立关系。在"attach_mnt"方法中,新vfsmount与现有结构关联,设置挂载点和父vfsmount,最终形成挂载的概念,即为设备分配vfsmount,并将其与指定目录和vfsmount结合,成为vfs系统的一部分。

Linux内核源码解析---EPOLL实现4之唤醒等待进程与惊群问题

在Linux内核源码的EPOLL实现中,第四部分着重探讨了数据到来时如何唤醒等待进程以及惊群问题。当网卡接收到数据,DMA技术将数据复制到内存RingBuffer,通过硬中断通知CPU,然后由ksoftirqd线程处理,最终数据会进入socket接收队列。虽然ksoftirqd的创建过程不在本节讨论,但核心是理解数据如何从协议层传递到socket buffer。

在tcp_ipv4.c中,当接收到socket buffer时,会首先在连接表和监听表中寻找对应的socket。一旦找到,进入tcp_rcv_established函数,这里会检查socket是否准备好接收数据,通过调用sock_data_ready,其初始值为sock_def_readable,进而进入wake_up函数,itop4418源码资料唤醒之前挂上的wait_queue_t节点。

在wake_up方法中,会遍历链表并回调ep_poll_callback,这个函数是epoll的核心逻辑。然而,如果epoll的设置没有启用WQ_FLAG_EXCLUSIVE,就会导致惊群效应,即唤醒所有阻塞在当前epoll的进程。这在default_wake_function函数中体现,如果没有特殊标记,进程会立即被唤醒并进入调度。

总结来说,epoll的唤醒过程涉及socket buffer、协议层处理、链表操作以及回调函数,其中惊群问题与默认的唤醒策略密切相关。理解这些细节,有助于深入理解Linux内核中EPOLL的异步操作机制。

剖析Linux内核源码解读之《实现fork研究(二)》

本文深入剖析了Linux内核源码中fork实现的核心过程,重点在于copy_process函数的解析。在Linux系统中,应用层可以通过fork创建子进程或子线程,而内核并不区分两者,它们共享相同的task_struct结构,用于描述进程或线程的状态、资源等。task_struct包含了进程或线程所有关键数据结构,如内存描述符、文件描述符、信号处理等,是内核调度程序识别和管理进程的重要依据。

copy_process作为fork实现的关键,其主要任务是初始化task_struct结构,分配新进程的PID,并将其加入到运行队列。这个过程中,内核栈的初始化导致了fork()调用的两次返回值不同,这与copy_thread函数中父进程复制内核栈至子进程并清零寄存器值有关。这样,子进程返回0,而父进程继续执行copy_thread后续操作,最后返回子进程的PID。

对于线程的独有和共享资源,独有资源通常包括线程特定的数据结构和状态,而共享资源则涉及父进程与线程间的共享内存、文件描述符和信号处理等。这些资源的管理对于多线程程序的正确运行至关重要,需确保线程间资源的互斥访问和安全共享。

v. 鸿蒙内核源码分析(ELF格式) | 应用程序入口并非main | 百篇博客分析OpenHarmony源码

鸿蒙内核源码分析(ELF格式篇) | 应用程序入口并非main

深入解析ELF格式与鸿蒙源码的关系,探寻应用程序入口的页游神奇宝贝源码奥秘。本文将带你从一段简单的C代码开始,跟踪其编译成ELF格式后的神秘结构,揭秘ELF的组成与内部运作机制。

以E:\harmony\docker\case_code_目录下的main.c文件为例,通过编译生成ELF文件,运行后使用readelf -h命令查看应用程序头部信息。了解ELF文件的全貌,从ELF头信息、段信息、段区映射关系、区表等多方面深入探讨。

ELF格式文件由四大部分组成:头信息、段信息、段区映射关系和区表。头信息包含关键元数据,如文件类型、字节顺序、文件大小等;段信息描述了可执行代码和数据段的属性和位置;段区映射关系展示了段与区的关联;区表则存储了每个区的详细信息。

通过readelf -l命令,可以观察到段信息及其在程序中的作用,如初始化数组、动态链接、栈区等。在运行时,不同段以特定方式映射到内存中,实现代码的加载和执行。

在深入分析后,发现应用程序的真正入口并非通常理解的main函数,而是一个名为_start的特殊函数。这揭示了鸿蒙内核在启动时的执行流程,以及如何在ELF格式中组织和加载代码。

本文以ELF格式为切入点,带你全面理解鸿蒙内核源码的组织结构与运行机制。通过百万汉字注解,带你精读内核源码,深入挖掘其地基。在Gitee仓(gitee.com/weharmony/ker...)同步注解,共同探索鸿蒙研究站(weharmonyos)的奥秘。

Linux内核源码解析---万字解析从设计模式推演per-cpu实现原理

引子

在如今的大型服务器中,NUMA架构扮演着关键角色。它允许系统拥有多个物理CPU,不同NUMA节点之间通过QPI通信。虽然硬件连接细节在此不作深入讨论,但需明白每个CPU优先访问本节点内存,当本地内存不足时,可向其他节点申请。从传统的SMP架构转向NUMA架构,主要是为了解决随着CPU数量增多而带来的总线压力问题。

分配物理内存时,numa_node_id() 方法用于查询当前CPU所在的支付商户管理平台源码NUMA节点。频繁的内存申请操作促使Linux内核采用per-cpu实现,将CPU访问的变量复制到每个CPU中,以减少缓存行竞争和False Sharing,类似于Java中的Thread Local。

分配物理页

尽管我们不必关注底层实现,buddy system负责分配物理页,关键在于使用了numa_node_id方法。接下来,我们将深入探索整个Linux内核的per-cpu体系。

numa_node_id源码分析获取数据

在topology.h中,我们发现使用了raw_cpu_read函数,传入了numa_node参数。接下来,我们来了解numa_node的定义。

在topology.h中定义了numa_node。我们继续跟踪DECLARE_PER_CPU_SECTION的定义,最终揭示numa_node是一个共享全局变量,类型为int,存储在.data..percpu段中。

在percpu-defs.h中,numa_node被放置在ELF文件的.data..percpu段中,这些段在运行阶段即为段。接下来,我们返回raw_cpu_read方法。

在percpu-defs.h中,我们继续跟进__pcpu_size_call_return方法,此方法根据per-cpu变量的大小生成回调函数。对于numa_node的int类型,最终拼接得到的是raw_cpu_read_4方法。

在percpu.h中,调用了一般的read方法。在percpu.h中,获取numa_node的绝对地址,并通过raw_cpu_ptr方法。

在percpu-defs.h中,我们略过验证指针的环节,追踪arch_raw_cpu_ptr方法。接下来,我们来看x架构的实现。

在percpu.h中,使用汇编获取this_cpu_off的地址,代表此CPU内存副本到".data..percpu"的偏移量。加上numa_node相对于原始内存副本的偏移量,最终通过解引用获得真正内存地址内的值。

对于其他架构,实现方式相似,通过获取自己CPU的偏移量,最终通过相对偏移得到pcp变量的地址。

放入数据

讨论Linux内核启动过程时,我们不得不关注per-cpu的值是如何被放入的。

在main.c中,我们以x实现为例进行分析。通过setup_percpu.c文件中的代码,我们将node值赋给每个CPU的numa_node地址处。具体计算方法通过early_cpu_to_node实现,此处不作展开。

在percpu-defs.h中,我们来看看如何获取每个CPU的numa_node地址,最终还是通过简单的偏移获取。需要注意如何获取每个CPU的副本偏移地址。

在percpu.h中,我们发现一个关键数组__per_cpu_offset,其中保存了每个CPU副本的偏移值,通过CPU的索引来查找。

接下来,我们来设计PER CPU模块。

设计一个全面的PER CPU架构,它支持UMA或NUMA架构。我们设计了一个包含NUMA节点的结构体,内部管理所有CPU。为每个CPU创建副本,其中存储所有per-cpu变量。静态数据在编译时放入原始数据段,动态数据在运行时生成。

最后,我们回到setup_per_cpu_areas方法的分析。在setup_percpu.c中,我们详细探讨了关键方法pcpu_embed_first_chunk。此方法管理group、unit、静态、保留、动态区域。

通过percpu.c中的关键变量__per_cpu_load和vmlinux.lds.S的链接脚本,我们了解了per-cpu加载时的地址符号。PERCPU_INPUT宏定义了静态原始数据的起始和结束符号。

接下来,我们关注如何分配per-cpu元数据信息pcpu_alloc_info。percpu.c中的方法执行后,元数据分配如下图所示。

接着,我们分析pcpu_alloc_alloc_info的方法,完成元数据分配。

在pcpu_setup_first_chunk方法中,我们看到分配的smap和dmap在后期将通过slab再次分配。

在main.c的mm_init中,我们关注重点区域,完成map数组的slab分配。

至此,我们探讨了Linux内核中per-cpu实现的原理,从设计到源码分析,全面展现了这一关键机制在现代服务器架构中的作用。

Linux 内核 rcu(顺序) 锁实现原理与源码解析

RCU 的全称是 Read-Copy-Update,代表读取-复制-更新,作为 Linux 内核提供的一种免锁机制,它在锁实现方案中独树一帜。在面对自旋锁、互斥锁、信号量、读写锁、req 顺序锁等常规锁结构时,RCU 提供了另一种思路,追求在无需阻塞操作的前提下实现高效并发。

RCU 通过链表操作实现了读写分离。在读任务执行时,可以安全地读取链表中的节点。然而,若写任务在此期间修改或删除节点,则可能导致数据不一致问题。因此,RCU 采用先读取后复制、再更新的策略,实现无锁状态下的高效读取。这与 Copy-On-Write 技术相似,先复制一份数据,对副本进行修改,完成后将修改内容覆盖原数据,从而达到高效、无阻塞的操作。

图中展示了链表操作的细节,每个节点包含数据字段和 next 指针字段。在读任务读取节点 B 时,写任务 N 执行删除操作,导致 next 指针指向错误的节点,从而引发业务异常。此时,若采用互斥锁,则能够保证数据一致性,但系统性能会受到一定程度的影响。读写锁和 seq 锁虽然在一定程度上改善了性能,但仍存在一定的问题,如写者饥饿状态或读者阻塞。

RCU 的实现旨在避免以上问题,让读任务直接获取锁,无需像 seq 锁那样进行重试,也不像读写锁和互斥锁那样完全阻塞读操作。RCU 通过在读任务完成后再删除节点,实现先修改指针,保留副本,注册回调,等待读任务释放副本,最后删除副本的过程。这种机制使得读任务无需阻塞等待写任务,有效提高了系统性能。

内核源码中,RCU 通过 `rcu_assign_pointer` 修改指针,`synchronize_kernel` 等待所有读任务完成,而读任务则通过 `rcu_read_lock`、`rcu_read_unlock` 和 `rcu_dereference` 来上锁、解锁和获取引用值。这种设计在一定程度上借鉴了垃圾回收机制,通过写者修改引用并保留副本,待所有读任务完成后删除副本,从而实现高效、并发的操作。在 `rcu_read_lock` 中,禁止抢占确保了所有读任务完成后才释放锁,开启抢占,这为读任务提供了宽限期,等待所有任务完成。

总之,RCU 作为一种创新的锁实现机制,通过链表操作和读写分离策略,为 Linux 内核提供了一种高效、无阻塞的并发控制方式。其源码解析展示了如何通过内核函数实现读取-复制-更新的机制,以及如何通过宽限期确保数据一致性,从而在保证性能的同时,提供了一种优雅的并发控制解决方案。

简单概括Linux内核源码高速缓存原理(图例解析)

高速缓存(cache)概念和原理涉及在处理器附近增加一个小容量快速存储器(cache),基于SRAM,由硬件自动管理。其基本思想为将频繁访问的数据块存储在cache中,CPU首先在cache中查找想访问的数据,而不是直接访问主存,以期数据存放在cache中。

Cache的基本概念包括块(block),CPU从内存中读取数据到Cache的时候是以块(CPU Line)为单位进行的,这一块块的数据被称为CPU Line,是CPU从内存读取数据到Cache的单位。

在访问某个不在cache中的block b时,从内存中取出block b并将block b放置在cache中。放置策略决定block b将被放置在哪里,而替换策略则决定哪个block将被替换。

Cache层次结构中,Intel Core i7提供一个例子。cache包含dCache(数据缓存)和iCache(指令缓存),解决关键问题包括判断数据在cache中的位置,数据查找(Data Identification),地址映射(Address Mapping),替换策略(Placement Policy),以及保证cache与memory一致性的问题,即写入策略(Write Policy)。

主存与Cache的地址映射通过某种方法或规则将主存块定位到cache。映射方法包括直接(mapped)、全相联(fully-associated)、一对多映射等。直接映射优点是地址变换速度快,一对一映射,替换算法简单,但缺点是容易冲突,cache利用率低,命中率低。全相联映射的优点是提高命中率,缺点是硬件开销增加,相应替换算法复杂。组相联映射是一种特例,优点是提高cache利用率,缺点是替换算法复杂。

cache的容量决定了映射方式的选取。小容量cache采用组相联或全相联映射,大容量cache采用直接映射方式,查找速度快,但命中率相对较低。cache的访问速度取决于映射方式,要求高的场合采用直接映射,要求低的场合采用组相联或全相联映射。

Cache伪共享问题发生在多核心CPU中,两个不同线程同时访问和修改同一cache line中的不同变量时,会导致cache失效。解决伪共享的方法是避免数据正好位于同一cache line,或者使用特定宏定义如__cacheline_aligned_in_smp。Java并发框架Disruptor通过字节填充+继承的方式,避免伪共享,RingBuffer类中的RingBufferPad类和RingBufferFields类设计确保了cache line的连续性和稳定性,从而避免了伪共享问题。

年度Linux6.9内核最新源码解读-网络篇-server端-第一步创建--socket

深入解析年Linux 6.9内核的网络篇,从服务端的第一步:创建socket开始。理解用户空间与内核空间的交互至关重要。当我们在用户程序中调用socket(AF_INET, SOCK_STREAM, 0),实际上是触发了从用户空间到内核空间的系统调用sys_socket(),这是创建网络连接的关键步骤。 首先,让我们关注sys_socket函数。这个函数在net/socket.c文件的位置,无论内核版本如何,都会调用__sys_socket_create函数来实际创建套接字,它接受地址族、类型、协议和结果指针。创建失败时,会返回错误指针。 在socket创建过程中,参数解析至关重要:网络命名空间(net):隔离网络环境,每个空间有自己的配置,如IP地址和路由。

协议族(family):如IPv4(AF_INET)或IPv6(AF_INET6)。

套接字类型(type):如流式(SOCK_STREAM)或数据报(SOCK_DGRAM)。

协议(protocol):如TCP(IPPROTO_TCP)或UDP(IPPROTO_UDP),默认值自动选择。

结果指针(res):指向新创建的socket结构体。

内核标志(kern):区分用户空间和内核空间的socket。

__sock_create函数处理创建逻辑,调用sock_map_fd映射文件描述符,支持O_CLOEXEC和O_NONBLOCK选项。每个网络协议族有其特有的create函数,如inet_create处理IPv4 TCP创建。 在内核中,安全模块如LSM会通过security_socket_create进行安全检查。sock_alloc负责内存分配和socket结构初始化,协议族注册和动态加载在必要时进行。RCU机制保护数据一致性,确保在多线程环境中操作的正确性。 理解socket_wq结构体对于异步IO至关重要,它协助socket管理等待队列和通知。例如,在TCP协议族的inet_create函数中,会根据用户请求找到匹配的协议,并设置相关的操作集和数据结构。 通过源码,我们可以看到socket和sock结构体的关系,前者是用户空间操作的抽象,后者是内核处理网络连接的实体。理解这些细节有助于我们更好地编写C++网络程序。 此外,原始套接字(如TCP、UDP和CMP)的应用示例,以及对不同协议的深入理解,如常用的IP协议、专用协议和实验性协议,是进一步学习和实践的重要部分。2025-01-19 21:45

2025-01-19 21:32

2025-01-19 20:26

2025-01-19 20:15

2025-01-19 19:56

2025-01-19 19:29