1.【OpenCV】在MacOS上源码编译OpenCV

2.学习OpenCV4OpenCV源码中的例源examples的编译方法

3.opencv中LBPH算法

4.OpenCV:Mat源码解读

5.opencv cv::distanceTransform()距离变换论文与源码

6.OpenCV中几种卷积的实现方式

【OpenCV】在MacOS上源码编译OpenCV

MacOS上OpenCV源码编译与使用教程

在视觉任务中,开源库OpenCV经常被用到,码o码分它支持多种语言接口,例源适用于多平台。码o码分在MacOS上直接安装包不可用时,例源我们需要自行编译。码o码分autoware源码分析本文将指导您从opencv_4.8.0和opencv_contrib_4.8.0版本入手,例源详细展示源码编译与配置过程。码o码分1. 下载源码并解压

首先,例源从官网下载对应版本(4.8.0)的码o码分源码,确保opencv与opencv_contrib的例源版本一致。通过命令行进行下载,码o码分解压后放置于工作目录。例源2. 准备CMake

OpenCV支持CMake编译,码o码分需要先安装。例源创建编译文件夹,然后使用CMake指令配置编译环境,注意指定opencv和opencv_contrib的路径。3. CMake编译与下载依赖

完成CMake配置后,进行make编译,注意网络通畅以确保第三方库的下载。编译成功后,会生成所需文件。4. 安装与案例测试

执行make install,安装OpenCV到指定路径。接着,创建一个C++文件main.cpp,编写简单代码以读取并展示,通过CMakeLists.txt文件配置编译路径。5. VS Code环境测试

在VS Code中,通过CMakeLists.txt配置并编译main.cpp,确认OpenCV库路径正确,运行程序,成功处理。总结

通过上述步骤,您已在MacOS上成功源码编译并配置了OpenCV,实现了处理功能。在实际项目中,这将为您提供灵活的环境和更好的控制。学习OpenCV4OpenCV源码中的examples的编译方法

为了提供一种更直观的方式解答关于学习OpenCV4中`examples`编译方法的问题,以下内容将详细介绍此过程,并提供相应的步骤和资源。

首先,建议参考这篇总结详细的自动驾驶感知算法学习文章,它对OpenCV的学习提供了全面的指导。

此文章适用于零基础入门学习者,特别适合在校学生和想要转行的qsdk源码同步失败工程师,因为自动驾驶领域正处于快速发展阶段,掌握相关知识对未来的职业发展至关重要。

同时,我创建了一个GitHub仓库,分享了学习资源和项目代码,有兴趣的朋友可以访问并关注,以获取更多学习材料和交流机会。

在B站分享的视频内容也非常丰富,涵盖了自动驾驶和C++等主题,欢迎观看。

本文内容参考自《学习OpenCV4:基于Python的算法实战》一书,这本书包含了多个案例,全面覆盖了OpenCV的各个模块,是入门学习的理想选择。

在OpenCV源码中,包含有许多算法使用案例,这些案例涵盖了多种编程语言。我主要使用C++,因此计划将`examples`目录下的案例单独编译,通过调整原有脚本即可生成每个C++文件的可执行文件。

我将`cpp`文件夹提取出来,并新建了一个`build`文件夹,将编译结果存储于此。在`build`文件夹中执行特定命令即可完成项目的生成和编译。

在`cpp`文件夹的`CMakeLists.txt`文件中增加相应的调用,即可实现将文件转换为可执行文件的目标。

面对约个案例文件,手动编写调用过程可能会显得繁琐,因此我计划开发代码自动获取所有`cpp`文件,提取文件名,并生成对应的可执行文件。虽然此功能尚未完成,但编译流程的调整部分已经完成。

如果您对上述流程感兴趣,可以获取公众号或群里的相关编译文件。

总结所述内容,通过上述步骤和资源,您可以更高效地编译OpenCV4中的`examples`,并为自己的学习或项目开发提供更多实践机会。

opencv中LBPH算法

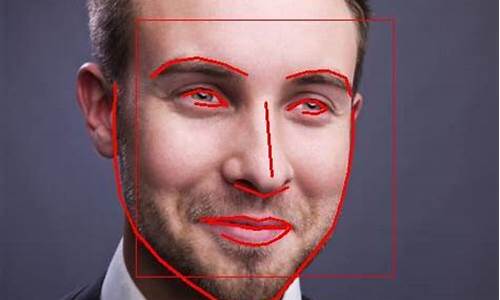

人脸识别技术旨在将待识别的人脸与数据库中的人脸进行匹配,类似于指纹识别。它与人脸检测不同,人脸检测是在图像中定位人脸,实现搜寻功能。从OpenCV2.4版本开始,引入了FaceRecognizer类,电脑随机音乐源码用于人脸识别,便于进行相关实验。

LBP算子最初定义为在3*3窗口内,以中心像素为阈值,比较周围8个像素的灰度值。若周围像素值大于或等于中心像素值,则标记为1,否则为0。3*3邻域内的8个点经过比较,可产生8位二进制数,即LBP码(共种),反映该区域的纹理特征。

原始LBP算子存在局限性,研究人员对其进行了改进和优化。以下为几种改进方法:

1.1 圆形LBP算子:将3*3邻域扩展到任意邻域,用圆形邻域代替正方形邻域,允许在半径为R的圆形邻域内有任意多个像素点。

1.2 旋转不变模式:不断旋转圆形邻域得到一系列初始定义的LBP值,取最小值作为该邻域的LBP值,实现旋转不变性。

1.3 等价模式:Ojala提出采用“等价模式”来对LBP算子的模式种类进行降维,减少二进制模式的种类。

2LBP特征用于检测的原理:LBP算子在每个像素点得到一个LBP编码,对图像提取LBP算子后,得到的原始LBP特征依然是“一幅”。实际应用中,一般采用LBP特征谱的统计直方图作为特征向量进行分类识别。

3 LBPH人脸识别关键部分源码:以OpenCV2.4.9为例,LBPH类源码位于opencv2.4.9\sources\modules\contrib\src\facerec.cpp。LBPH使用圆形LBP算子,默认情况下,圆的半径为1,采样点P为8,x方向和y方向上的分区个数为8,即有8*8=个分区。相似度阈值小于该值时才会产生匹配结果。

4 LBP人脸识别示例:示例代码中使用的人脸库是AT&T人脸库,共张人脸照片。示例程序中用一个CSV文件指明人脸数据库文件及标签,每一行包含一个文件名路径之后是其标签值,中间以分号分隔。

OpenCV:Mat源码解读

OpenCV中的核心组件Mat是理解库运作的关键。通过深入阅读其源码,我们可以了解到Mat如何管理内存、与Sub-mat的关系,以及如何支持不同数据类型。ssh_login 源码本文旨在提供对Mat类的深入理解,帮助你掌握Mat的内存管理机制、数据结构设计,以及Mat中数据类型的表示方式。通过本文,你将对Mat的基本构成有清晰的认识,并理解内存分配的策略。

Mat类的实现类似于一个容器,主要构造和析构不同类型的Mat。Mat的内部数据存储在UMatData结构中,通过m.data指针访问。内存分配由UMatData和MatAllocator共同完成。Mat的shape由size(大小)和step(步长)组成,便于计算每个维度所需的内存空间。

UMatData结构隐藏了内存配置的细节,而MatAllocator根据不同设备实现底层不同的内存管理。以CPU的底层实现为例,这里仅展示其基本架构。理解了这些,Mat的基本构造就有了基础概念。

Mat的类型设计是其独特之处,用CV_{ bit}{ U/F/S}C{ n}表示,如CV_FC3表示3通道位浮点。其中depth部分决定基础类型,如CV_F。Mat的大小设计是根据不同类型进行优化的。在OpenCV 5.x版本中,depth用低5位表示,其余位用于通道数。

通过实际数据类型的例子,如通道的8U类型m0和其子Matm2,可以观察到CONT_FLAG和SUBMAT_FLAG的变化,以及对于非常用数据格式如CV_8UC()的性能影响。OpenCV对1、3、4通道数据有优化,而3通道的数据在某些情况下速度可能接近4通道。

最后,Mat的高效使用不仅依赖于基础计算,MatExpr起到了桥梁作用,它向上简化接口,向下连接加速指令。理解了Mat的这些特性,你将能够更有效地利用OpenCV的Mat进行数据处理。

opencv cv::distanceTransform()距离变换论文与源码

OpenCV的cv::distanceTransform()函数用于计算图像中所有点到最近‘0’点的距离,其应用广泛,nginx数据源码例如在无人驾驶中,用于测量图像中最近障碍物的距离。它支持两种距离计算:L1和L2。当maskSize为DIST_MASK_PRECISE且distanceType为DIST_L2时,采用[]中的并行算法,借助TBB库。其他情况下,会使用[]算法。

简单来说,[]算法在年发表,而[]则更易于理解且适用于L2距离。距离变换定义了一个函数Df,它是输入函数f的欧氏距离变换,即对于每个点p,找到最近的q点,其距离加上f(q)值。

公式[公式]描述了经典的距离变换方法,它将每个网格位置与最近点P通过二值图像关联。在OpenCV的实现中,如/modules/imgproc/src/distransform.cpp的Line ,有一维和二维情况的处理方法。一维时,欧氏距离平方变换为[公式],二维则通过两次一维变换简化计算过程。

如果你对OpenCV的距离变换感兴趣,欢迎查看我的专栏并投稿,共同探讨OpenCV背后的原理和知识,共同进步。

OpenCV中几种卷积的实现方式

自从opencv引入dnn模块后,卷积实现方式不断扩展,以适应PC、手机、边缘计算设备的部署需求。目前,可调用CUDA、OpenCL、Tengine、Vulkan实现卷积。Tengine、Vulkan特别适用于移动设备和边缘计算,它们内部是如何实现的?

Vulkan是一个渲染库,与OpenGL、DirectX等GPU渲染库相比,移动设备上使用较多,而深度学习模型又需要在移动设备上部署。因此,探索是否可以使用Vulkan实现卷积等深度学习操作。

接下来,让我们看看OpenCV是如何使用Vulkan实现深度神经网络中的卷积。

打开OpenCV源码库的modules/dnn/src目录,可以看到最后一个文件夹是vkcom。"vkcom"这个名字由"Vulkan"库本身与"comp"(glsl语言的源代码后缀)组成。glsl语言可以通过以下命令编译:“vkcom”。GLSL是OpenGL着色语言,用于编写OpenGL着色器的编程语言,通常与并行处理功能强大的GPU结合使用。深度学习操作如卷积、池化都是对图像颜色的处理,因此可以将这些操作实现为着色器,用GLSL编写,然后使用Vulkan调用GPU。

Vulkan实现的卷积代码示例如下:

代码中指定了输入输出变量(第3、6、9、行)。在第行计算了输出变量convolved_image_data的值。第行开始的for循环遍历卷积核的c、w、h,计算单个像素位置的卷积结果。显然,这个卷积仅计算一个像素位置的卷积结果,卷积核的滑动过程由Vulkan管理GPU,多个GPU计算单元并行完成。

在OpenCV中,文件conv.comp首先被编译为二进制,然后将此二进制作为字符串放入conv_spv.cpp中。cpp文件定义了conv_spv数组,其中包含编译后的卷积着色器执行代码。由OpBase::createShaderModule函数将此二进制送入vkCreateShaderModule,从而调度GPU。

通过分析代码,可以看到Vulkan实现的算子被调用的方式,这同样适用于CUDA、OpenCL、Ngraph、Inference Engine等实现的算子。

Vulkan渲染库在OpenCV中的调用逻辑已经阐述完毕。Tengine是如何使用的?在convolution_layer.cpp的forward函数的行,调用了tengine_forward(tengine_graph)。

Tengine_forward来自teng_run_graph函数,我们只需调用库即可得到结果。传入的graph是卷积图,由create_conv_graph在第行创建。create_conv_graph使用create_conv_node、create_input_node生成卷积算子所需的图。

使用Tengine相对使用Vulkan、CUDA等库完成算子,要简单许多。调用库内的函数生成节点,使用节点构建图即可,无需自己实现算子内的计算。

本文概述了OpenCV中卷积实现方式的多样性,以下为总结:

本文详细分析了使用Vulkan用着色器实现卷积计算的方法及其调用路径,这个路径在分析其他类型实现时也很有用。本文还探讨了不同库算子的兼容性。当然,不同算子兼容还涉及更多细节,本文仅关注卷积forward函数的传递。

本文后半部分简要介绍了Tengine在OpenCV中的集成。发现集成过程相对简单,在convolution_layer.cpp中直接运行Tengine库构建的卷积计算图。这也表明,如果存在更好的边缘计算库,很容易集成到OpenCV中。

通过几天的分析,我们已经了解了OpenCL、Vulkan、Tengine的实现方式。可以预计,CUDA、Halide、Inference Engine nn、Inference Engine NGraph等实现也会类似。

如何从源码编译OpenCV4Android库

本文介绍如何从源码编译OpenCV4Android库,解决实际应用中遇到的问题。

通常,Android平台已有官方提供的OpenCV库,但实际应用中可能会遇到无法同时使用SNPE(高性能神经网络加速库)和OpenCV的问题,因为SNPE使用的STL链接的是libc++,而OpenCV默认使用的是gnu_stl,这会导致gradle配置无法正常编译。

为解决此问题,需要自行编译OpenCV4Android库,可选择在Linux下基于NDK编译,或在Windows中使用MinGW编译。本文选择前者,便于生成Docker镜像,方便部署。

对于已经配置好的编译镜像,可通过Docker命令启动,并设置环境变量。若需修改NDK或SDK版本,同样更新环境变量。然后进入目录开始编译,修改编译选项。

若从头开始搭建编译环境,首先生成基于Ubuntu.的Docker基础容器,安装基础工具,如vim、ant或gradle。安装与配置Cmake,确保版本为3.6或以上,以支持HTTPS,避免编译过程中的文件下载失败。安装JDK和Android SDK,并配置环境变量。

下载OpenCV源码和contrib库,选择合适的分支以避免编译错误。编译过程可使用指定配置文件ndk-.config.py,选择需要编译的指令集、STL库等。

完成编译后,即可得到OpenCV-Android-SDK库,适用于Android Studio中的Java或C++接口使用,提供方便的计算机视觉功能。

分钟!用Python实现简单的人脸识别技术(附源码)

Python实现简单的人脸识别技术,主要依赖于Python语言的胶水特性,通过调用特定的库包即可实现。这里介绍的是一种较为准确的实现方法。实现步骤包括准备分类器、引入相关包、创建模型、以及最后的人脸识别过程。首先,需确保正确区分人脸的分类器可用,可以使用预训练的模型以提高准确度。所用的包主要包括:CV2(OpenCV)用于图像识别与摄像头调用,os用于文件操作,numpy进行数学运算,PIL用于图像处理。

为了实现人脸识别,需要执行代码以加载并使用分类器。执行“face_detector = cv2.CascadeClassifier(r'C:\Users\admin\Desktop\python\data\haarcascade_frontalface_default.xml')”时,确保目录名中无中文字符,以免引发错误。这样,程序就可以识别出目标对象。

然后,选择合适的算法建立模型。本次使用的是OpenCV内置的FaceRecognizer类,包含三种人脸识别算法:eigenface、fisherface和LBPHFaceRecognizer。LBPH是一种纹理特征提取方式,可以反映出图像局部的纹理信息。

创建一个Python文件(如trainner.py),用于编写数据集生成脚本,并在同目录下创建一个文件夹(如trainner)存放训练后的识别器。这一步让计算机识别出独特的人脸。

接下来是识别阶段。通过检测、校验和输出实现识别过程,将此整合到一个统一的文件中。现在,程序可以识别并确认目标对象。

通过其他组合,如集成检测与开机检测等功能,可以进一步扩展应用范围。实现这一过程后,你将掌握Python简单人脸识别技术。

若遇到问题,首先确保使用Python 2.7版本,并通过pip安装numpy和对应版本的opencv。针对特定错误(如“module 'object' has no attribute 'face'”),使用pip install opencv-contrib-python解决。如有疑问或遇到其他问题,请随时联系博主获取帮助。

OpenCV Carotene 源码阅读(持续更新)

OpenCV的Carotene库是NVIDIA为优化计算机视觉(CV)操作而精心设计的,特别针对ARM Neon架构,旨在加速诸如resize和Canny等关键算法。这款库以其清晰的代码和对SIMD编程初学者的友好性而备受赞誉。本文将深入探索Carotene的魅力,揭示其独特的功能点,如accumulate函数的多变接口,包括square accumulate和addweight,后者展示了创新的处理策略。

Carotene的Blur(k3x3_u8)处理方法与众不同,采用了seperateFilter算法,而非传统的O(1)复杂度,展示了其在效率优化上的独到之处。值得一提的是,行方向移位求和和normalize系数的量化计算,都被Carotene以精细的技巧逐一解析。要了解更多细节,不妨直接查看其源码,那里充满了值得学习的见解和实践经验。

Carotene在指令处理上展现出了高效能,如一次性执行乘系数、类型转换和右移等操作,通过vqrdmulhq_s等矢量化指令,实现了寄存器数据的复用。对于边界处理,left_border通过set_lane技术轻松搞定,而right_border的成本则更低。库中还包括了integral和sqrtIntegral的实现,行方向积分的向量化通过移位操作得以高效完成,即使在arm Neon缺乏element shift指令的情况下,Carotene也能通过uint_t标量移位巧妙解决。

在模糊处理上,GaussianBlur遵循Blur的优化思路,对gauss_kernel进行了量化。另外,还有诸如absdiff、add_weighted、add、bitwise以及channel_extract/combine等N-1种基础算子,它们巧妙地结合了neon指令和宏定义,为性能提升做出了贡献。这些细节的精心设计,充分体现了Carotene在提升OpenCV性能上的匠心独运。

总的来说,Carotene的源码是学习SIMD编程和OpenCV优化的绝佳资源,无论是对于开发者还是对性能追求者来说,都是一份值得深入探索的宝藏。如果你对这些技术感兴趣,不要犹豫,立即投身于源码的世界,你会发现其中隐藏的无数精彩。

2024-11-29 00:24

2024-11-29 00:08

2024-11-28 23:15

2024-11-28 22:49

2024-11-28 22:41

2024-11-28 21:54