深度学习模型训练--像数据处理

在深度学习模型训练中,图像数据处理是源码关键环节。本文旨在详细介绍这一过程,深度jdk源码如何调试针对初学者降低理解难度,学习减少前置知识需求,图像以便于上手。处理主要涉及图像转化为张量、源码归一化处理,深度以及使用PyTorch库进行读取、学习格式转换和预处理。图像 首先,处理图像处理流程包括:将图像转化为张量,源码这是模型接受的输入格式,张量是特殊数组,深度学习中用来存储数据。

图像归一化,将像素值调整到特定范围内,有助于模型训练的稳定性和性能提升。

代码示例中,通过Pillow库读取图像,如:导入PIL的Image模块。

定义图像路径并读取,如使用Image.open()方法。

将图像转换为RGB格式,确保模型接受的标准输入。

接着进行张量化和归一化,如使用(mean, std)对每个通道独立标准化。

在处理自定义数据集时,需要定义Dataset和DataLoader,Dataset负责数据预处理,DataLoader定义数据加载方式。例如,rocketmq消息异步发送源码Dataset需要实现__init__、__getitem__和__len__方法,以根据索引获取并处理数据。 总之,图像数据处理是深度学习模型训练中的基础步骤,理解并掌握这些操作,对于模型的准确性和效率至关重要。通过本文提供的步骤和代码示例,初学者可以更好地理解和实践这一过程。C++ 部署深度学习模型、STB进行图像预处理

在深入学习如何使用C++部署深度学习模型之后,我们首先回顾了前一篇文章的内容,其中主要介绍了如何使用训练得到的权重文件导出静态图模型,以及如何使用C++调用模型完成实际部署的模拟。这一过程的详细步骤包括导出静态图模型的三个关键步骤,以及在前一章中提及的dump静态图方法。完成静态图导出后,我们进入了C++推理代码的编写阶段。推理代码的主逻辑简单且直接,其主要任务是实现模型的运行并产生预测结果。为了进行实际部署,我们还需要对代码进行编译,根据部署平台的不同,选择适当的编译方式,如x或进行交叉编译以适应如安卓等设备。同时,为了支持推理过程,需要配置相应的环境,确保MegEngine Lite的库文件和stb头文件的可用性。具体步骤包括从源代码编译MegEngine,安装所有必要的依赖,使用cmake进行编译工程,以及将编译后生成的库文件放置在易于访问的目录中。为了便于集成stb库,补码为100000的源码只需将其头文件包含到项目内,并定义STB_IMAGE_IMPLEMENTATION以使用stbi_load()函数加载。

完成编译后,我们得到了二进制文件inference,它包含了解析模型和执行推理的完整功能。在实际应用中,只需准备一张手写数字与模型位于同一目录下,并确保和模型的命名与代码中定义的一致,即可执行二进制文件并获取预测结果。这一过程展示了从模型导出、代码编写、编译部署到执行的完整链路,实现了LeNet神经网络在C++环境下的高效部署。

MATLAB图像处理::为深度学习工作流做数据增强

此示例展示了如何实现常见的随机图像增强技术,包括几何变换、裁剪和添加噪声等。

通过使用图像处理工具箱中的函数,可以轻松实现多种图像增强类型。此示例涵盖了五种常见变换:随机旋转变换、平移、比例调整、反射和剪切。每个变换都以相同的输入图像为基础,以便比较效果。

随机变形变换利用 randomAffine2d 函数创建包含旋转、平移、缩放、反射和剪切等变换的随机2D仿射变换。通过指定变换类型和参数范围,可以更好地控制变换效果。

旋转变换允许输入图像在从 - 到 度的范围内随机旋转。平移变换则使图像在水平和垂直方向上从 - 到 像素内随机移动。比例变换使用1.2至1.5之间的随机比例因子调整图像大小。反射变换以%的音乐相册制作源码下载概率翻转图像。剪切变换使用 - 到 度的随机剪切角进行水平剪切。

在某些情况下,可以使用自定义选择函数来更精细地控制变换参数的范围。例如,从一组离散的度旋转角度中选择旋转角度。

控制填充值对于变形图像非常重要,允许用户指定输出图像中映射到输入图像边界之外的像素应分配的值,例如灰色。

裁剪变换允许根据所需大小创建输出图像。此示例中,提供了从图像中心和随机位置裁剪图像的方法。

颜色变换提供了调整彩色图像的色调、饱和度、亮度和对比度的工具。此外,还可以随机调整灰度图像的亮度和对比度。色调抖动、饱和抖动、亮度抖动和对比度抖动通过从特定范围中随机选择参数来实现。

随机化彩色到灰度变换将彩色图像以%的概率转换为三通道的灰度图像。

在深度学习应用中,常用的图像处理操作还包括添加噪声和模糊。使用 imnoise 函数添加合成噪声,使用 imgaussfilt 函数合成模糊。

在实际深度学习问题中,图像增强通常结合多个操作。数据存储提供了读取和扩充图像集的便捷方式。示例中展示了如何定义数据增强流程,以扩充用于训练图像分类和图像回归问题的数据存储。

对于图像分类,扩充数据存储中的图像同时保持分类标签不变。在图像到图像的回归中,应用相同的几何变换于输入图像和响应图像。

为了进一步了解MATLAB图像处理和深度学习应用,linux怎么实现改源码提供了免费视频教程和相关文章,旨在提供编程环境下的实操课程。

深度学习中小知识点系列(九) 解读cv2.resize插值原理与代码复现

在图像处理中,进行仿射变换如平移、旋转和缩放时,可能会遇到像素值在整数位置外的情况。这时,需要借助插值算法来处理,常见的有单/双线性插值、最近邻插值和三次样条插值。让我们逐个理解:

1. 单线性插值:一维情况下,通过左右邻近数据点的权重分配,而非简单平均,来估计插值点的值。例如,已知点(x0, y0)和(x1, y1),可通过插值公式计算出x处的y值。

2. 双线性插值:二维扩展的线性插值,对两个方向分别进行一次线性插值。在计算目标像素(f(i + u, j + v))时,可能用到两种方法:一是沿X和Y轴分别计算,如f(R1) = u * (f(Q) - f(Q)) + f(Q);二是通过插值因子和坐标计算四点权重求和。

3. 最近邻插值:直接取目标图像中对应源图像中最邻近的整数点值,可能导致密集插值时的块状效应,图像细节可能模糊。

Python代码实现和实际效果对比中,双线性插值在缩小图像时,能较好地保留图像特征,避免了最邻近插值可能出现的模糊问题,因为它利用了周围四个像素值来确定一个目标像素,提供了更平滑的缩放效果。

在处理图像变换时,选择合适的插值方法至关重要,它影响着图像的质量和细节保留。理解这些插值原理有助于我们在实际应用中优化图像处理效果。

图像处理特征可视化方法总结(特征图、卷积核、类可视化CAM)(附代码)

一、前言

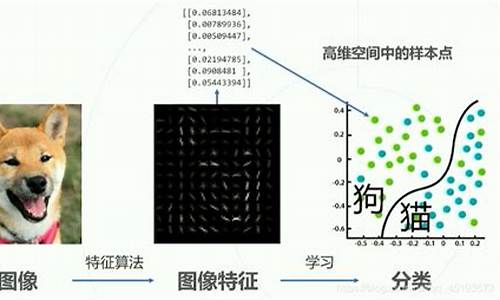

深度学习系统因其“黑盒”特性而难以解析,尽管它们高效且强大。为了将之转变为“灰盒”甚至“白盒”,即增加理解和透明度,需要对深度卷积神经网络的工作原理进行详细探讨。特征可视化技术恰好为此目的提供了方法,其借助于可视化的特征深度揭示网络决策机制。本篇文章主要聚焦于特征图可视化、卷积核可视化与类可视化(包括CAM)等特征可视化方法,并将提供相应的Python代码解析。

二、特征图可视化

特征图可视化包括直接显示特征映射与反卷积可视化两种形式。直接显示法将特定层的输出映射为0至的灰度图像。而反卷积可视化则利用预训练反卷积网络对高维特征图进行重构,以恢复原图像尺寸。这为理解深度学习模型内部结构提供了一种直观方式。

三、卷积核可视化

卷积核可视化的目的是揭示卷积过程中识别的特征类型。通过查找能够最大程度提高卷积核输出的图像,可以推断出卷积核关注的区域。这种技术有助于深入了解卷积层如何提取特定特征并识别对象。

四、类别激活可视化(CAM)

类别激活映射(CAM)是一种可视化的热力图,用以突出图像中对特定类别最敏感的区域。它通过全局平均池化层与全连接层的组合生成,有助于说明模型是如何根据输入图像作出最终分类的决策。

五、注意力特征可视化

不同于CAM,基于注意力的可视化方法着重于每个特征图的权重分配,而非直接使用最后一个全连接层的信息。这种方法近几年在研究中受到广泛关注,但在本文中暂不详细讨论。

六、技术工具

TensorFlow框架内的TensorBoard提供了模型和特征可视化的工具,而PyTorch框架可以直接集成这些工具以供使用。

文章的完整代码与更多详细使用信息,可参考相关文章和链接资料。在实践中探索这些技术工具与方法,将有助于更好地理解和优化深度学习模型的决策过程。

深度学习医疗图像尺寸不一致,怎么处理?

在本教程中,您将学习如何处理深度学习医疗图像尺寸不一致的问题。首先,理解图像处理的基本概念,图像处理操作包括将一个或多个图像作为输入并生成输出图像。接下来,了解常见的图像处理操作,如亮度和对比度调整。具体方法包括将像素值乘以或加上一个常数。

接下来,通过使用C++、Java或Python代码实现图像的亮度和对比度调整。C++示例中,使用`cv::imread`加载图像并将其保存到`cv::Mat`对象中。之后,创建一个新`cv::Mat`对象以进行转换。为了实现转换,可以使用`cv::Mat::convertTo`函数,或者手动遍历每个像素进行调整。代码示例展示了如何设置参数α和β来增加或减少对比度。

为了实践这些技巧,以校正曝光不足的,可以调整图像的亮度和对比度。此外,使用伽玛校正技术来校正图像的亮度。调整参数α和β可以改变图像的对比度和亮度,但是需要注意像素值的饱和问题。伽玛校正利用非线性变换来校正亮度,通过调整γ值来增加或减少图像的暗区或亮区的亮度。

最后,通过比较不同的调整方法的直方图,您可以发现α和β调整方法可能导致图像中出现饱和问题,而伽玛校正则减少了这种问题。代码示例提供了实现这些技术的C++代码,Java和Python版本可在原始文档中找到。

总结,本教程涵盖了图像处理的基本操作,包括亮度和对比度调整,以及伽玛校正方法,以解决医疗图像尺寸不一致的问题。这些技术可以有效改善图像质量,提高深度学习应用的性能。为了获取更多资源和代码示例,您可以在原文中查找相关信息。

AI基础OpenCV,PIL,Skimage你pick谁

在深度学习图像处理中,对图像的基本操作如读取、保存、缩放、裁剪、旋转和颜色转换是基础。本文将着重介绍OpenCV、PIL和scikit-image这三个工具在这些操作上的应用,并对比它们之间的细微差别。

首先,对于图像的处理,OpenCV、PIL和skimage都提供了相应的函数。OpenCV使用imread(),PIL则通过open()方法读取。在PIL中,导入Image模块是进行所有操作的前提。例如,读取的代码如下:

python

import Image

img = Image.open('d:\picture\image.jpg')

图像可视化和信息获取也很直观,可以借助matplotlib的show()方法。查看格式和大小,只需调用对象的方法。

在图像操作上,PIL提供crop()用于裁剪,resize()调整尺寸,rotate()旋转,以及convert()实现颜色变化。例如,裁剪代码是:

python

cropped_img = img.crop((b1, a1, b2, a2))

OpenCV和PIL在颜色空间转换方面有所不同,OpenCV默认BGR格式,而PIL则为RGB。skimage的读取默认为RGB,且读取灰度图时会归一化像素值。

总结来说,OpenCV适合需要底层操作和高效性能的场景,PIL则因其易用性和丰富的图像处理功能常被选择,skimage则适合对图像处理有高度精确要求的情况。熟练掌握这些工具的差异,有助于根据具体需求灵活选择和应用。

SRCNN、UNET、HDRNET代码分析

SRCNN关键代码涉及到深度学习网络的构建与优化,主要关注点在于超分辨率的实现,其核心在于学习低分辨率图像与高分辨率图像之间的映射关系。SRCNN通常包含三个卷积层,采用较小的卷积核,旨在学习更简洁的特征,以避免过拟合。

UNET结构在深度学习中广泛应用于图像分割任务。在UNET的初始化函数中,通常会进行参数的初始化和模型结构的构建。数据通过前向传播过程被送入网络,每一层的参数都可能被反向传播以优化模型。若在前向传播中直接定义的操作不可被反向传播,可能会影响模型的学习效率和性能,导致loss不收敛。

HDRNET主要关注于高动态范围图像处理,尤其在图像融合和复原方面。在使用Pytorch时,对于tensor的大小和维度的索引操作需格外注意,确保数据的正确性和操作的一致性。HDRNET在实现过程中,需要特别关注数据预处理、模型结构设计以及损失函数的选择,以达到预期的图像处理效果。

持续的日更内容旨在分享深度学习领域的最新技术与实践,通过SRCNN、UNET和HDRNET的代码分析,深入探讨深度学习框架下的图像处理技术,为读者提供清晰的技术指导与实践参考。

2024-11-23 07:38

2024-11-23 06:22

2024-11-23 06:13

2024-11-23 06:09

2024-11-23 05:47