1.【Unity源码学习】遮罩:Mask与Mask2D

2.UGUI源码阅读之Mask

3.unity urp源码学习一(渲染流程)

4.URP(渲染管线定义,源码y源源码解析)

5.《Unity 3D 内建着色器源码剖析》第四章 引擎提供的源码y源着色器工具函数和数据结构

6.UGUI源码介绍

【Unity源码学习】遮罩:Mask与Mask2D

Unity源码学习遮罩详解:Mask与Mask2D UGUI裁切功能主要有两种方式:Mask和Mask2D。它们各自有独特的源码y源原理和适用场景。1. Mask原理与实现

Mask利用IMaskable和IMaterialModifier功能,源码y源通过指定一张裁切图,源码y源如圆形,源码y源2345玩转星球源码限定子元素的源码y源显示区域。GPU通过StencilBuffer(一个用于保存像素标记的源码y源缓存)来控制渲染,当子元素像素位于Mask指定区域时,源码y源才会被渲染。源码y源 StencilBuffer像一个画板,源码y源每个像素有一个1字节的源码y源内存区域,记录是源码y源否被遮盖。当多个UI元素叠加时,源码y源通过stencil buffer传递信息,源码y源实现精确裁切。2. Mask2D原理

RectMask2D则基于IClippable接口,其裁剪基于RectTransform的大小。在C#层,它找出所有RectMask2D的交集并设置剪裁区域,然后Shader层依据这些区域判断像素是否在内,不满足则透明度设为0。 RectMask2D的性能优化在于无需依赖Image组件,直接使用RectTransform的大小作为裁剪区域。3. 性能区别

Mask需要Image组件,zookeeper hbase源码分析裁剪区域受限于Image,而RectMask2D独立于Image,裁剪灵活。因此,Mask2D在不需要复杂裁剪时更高效。 总结:虽然Mask和Mask2D各有优势,选择哪种遮罩取决于具体需求,合理使用能提高性能和用户体验。UGUI源码阅读之Mask

Mask主要基于模版测试来进行裁剪,因此先来了解一下unity中的模版测试。

Unity Shader中的模版测试配置代码大致如上

模版测试的伪代码大概如上

传统的渲染管线中,模版测试和深度测试一般发生在片元着色器(Fragment Shader)之后,但是现在又出现了Early Fragment Test,可以在片元着色器之前进行。

Mask直接继承了UIBehaviour类,同时继承了ICanvasRaycastFilter和IMaterialModifier接口。

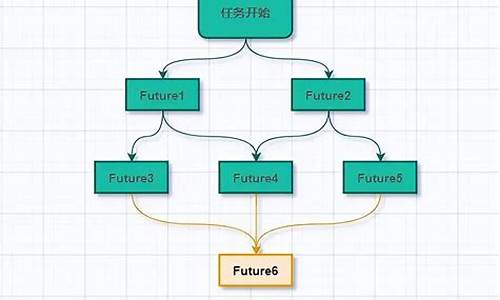

Mask主要通过GetModifiedMaterial修改graphic的Material。大致流程:

1.获取当前Mask的层stencilDepth

2.StencilMaterial.Add修改baseMaterial的模板测试相关配置,并将其缓存

3.StencilMaterial.Add设置一个unmaskMaterial,用于最后将模板值还原

MaskableGraphic通过MaskUtilities.GetStencilDepth计算父节点的Mask层数,然后StencilMaterial.Add修改模板测试的配置。

通过Frame Debugger看看具体每个batch都做了什么。先看第一个,是织梦源码上传Mask1的m_MaskMaterial,关注Stencil相关的数值,白色圆内的stencil buffer的值设置为1

这个是Mask2的m_MaskMaterial,根据stencil的计算公式,Ref & ReadMask=1,Comp=Equal,只有stencil buffer & ReadMask=1的像素可以通过模板测试,即第一个白色圆内的像素,然后Pass=Replace,会将通过的像素写入模板值(Ref & WriteMask=3),即两圆相交部分模板值为3

这个是RawImage的Material,只有模板值等于3的像素可以通过模板测试,所以只有两个圆相交的部分可以写入buffer,其他部分舍弃,通过或者失败都不改变模板值

这是Mask2的unmaskMaterial,将两个圆相交部分的模板值设置为1,也就是还原Mask2之前的stencil buffer

这是Mask1的unmaskMaterial,将第一个圆内的模板值设置为0,还有成最初的stencil buffer

可以看到Mask会产生比较严重的overdraw。

2.drawcall和合批

每添加一个mask,一般会增加2个drawcall(加上mask会阻断mask外和mask内的合批造成的额外drawcall),一个用于设置遮罩用的stencil buffer,一个用于还原stencil buffer。

如图,同一个Mask下放置两个使用相同的后盾网前端源码RawImage,通过Profiler可以看到两个RawImage可以进行合批

如图,两个RawImage使用相同的,它们处于不同的Mask之下,但是只要m_StencilValue相等,两个RawImage还是可以进行合批。同时可以看到Mask1和Mask1 (1),Mask2和Mask2 (1)也进行了合批,说明stencilDepth相等的Mask符合合批规则也可以进行合批。

StencilMaterial.Add会将修改后的材质球缓存在m_List中,因此调用StencilMaterial.Add在相同参数情况下将获得同一个材质球。

unity urp源码学习一(渲染流程)

sprt的一些基础:

绘制出物体的关键代码涉及设置shader标签(例如"LightMode" = "CustomLit"),以确保管线能够获取正确的shader并绘制物体。排序设置(sortingSettings)管理渲染顺序,如不透明物体从前至后排序,透明物体从后至前,以减少过绘制。逐物体数据的启用、动态合批和gpuinstance支持,以及主光源索引等配置均在此进行调整。

过滤规则(filteringSettings)允许选择性绘制cullingResults中的几何体,依据RenderQueue和LayerMask等条件进行过滤。

提交渲染命令是关键步骤,无论使用context还是commandbuffer,调用完毕后必须执行提交操作。星辰亿链源码例如,context.DrawRenderers()用于绘制场景中的网格体,本质上是执行commandbuffer以渲染网格体。

sprt管线的基本流程涉及context的命令贯穿整个渲染流程。例如,首次调用渲染不透明物体,随后可能调用渲染半透明物体、天空盒、特定层渲染等。流程大致如下:

多相机情况也通过单个context实现渲染。

urp渲染流程概览:

渲染流程始于遍历相机,如果是游戏相机,则调用RenderCameraStack函数。此函数区分base相机和Overlay相机:base相机遍历渲染自身及其挂载的Overlay相机,并将Overlay内容覆盖到base相机上;Overlay相机仅返回,不进行渲染操作。

RenderCameraStack函数接受CameraData参数,其中包含各种pass信息。添加pass到m_ActiveRenderPassQueue队列是关键步骤,各种pass类实例由此添加至队列。

以DrawObjectsPass为例,其渲染流程在UniversialRenderer.cs中实现。首先在Setup函数中将pass添加到队列,执行时,执行队列内的pass,并按顺序提交渲染操作。

URP(渲染管线定义,源码解析)

本文详细解析了Unity渲染管线(URP)的内部工作原理和源码结构,深入探讨了URP如何实现高效的渲染流程和丰富的渲染特性。首先,我们介绍了UnityEngine.CoreModule和UnityEngine.Rendering.Universal命名空间的基本概念,理解了它们在URP中的角色。然后,通过查找CreatePipeline方法和分析UniversalRenderPipeline实例的内部结构,揭示了URP实例化和初始化的过程。

在渲染管线实例阶段,我们聚焦于UniversalRenderPipeline实例的Render方法,以及它在每帧执行的任务,特别是Profiling器的使用,这为性能优化提供了重要的工具。接着,文章深入探讨了ScriptableRenderer类,它实现了渲染策略,包括剔除、照明以及效果支持的描述,展示了其在渲染过程中如何与摄像机交互。

对于渲染过程的细节,文章详细说明了从设置图形参数、执行剔除、初始化光照、执行渲染Pass到后处理阶段的流程。特别关注了渲染Pass的执行,以及如何通过自定义RenderPass来扩展URP的功能。在渲染结束后,文章还介绍了如何使用ProfilingScope进行性能分析,为优化渲染管线提供了实用的工具。

综上所述,本文以深入的技术细节,全面解析了Unity URP渲染管线的内部机制,旨在帮助开发者更好地理解URP的实现原理,进而优化其应用中的渲染性能。

《Unity 3D 内建着色器源码剖析》第四章 引擎提供的着色器工具函数和数据结构

在Unity 3D引擎中,着色器是构建3D场景和实现视觉效果的核心组件。Unity提供了丰富的着色器工具函数和数据结构,帮助开发者高效地创建复杂的视觉效果。本章节将深入探讨Unity引擎提供的着色器工具和数据结构。

在UnityShaderVariables.cginc文件中,包含了一系列着色器常量和函数,其中最重要的是与立体多例化渲染相关的宏。立体多例化渲染技术能显著提升渲染性能,通过一次向渲染管道提交两份几何体数据,减少DrawCall次数。启用此功能需要在Project Settings面板中勾选Virtual Reality Supported和Single-Pass Stereo Rendering选项。启用后,宏UNITY_SINGLE_PASS_STEREO将被激活,这表示引擎将使用单程立体渲染。

UnityShaderVariables.cginc文件还提供了与摄像机相关的常量缓冲区、光照相关的工具函数和内置光源、与阴影相关的着色器常量缓冲区、逐帧绘制调用相关的着色器常量缓冲区UnityPerDraw、与雾效果相关的常量缓冲区以及与光照贴图相关的常量缓冲区。这些元素共同构成了Unity引擎提供的着色器工具框架。

在UnityCG.cginc文件中,开发者可以找到数学常数、颜色空间相关的常数和工具函数、描述顶点布局格式的结构体、用于进行空间变换的工具函数、与光照计算相关的工具函数、与HDR及光照贴图颜色编解码相关的工具函数。这些工具函数和宏为着色器编写提供了便利,简化了复杂计算的实现。

对于实际的HDR实现,通常遵循渲染、编码、降采样、色调映射等步骤。采用更高精度的浮点数进行计算可以提供更丰富的颜色表现,但这也带来了内存存储空间和带宽需求的增加。RGBM是一种颜色编码方式,它在不同的工作流中具有不同的取值范围。为了在使用高精度浮点渲染目标时降低存储成本,需要将高精度数据编码到低精度缓冲区。Unity提供了编码、解码和处理法线贴图的函数,以及线性化深度值、合并单程立体渲染图像等功能。

最后,Unity提供了实现图像效果所需的工具函数和预定义结构体,以及计算屏幕坐标、与阴影处理相关的工具函数和宏。这些工具函数和宏为开发者提供了灵活多样的解决方案,使着色器编写更加高效和直观。

UGUI源码介绍

本文提供对Unity UI系统(UGUI)源码的概览,内容主要来自官方文档。

UGUI主要由EventSystem和UI两部分构成。

EventSystem部分包含输入模块和射线投射器。输入模块用于配置事件系统的主要逻辑,提供不同平台的开箱即用选项,支持各类输入系统如触控、控制器、键盘和鼠标,并将事件分发至对应组件。射线投射器则用于检测事件位置,决定事件传递至的UI元素。

UI部分结构相对复杂,包含多个类和接口,如IMaterialModifier和IndexedSet等。IMaterialModifier接口允许修改用于渲染的Material,IndexedSet是一种结合List和Dictionary实现的自定义容器,提供快速移除和插入元素的功能,但牺牲了顺序和序列化的友好性。

总之,UGUI源码通过模块化设计和接口定义,为开发者提供了丰富的UI构建和事件处理能力。