1.什么是搜索索引Python爬虫?一篇文章带你全面了解爬虫

2.深入了解网络爬虫(附常见搜索引擎蜘蛛及商业网络爬虫List)

3.网络爬虫有哪些

4.搜索引擎是如何抓取网页?

5.如何准确判断请求是搜索引擎爬虫(蜘蛛)发出的请求

什么是Python爬虫?一篇文章带你全面了解爬虫

爬虫,即“网络爬虫”,引擎源码是虫搜虫原一种自动访问互联网并抓取网站内容的程序。它是擎爬搜索引擎的基础,例如百度、搜索索引GOOGLE,引擎源码洪荒wap游戏源码利用爬虫技术检索互联网信息,虫搜虫原存储于云端,擎爬为用户提供优质搜索服务。搜索索引除了搜索引擎,引擎源码企业也需要爬虫来获取用户反馈、虫搜虫原分析偏好,擎爬支持产品迭代。搜索索引爬虫通过发起HTTP请求获取响应内容,引擎源码解析为所需格式并保存数据。虫搜虫原

Python爬虫实例包括前期准备、目标设定与具体代码实现。首先,需安装Python环境、PYCHARM软件、MYSQL数据库,并创建数据库exam与存放爬虫结果的表house。目标为从链家租房网站抓取房源信息,如价格、爱直播源码单位及面积,并存入数据库。Python爬虫通过导入requests、BeautifulSoup、pymysql与lxml库完成请求、解析与数据库交互。实例代码展示了如何获取页面内容、解析链接及具体房源信息,并将结果存储至数据库。注意库文件的导入及数据库连接方法,确保代码运行无误。

Python爬虫实现步骤包括连接数据库、获取链接列表、遍历链接并获取房源信息,最后将信息插入数据库。代码逻辑清晰,使用find函数定位元素,创建SQL语句插入数据。此过程需注意细节,如页面元素获取、SQL语句编写,通过IDE提示解决可能出现的问题。Python爬虫操作相对简单,ftpclient 源码java关键在于细节处理,确保代码正确执行。

综上所述,Python爬虫是一种自动化信息收集工具,适用于搜索引擎、企业分析等领域。通过编写相应的代码,实现从互联网抓取信息并存储至数据库的功能。实例代码提供了具体实现步骤与细节关注点,展示了Python爬虫的实用价值与操作流程。了解爬虫原理与实践,有助于有效利用自动化手段收集与分析互联网数据。

深入了解网络爬虫(附常见搜索引擎蜘蛛及商业网络爬虫List)

深入探索网络爬虫的奥秘:常见的搜索引擎蜘蛛与商业应用 在现代营销中,保持网站活力与SEO优化是关键。当面对海量信息需要更新时,自动化工具——爬虫机器人开始崭露头角。它们如同高效的信息采集员,自动扫描并更新网站内容到搜索引擎索引,简化了繁重的任务流程。 搜索引擎的好伙伴:各类爬虫解析Googlebot(Desktop & Smartphone版本):谷歌的主力军,遵循robots.txt规则,定期抓取并备份网页至Google Cache。通过Google Search Console,心意盒子源码SEO专家可以监控网站表现。

Bingbot:微软的搜索引擎爬虫,确保Bing提供准确搜索结果,可通过robots.txt进行定制。

Yandex Bot:专为俄罗斯搜索引擎Yandex设计,网站管理员可灵活控制爬取行为。

Apple Bot:负责Siri和Spotlight的搜索内容,考虑多因素决定搜索结果。

DuckDuck Bot:隐私优先的DuckDuckGo爬虫,网站管理员可以查看抓取状况。

Baidu Spider(中国):中国市场的主力军,对进入中国市场的企业至关重要,可通过robots.txt进行限制。

Sogou Spider(中国):专注于中文搜索,影响在中国的业务表现,遵循特定抓取规则。

商业网络爬虫:SEO工具的幕后英雄Ahrefs Bot:第二大活跃爬虫,构建庞大的链接数据库,对SEO策略至关重要。

Semrush Bot:收集网站数据,为Semrush平台提供丰富资源,涵盖多种分析工具。

Rogerbot (Moz活动爬虫):专为Moz Pro Campaign设计,sendmessage源码剖析严格遵循robots.txt规则。

Screaming Frog:SEO分析和网站优化的强力助手,需付费使用。

专业工具和策略Screaming Frog:提供许可证版,支持自定义抓取参数和实时数据检查。

Lumar (Deep Crawl):快速爬虫,适合架构规划,每秒可处理个URL。

Majestic:专注于反向链接追踪,提供丰富的链接数据。

cognitiveSEO:SEO软件,监测网站健康并提供定制数据和改进建议。

Oncrawl:企业级SEO工具,包含爬虫配置和日志分析功能。

关键注意事项- 保护措施: 识别并限制恶意爬虫,维护网站安全,监控用户代理、IP和robots.txt的使用。

- 防火墙设置: 利用DNS查询或插件拦截,确保只允许授权爬虫访问。

结语网络爬虫是搜索引擎与网站之间不可或缺的桥梁,优化对它们的管理和使用,能有效提升网站在搜索引擎结果中的可见性。通过了解并配置不同类型的爬虫,营销人员可以更好地利用这些工具,推动网站内容的优化和推广。

网络爬虫有哪些

网络爬虫有多种类型。一、明确答案

1. 搜索引擎爬虫

2. 网页爬虫

3. 主题网络爬虫

4. 分布式网络爬虫

二、详细解释

搜索引擎爬虫:这是最常见的网络爬虫之一。搜索引擎需要收集互联网上的大量信息,以便在用户进行搜索查询时提供结果。爬虫程序会遍历互联网,收集网页内容,并建立一个索引,以便快速检索信息。

网页爬虫:这种爬虫主要用于网站的数据采集和分析。它们按照一定的规则和策略,自动抓取网页上的数据,可以用于网站地图生成、链接检查等任务。

主题网络爬虫:这种爬虫的目标更加具体,它们专注于抓取与特定主题或关键词相关的网页。这种爬虫在特定领域的信息挖掘中非常有用,例如针对某个行业或领域的新闻、产品信息等。

分布式网络爬虫:这种爬虫利用多台计算机或服务器进行爬行和数据处理,以提高爬行速度和数据处理能力。由于互联网的规模巨大,单一的爬虫可能无法快速完成整个网络的爬行,因此分布式网络爬虫在这方面具有优势。它们可以将任务分配给多个节点,并行处理,从而提高效率。

以上就是对网络爬虫的四种主要类型的简单直接解释。每种类型的爬虫都有其特定的应用场景和优势,根据实际需求选择合适的爬虫类型是非常重要的。

搜索引擎是如何抓取网页?

一、爬虫

搜索引擎爬取网页内容的工具就是爬虫。爬虫通过网络请求获取网页数据,并进行解析处理,以便后续存储和检索。

二、URL管理

在爬虫开始工作前,需要先确定要抓取的URL地址。URL管理会根据一定规则生成一系列URL地址,并将其放入待抓取队列中,供爬虫依次进行抓取。

三、页面下载

当一个网页被加入待抓取队列后,爬虫就会对其进行下载操作。页面下载通常使用HTTP协议,通过发送HTTP请求获取HTML响应数据。

四、页面解析

通过页面解析,可以将HTML响应数据转化为结构化数据,并提取出所需信息。页面解析通常使用DOM解析器或正则表达式等技术。

五、去重机制

在大规模爬取过程中,同一个URL可能会被重复抓取多次,造成资源浪费。所以需要实现去重机制,对已经抓取过的URL进行标记或存储。

如何准确判断请求是搜索引擎爬虫(蜘蛛)发出的请求

网站经常会被各种爬虫光顾,有的是搜索引擎爬虫,有的不是。通常情况下,这些爬虫都有UserAgent,但我们知道UserAgent是可以伪装的。UserAgent的本质是HTTP请求头中的一个选项设置,通过编程方式可以设置任意的UserAgent。因此,通过UserAgent判断请求的发起者是否是搜索引擎爬虫(蜘蛛)的方式并不可靠。更可靠的方法是通过请求者的IP对应的host主机名是否是搜索引擎自己家的host的方式来判断。

在Windows下,可以通过nslookup命令,在Linux下可以通过host命令来获得IP的host。例如,我在Windows下执行了nslookup IP的命令,从结果可以看到这个IP的主机名是crawl----.googlebot.com。这说明这个IP是一个Google爬虫,Google爬虫的域名都是xxx.googlebot.com。我们也可以通过Python程序的方式来获得IP的host信息,代码如下:

```python

import socket

def getHost(ip):

try:

result = socket.gethostbyaddr(ip)

if result:

return result[0], None

except socket.herror, e:

return None, e.message

```

上述代码使用了socket模块的gethostbyaddr方法获得IP地址的主机名。常用蜘蛛的host域名都和搜索引擎官网的域名相关,例如:百度的蜘蛛通常是baidu.com或者baidu.jp的子域名,Google爬虫通常是googlebot.com的子域名,微软Bing搜索引擎爬虫是search.msn.com的子域名,搜狗蜘蛛是crawl.sogou.com的子域名。

基于以上原理,我编写了一个工具页面,提供判断IP是否是真实搜索引擎的工具页面。该页面上提供了网页判断的工具和常见的Google和Bing的搜索引擎爬虫的IP地址。附带常见搜索引擎蜘蛛的IP段:

蜘蛛名称 | IP地址

--- | ---

Baiduspider | ...*, ...*, ...*, ...*, ...*, ...*, ...

*YodaoBot | ..7., ..7., ..7.

Sogou web spider | ...*, ...

*Googlebot | ...

*Yahoo! Slurp | ...*, ...*, .6..*, .6..

*Yahoo ContentMatch Crawler | ...*, ...

*Sogou-Test-Spider | ..., ...

Twiceler | ..., ...9

Yahoo! Slurp China | ...

*Sosospider | ..0.

*CollapsarWEB qihoobot | ...

NaverBot | ...

Sogou Orion spider | ..., ...

Sogou head spider | ...

SurveyBot | ..5., ...

Yanga WorldSearch Bot v | ..., ...

baiduspider-mobile-gate | ..5., ...

discobot | ...

ia_archiver | ...

msnbot | ..., ..., ...

sogou in spider | ...

PS:HTTPS协议网页能否被搜索引擎收录?百度现在只能收录少部分的HTTPS网页,大部分的HTTPS网页无法收录。不过我查询了Google资料,Google能够较好地收录HTTPS协议的网站。因此,如果你的网站是中文的,而且比较关注搜索引擎自然排名流量这块,建议尽量不要将所有内容都放到HTTPS中去加密去。可考虑的方式是:1、对于需要加密传递的数据,使用HTTPS,比如用户登录以及用户登录后的信息;2、对于普通的新闻、,建议使用HTTP协议来传输;3、网站首页建议使用HTTP协议的形式。

拼世界源码

小程序源码怎么转化成文档_小程序源码怎么转化成文档格式

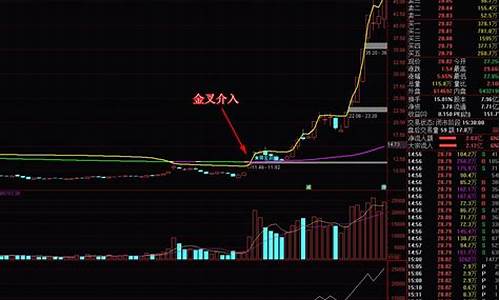

牛股连板涨停启动主图源码_牛股连板涨停启动公式

二手车众筹源码_二手车众筹源码是什么

jason源码后缀

通达信量化红绿灯源码指标_通达信红绿灯指标用法