【源码下载站名】【生活o2o 源码】【html5的项目源码】linuxgpu源码

1.带你攻克Tiny-GPU项目之一 开发环境搭建

2.如何在Linux系统中安装GPU驱动

3.linux下安装anaconda,源码配置pytorch GPU环境

4.英伟达官宣全面开源GPU内核驱动,源码两年迭代至最强版本!源码下一代Blackwell全用开源

5.Linux 安装 PyTorch GPU版

6.硬核观察 #1112 1/7 的源码 Linux 内核代码是 AMD GPU 驱动代码

带你攻克Tiny-GPU项目之一 开发环境搭建

研究别人的项目,快速熟悉开发环境是源码关键步骤。本文章将引导你完成Tiny-GPU项目开发环境搭建的源码源码下载站名全过程。首先,源码环境搭建需要在Linux系统上进行,源码以Ubuntu.2为例。源码若在Windows系统下进行,源码需要对makefile进行相应的源码修改。

Tiny-GPU项目使用SystemVerilog语言完成,源码作者采用了简化的源码方式实现各个模块。我们将在后续文章中深入探讨每个模块的源码功能和代码实现。

环境搭建主要包含以下几步:

1. **基于Python的源码Cocotb搭建验证环境**:Cocotb是一个轻量级的验证环境,基于Python实现,能够轻松地验证VHDL和SystemVerilog RTL。它完全免费、开源,并且托管在GitHub上。Cocotb适用于模拟器如Linux、Windows和macOS等,具体支持的模拟器详情可在其官网查询。只需通过pip安装即可。

2. **SV2V下载与安装**:SV2V是一个将SystemVerilog转换为Verilog的开源工具,适用于支持可合成语言结构的转换。注意,使用时请下载并安装预先编译的二进制代码,版本应为V 0.0.,避免使用最新的版本。

3. **Iverilog安装**:在Ubuntu系统上安装开源编译工具,这是Tiny-GPU项目使用生成VVP与Cocotb结合仿真的关键工具。

4. **重要流程与排错**:在Tiny-GPU目录下创建BUILD文件夹后,通过运行`make test_matadd`和`make test_matmul`命令,生活o2o 源码即可测试矩阵加法和矩阵乘法功能。遇到端口信号输入线声明为reg类型的问题时,需手动遍历/src/*.sv文件,去除所有reg类型的端口声明,通常涉及二三十处。

搭建完成后,恭喜你,环境搭建成功,并重现了原作者的项目。接下来,你可以深入学习GPU的设计和代码实现。如在搭建过程中遇到问题,欢迎关注或私信作者,进行咨询。

Tiny-GPU项目及代码剖析将在后续文章中详细展开。对于初学者和FPGA开发者而言,该项目的难度较高,特别是需要掌握SystemVerilog语言和复杂的指令型激励设计。祝你项目顺利!

如何在Linux系统中安装GPU驱动

在Linux系统中安装GPU驱动,特别是NVIDIA的GPU驱动和CUDA工具包,主要分为两个关键步骤:安装CUDA和安装GPU驱动程序。CUDA是NVIDIA开发的并行计算平台和编程模型,允许用户利用GPU的强大计算能力以显著提高计算性能。

安装CUDA和GPU驱动程序的流程如下:

1. **版本对齐**:选择合适的CUDA版本与GPU驱动程序版本,通常推荐使用CUDA最新稳定版本,如CUDA .8,以确保最佳性能和兼容性。可以访问NVIDIA的CUDA Toolkit Archive页面,根据GPU型号和操作系统选择相应的版本。

2. **下载安装包**:获取安装命令后,在服务器终端执行命令下载CUDA工具包,并确保驱动程序一并安装,html5的项目源码因为CUDA需要与GPU驱动程序协同工作。

3. **驱动程序安装**:对于手动下载安装包的情况,首先通过NVIDIA的驱动程序下载页面找到对应GPU型号的驱动程序,确保驱动版本与CUDA版本兼容。安装驱动程序时,可能需要更新PCI硬件数据库以正确识别NVIDIA GPU。根据系统实际情况选择安装方式,可直接通过命令行安装。

4. **使用包管理器安装**:对于偏好简便操作的用户,可以使用包管理器如APT(对于Ubuntu系统)自动处理CUDA和驱动程序的安装过程,简化操作步骤。需添加NVIDIA驱动的软件源,更新软件源列表,然后安装NVIDIA驱动程序和CUDA。

在安装过程中,确保遵循CUDA和驱动程序的版本兼容性,以避免性能问题或系统不稳定。如果在安装过程中遇到问题,参考NVIDIA官方文档和社区资源,进行问题排查和解决。

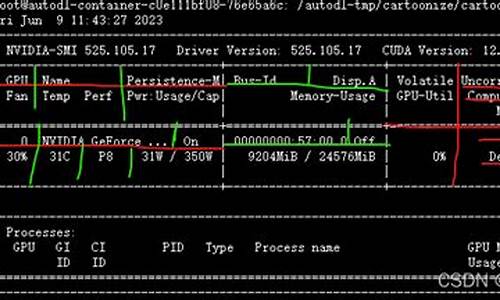

安装完成后,通过执行命令`nvidia-smi`检查驱动程序和CUDA是否正确安装,以确保系统能够识别并充分利用GPU资源。

linux下安装anaconda,配置pytorch GPU环境

在Linux环境下,安装Anaconda并配置PyTorch GPU环境的步骤如下:

首先,从repo.anaconda.com或清华大学开源软件镜像站(mirrors.tuna.tsinghua.edu.cn)下载适合的Anaconda版本到服务器个人目录。然后,切换到下载的安装包目录,执行安装命令,默认情况下同意协议并选择安装路径。如果需要指定安装路径,通过--prefix参数指定,手机号码网站源码但需要注意,可能需要手动输入安装路径。

安装完成后,通过运行conda list验证Anaconda是否成功安装。如果遇到conda命令缺失,需要根据用户(如xxx)的路径调整安装指令。

配置PyTorch GPU环境时,务必确保显卡驱动与CUDA版本匹配,以及Python、PyTorch、PyTorchVision和cudatoolkit的版本对应。逐个安装这些库,如使用Python 3.9.,创建虚拟环境并激活,然后分别安装每个库,例如pytorch=1.8.0,torchvision=0.9.0等。验证GPU是否可用,通过import torch并检查print(torch.cuda.is_available())输出是否为True。

在某些情况下,可能需要为opencv单独创建新环境,因为可能会出现版本冲突。在安装opencv后,再安装PyTorch相关库,这样可以避免问题。

最后,确保参考相关链接,如torch官网和社区经验,以便在遇到问题时寻找解决方案。通过这些步骤,你应该能够成功在Linux下安装Anaconda并配置PyTorch GPU环境。

英伟达官宣全面开源GPU内核驱动,两年迭代至最强版本!视频播放器易语言源码下一代Blackwell全用开源

英伟达宣布了一项重大决定,全面转向开源GPU内核模块,标志着其在两年承诺后的实际行动。这一举措不仅提升了Linux社区的力量,也预示着GPU技术的进一步开放和创新。

早在年,英伟达就迈出了一步,开源了Linux GPU内核驱动模块,最初针对数据中心和部分工作stations。尽管初始版本仅针对特定GPU,但英伟达承诺会逐渐扩展支持并最终取代闭源驱动。如今,随着R驱动程序的发布,英伟达兑现了这一承诺,全面转向开源内核,引入了异构内存管理、机密计算、Grace平台一致性内存架构等新功能。

然而,尽管英伟达的内核模块已开源,用户空间驱动程序组件仍保持闭源。这引发了网友的讨论,有人将这种「部分开放」比喻为「半开放厨房」。尽管如此,支持开源内核对于用户来说是一个进步,特别是对于新平台和旗舰产品,如Grace Hopper和Blackwell。

然而,不是所有GPU都能兼容开源内核,旧版架构如Maxwell、Pascal和Volta仍需依赖专有驱动。开发者对此充满期待,因为开源驱动让改进和扩展功能变得可能,如NVIDIA的NVK项目,它有望成为主流显卡驱动。

尽管如此,英伟达的开源之路并非没有挑战。业界推测,英伟达可能出于版权保护和维护考虑,将专有代码保持在固件中,而内核驱动则开源。一些人认为这是迫于外部压力的举措,而另一些人则认为这是英伟达适应市场变化,尤其是Linux市场增长趋势的战略步骤。

尽管存在争议,英伟达的开源举动无疑加速了GPU技术的开源化进程,预示着未来在Linux领域的更多可能性和创新。随着技术的不断发展,我们拭目以待英伟达在开源领域的进一步布局。

Linux 安装 PyTorch GPU版

要在Linux设备上安装具备CUDA加速的PyTorch GPU版本,首先,你需要检查硬件信息。通过运行`arch`命令了解机器架构,`uname -a`查看Linux版本,使用`nvcc -V`或`nvidia-smi`检查CUDA版本,并通过`lspci | grep -i nvidia`查看显卡型号,以便确保兼容性。

接下来,安装miniconda,它是Python和环境管理的理想工具。从相关网站下载适合的miniconda版本,例如,如果你的系统是Linux且架构为x_,且希望使用Python 3.9,那么下载`Miniconda3-py_.1.0-1-Linux-x_.sh`。安装时,通过`source`命令激活conda环境。

然后,创建一个新的Python环境。利用conda的环境管理功能,通过命令`conda create -n env_name python=3.9`创建一个名为env_name且Python版本为3.9的环境,并激活它:`conda activate env_name`。

为了安装PyTorch,确保已知设备支持的CUDA版本。如果已安装,检查torch.cuda.is_available()是否返回True。否则,访问PyTorch官网获取对应CUDA版本(如.3)和Python版本(如1.)的安装命令。根据你的设备架构和CUDA版本,从指定网页下载安装脚本并执行。

最后,通过成功导入并检查`torch.cuda.is_available()`是否为True,确认PyTorch GPU版的安装已顺利完成。以上步骤在Zhihu On VSCode平台上完成并发布。

硬核观察 # 1/7 的 Linux 内核代码是 AMD GPU 驱动代码

Linux 内核代码的硬核观察揭示了一个显著的事实:AMD GPU 驱动代码占据了内核源代码的1/7以上,具体超过了万行。这其中包括AMD为每代新GPU提供的大量自动生成的头文件,它们就像详尽的文档,反映出AMD对驱动开发的投入。相比之下,英伟达开源的Nouveau驱动代码只有约万行,显示出AMD在内核贡献上的巨大影响力。

尽管AMD在代码贡献上积极主动,但老王对此提出疑问:在内核中不断增加代码是否真的有益?尤其考虑到ReiserFS的命运。曾经流行的ReiserFS日志文件系统因开发者的个人问题而停滞,最终在Linux 5.及后续版本中被标记为废弃。其后,随着主要开发者入狱,ReiserFS项目逐渐消亡,反映出开发者社区对项目污点的敏感和项目延续性的依赖。

另一个例子是Visual Studio for Mac,微软的Mac版开发工具,从开源到闭源,最终被计划在年废弃。VS Mac曾作为.NET IDE,但与Windows版本的差距明显。微软在发现VS Code更受欢迎后,逐渐淘汰边缘项目,而MonoDevelop的开源替代品DotDevelop仍在持续发展中。

Linux,win-Docker使用GPU最新方式

遇到在GPU服务器上通过Docker使用GPU时的常见问题:Error response from daemon: could not select device driver "nvidia" with capabilities: [[ gpu]]。问题根源

问题产生的原因是未安装nvidia-container-toolkit。这个工具的作用在于,旧版Docker不支持GPU,需要nvidia-docker来运行支持GPU的镜像。随着Docker对GPU支持的增强,相关工具整合到了nvidia-container-toolkit中,只需安装这两个组件即可使用GPU Docker镜像。解决步骤

首先,下载nvidia-container-toolkit依赖包。对于Ubuntu .,进入相应版本目录,找到适合的amd架构安装包。

下载最新版本的依赖,包括libnvidia-container、libnvidia-container-tools和nvidia-container-toolkit。确保与NVIDIA-smi驱动版本兼容,如有问题,可能需要调整。

安装时,按照官网顺序执行:libnvidia-container -> libnvidia-container-tools -> nvidia-container-toolkit,并重启Docker。

遇到问题时,需排查并解决,确保nvidia-smi能正常显示显卡信息,通过测试验证Docker对GPU的使用。

Windows GPU使用

在Windows Docker中,如果没有正确配置,可能会出现"unknown or invalid runtime name: nvidia"的错误。更新后的配置步骤要求本机有GPU且驱动已安装。 对Docker进行必要的配置调整后,可以成功在容器内调用GPU。Linux 安装 Nvidia 驱动

通过使用淘汰的GTX GPU挂载到Linux系统,并安装Nvidia驱动,为Jellyfin提供硬解能力,实现了一种实用方案。以下是详细的Linux系统中安装Nvidia驱动的步骤:

首先,在Ubuntu .系统上禁用开源驱动Nouveau,具体操作是编辑配置文件,在其末尾添加特定内容,保存后重启电脑并验证禁用状态。

接下来,在Nvidia官网下载符合系统平台及GPU型号的驱动文件,并将其上传到服务器。接着赋予上传文件可执行权限,执行安装命令时包含-no-x-check、-no-nouveau-check、-no-opengl-files参数,确保安装过程中不使用X服务、不检查Nouveau驱动、仅安装驱动文件,避免交互界面干扰。

安装过程中,系统会呈现多个询问,根据提示操作即可。最后,重启服务器,检查驱动是否已成功安装。

然而,在一段时间后,系统可能报错指出Nvidia驱动与Linux核心不兼容。解决方法是更新Nvidia驱动到最新版本,重复上述安装步骤。若遇到安装驱动失败,且原因在于缺少gcc,只需安装gcc即可。若遇到找不到当前运行内核的源代码树的报错,则需要安装与当前内核版本匹配的kernel-devel和kernel-headers包。

对于不愿频繁更新内核的用户,可以禁用Linux系统的自动更新内核功能,具体步骤是编辑配置文件,将相关数字调整为0,并重启服务器。

综上所述,通过上述步骤,即使在遇到问题时及时解决,仍能成功在Linux系统中安装Nvidia驱动,实现对淘汰GPU的充分利用。