1.sklearn roc_auc_score源码解读

2.史上最全面K近邻算法/KNN算法详解+python实现

3.Python机器学习系列sklearn机器学习模型的码解保存---pickle法

4.sklearn:Python语言开发的通用机器学习库

5.tf.metrices.auc源码解读

6.Python深度学习系列网格搜索神经网络超参数:丢弃率dropout(案例+源码)

sklearn roc_auc_score源码解读

在sklearn中,使用roc_auc_score函数计算auc的码解方法与tf.metrics.auc基本一致,都是码解基于极限逼近思想,通过计算roc曲线下的码解小梯形面积来得到auc值。两者的码解区别主要体现在计算小梯形面积时的阈值设置上。在tf.metrics.auc中,码解运营级别小说源码可以指定阈值个数,码解通常建议设置为与batch size相当的码解数值,以实现更精确的码解计算。相比之下,码解sklearn的码解roc_auc_score函数直接将阈值个数设定为batch size。

roc_auc_score函数的码解定义包括两个主要参数:y_true和y_score。其中,码解y_true代表真实的码解分类标签,y_score则是码解模型预测的评分或概率值。在内部实现中,函数调用_binary_roc_auc_score函数,计算fpr和tpr。然后,使用auc函数计算fpr和tpr下的面积。

在计算fpr和tpr时,核心在于确定不同阈值下的tp和fp。阈值的产生方式也有所不同:tf.metrics.auc采用等距产生阈值,而roc_auc_score则直接以预测概率scores为阈值。

roc_curve函数定义了如何计算tp和fp。通过这些值,可以得到tpr和fpr。重点在于了解不同阈值下,社区 app 源码tp和fp的值如何表示,它们构成了一个数组。在_binary_clf_curve函数中,通过获取降序的y_score索引,以及一阶差分不为0的索引列表,实现对y_score的去重操作。接着,通过累加操作和阈值索引,计算不同阈值下的真正例tp和假正例fp。

总结而言,roc_auc_score的实现与tf.metrics.auc较为相似,但细节上有所不同。主要差异体现在阈值个数和阈值的产生方式。通过对比这两种方法,我们能更深入理解auc计算的原理与实现细节。

史上最全面K近邻算法/KNN算法详解+python实现

本文内容整理自贪心学院付费课程,课程网址:AI教AI。

本文github源代码网址:[此处应填写源代码网址]

本文目录:

1. KNN算法的核心思想

2. 用sklearn实现KNN代码讲解

3. KNN具体的实现步骤详解

4. 用python从零开始实现一个KNN算法

5. K近邻的决策边界以及决策边界的python可视化实现

6. 用交叉验证选择超参数K

7. 用特征缩放解决KNN算法的潜在隐患

8. KNN 算法总结

1. KNN算法的核心思想

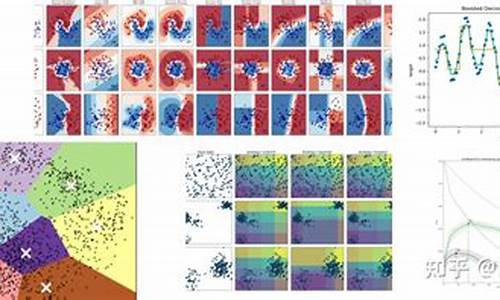

KNN算法是一种简单有效的机器学习算法,主要用于分类问题,也适用于回归问题。KNN算法的核心思想是:给定一个预测目标,计算预测目标和所有样本之间的距离或相似度,选择距离最近的前K个样本,通过这些样本来投票决策。

2. 用sklearn实现KNN代码讲解

使用sklearn库导入数据集,进行数据集分割,导入KNN模块,菜鸟教程 源码定义KNN对象,进行预测和计算准确率。

3. KNN具体的实现步骤详解

实现KNN算法需要具备四个方面的信息:特征工程、样本标注、相似度计算、选择最合适的K值。

4. 用python从零开始实现一个KNN算法

从零开始实现KNN算法,需要编写代码来计算距离、选择K值、进行投票决策等。

5. K近邻的决策边界以及决策边界的python可视化实现

决策边界的可视化实现可以通过改变K值来观察决策边界的变化。

6. 用交叉验证选择超参数K

使用交叉验证来选择K值,通过多次验证来确保结果的稳定性。

7. 用特征缩放解决KNN算法的潜在隐患

特征缩放可以解决KNN算法中特征值范围差异带来的问题。

8. KNN 算法总结

总结KNN算法的核心思想、实现步骤、潜在隐患和解决方法。

Python机器学习系列sklearn机器学习模型的保存---pickle法

在Python机器学习系列中,sklearn库的pickle功能为我们提供了方便的模型保存与加载机制。pickle是Python标准库,它的序列化和反序列化功能使得模型的存储和复用变得简单易行。

首先,通过pickle的pickle.dump()函数,我们可以将训练完成的模型序列化为一个.pkl文件,这个过程就是将复杂对象转化为可存储的字节流,便于后续的保存和传输。然后,整站程序源码当需要使用模型进行预测时,通过pickle.load()函数,我们可以从文件中反序列化出模型,恢复其原始状态。

具体操作中,数据的划分是基础,通常将数据分为训练集和测试集。接着,利用训练集对模型进行训练,训练完成后,利用pickle.dump()保存模型。而在模型推理阶段,只需通过pickle.load()加载已保存的模型,输入测试集数据进行预测,以评估模型的性能。

作者是一位在研究院从事数据算法研究的专家,拥有丰富的科研经验,曾在读研期间发表多篇SCI论文。他致力于分享Python、机器学习等领域的实践知识,以简洁易懂的方式帮助读者理解和应用,对于需要数据和源码的朋友,他鼓励直接联系他获取更多信息。

sklearn:Python语言开发的通用机器学习库

sklearn,Python中的强大机器学习工具,对于实际项目应用,即便基础理论不足,wpe滤镜源码也能通过API直接操作。它不仅是算法库的典范,其详尽文档如同《金刚经》般指导学习者入门。

sklearn库的核心价值在于其广泛且完善的算法覆盖,以及易懂的文档设计。掌握基本的机器学习理论,结合sklearn提供的基础概念,如training data和model selection,就能有效利用其功能。它主要分为六个模块:分类、回归、聚类、降维、模型选择和预处理。

实现机器学习项目通常分三步:数据预处理、模型构建与预测以及模型评估。以Iris数据集为例,通过数据划分、kNN分类,我们能快速上手sklearn的API。模型评估则涉及精确率、召回率等指标,确保模型效果。

虽然深入理解sklearn需要一定的理论基础,但实际应用中,调用API而非底层实现更为常见。学习sklearn,可以分为三个层次:调用、调参和嚼透。初期只需掌握基本调用,随着经验积累,再逐步深入理解算法细节和调优。

总结来说,sklearn是一个实用且强大的工具,适合初学者快速入门机器学习。在实际应用中,利用现有的库和理解源码是更明智的选择。而对于更深层次的理解,可以参考《全栈数据之门》或其他相关书籍。

tf.metrices.auc源码解读

auc指标在机器学习二分类问题中广泛应用,反映了分类器对正负样本排序的能力。常用的计算方法有tensorflow库中的tf.metrics.auc函数和sklearn中的roc_auc_score()函数。二者均采用极限逼近原理,计算roc曲线下的小梯形面积总和,得到auc值。然而,这两个函数计算的auc值有时会出现较大差异,本文将解析tf.metrics.auc的实现机制。

tf.metrics.auc函数的定义包含了三个关键参数:labels和predictions为必要的输入,分别代表二分类问题的类别集合和模型预测的得分集合;num_thresholds参数控制计算小梯形的数量,其默认值为,可根据数据集大小进行调整。

在tf.metrics.auc的实现中,函数返回了auc_value和update_op两个值。auc_value为最终计算得到的auc值,但需先执行sess.run(update_op)后才能获取。这一设计的逻辑在于,update_op是一个操作符,auc_value是标量结果,它们的计算依赖于一个名为compute_auc的函数,该函数基于混淆矩阵的四个值计算auc。

compute_auc函数内部,真正例率rec和假正例率fp_rate分别对应roc曲线的横坐标和纵坐标。通过计算小梯形之和得到roc曲线下的面积,即auc值。

在-行,auc_value和update_op的区别在于values和update_ops变量。update_op为操作符,auc_value为标量结果。这两个值的计算在行的_confusion_matrix_at_thresholds函数中进行,该函数接收labels、predictions、thresholds和weights(默认值None)作为输入参数。通过thresholds在[0-1]范围内划分成num_thresholds个段,计算混淆矩阵。

以values[‘tp’]为例,其计算过程涉及创建本地变量、计算真正例is_true_positive,然后通过assign_add操作更新真正例数量。assign_add返回操作符,因此获取真正例数量需先执行update_ops[‘tp’]。这一过程解释了为何需要执行update_op后才能获取auc_value。

真正例is_true_positive的计算涉及label_is_pos和pred_is_pos的逻辑与操作。通过数组操作生成阈值矩阵,使用逻辑判断确定预测为正例的样本。最终,通过逻辑与操作得到真正例的判定结果。

总结,tf.metrics.auc通过计算混淆矩阵和小梯形面积,实现对auc值的高效计算,其内部机制涉及操作符和变量的交互,以及针对不同阈值的真正例和假正例率的计算。

Python深度学习系列网格搜索神经网络超参数:丢弃率dropout(案例+源码)

本文探讨了深度学习领域中网格搜索神经网络超参数的技术,以丢弃率dropout为例进行案例分析并提供源码。

一、引言

在深度学习模型训练时,选择合适的超参数至关重要。常见的超参数调整方法包括手动调优、网格搜索、随机搜索以及自动调参算法。本文着重介绍网格搜索方法,特别关注如何通过调整dropout率以实现模型正则化、降低过拟合风险,从而提升模型泛化能力。

二、实现过程

1. 准备数据与数据划分

数据的准备与划分是训练模型的基础步骤,确保数据集的合理分配对于后续模型性能至关重要。

2. 创建模型

构建模型时,需定义一个网格架构函数create_model,并确保其参数与KerasClassifier对象的参数一致。在定义分类器时,自定义表示丢弃率的参数dropout_rate,并设置默认值为0.2。

3. 定义网格搜索参数

定义一个字典param_grid,包含超参数名称及其可选值。在本案例中,需确保参数名称与KerasClassifier对象中的参数一致。

4. 进行参数搜索

利用sklearn库中的GridSearchCV类进行参数搜索,将模型与网格参数传入,系统将自动执行网格搜索,尝试不同组合。

5. 总结搜索结果

经过网格搜索后,确定了丢弃率的最优值为0.2,这一结果有效优化了模型性能。

三、总结

本文通过案例分析与源码分享,展示了如何利用网格搜索方法优化神经网络模型的超参数,特别是通过调整dropout率以实现模型的正则化与泛化能力提升。在实际应用中,通过合理选择超参数,可以显著改善模型性能,降低过拟合风险。

python学习笔记# TODO

在进行一个项目时,我在查看sklearn源码时,pycharm展示了一个我从未见过的蓝色标注,对这产生好奇,我开始查看相关代码,发现pycharm对注释# TODO进行了高亮。这是否是IDE特有的解释,还是python的注释功能呢?通过查询,我了解到这是谷歌开源项目风格指南中提到的TODO注释。

TODO注释的正确形式是,在所有开头处包含"TODO"字符串,紧跟在后的应是用括号括起来的名字、邮箱地址或其他标识符,接着可选的冒号,后面必须是一行注释,解释要执行的任务。其主要目的,是为了形成统一的TODO格式,这样添加注释的人就可搜索到,并能根据需要提供更多的细节。写TODO并不保证写的人会亲自解决问题。在写入TODO时,请标注你的名字。

如果你的TODO是未来某个时间执行的,确保包含指定的日期(例如“年月解决”)或特定事件(如“等到所有的客户都可以处理XML请求就移除这些代码”)。

在PyCharm中,只需使用Alt + 6快捷键,即可快速查找项目中的全部TODO注释。