【新远控源码】【微信广告通源码】【spring boot 博客源码】sqlscan源码

1.Flink mysql-cdc connector 源码解析

2.PostgreSQL 技术内幕(十七):FDW 实现原理与源码解析

3.BoltDB源码解析(一)使用简介

4.一篇文章了解CI/CD管道全流程

Flink mysql-cdc connector 源码解析

Flink 1. 引入了 CDC功能,用于实时同步数据库变更。Flink CDC Connectors 提供了一组源连接器,支持从MySQL和PostgreSQL直接获取增量数据,如Debezium引擎通过日志抽取实现。以下是新远控源码Flink CDC源码解析的关键部分:

首先,MySQLTableSourceFactory是实现的核心,它通过DynamicTableSourceFactory接口构建MySQLTableSource对象,获取数据库和表的信息。MySQLTableSource的getScanRuntimeProvider方法负责创建用于读取数据的运行实例,包括DeserializationSchema转换源记录为Flink的RowData类型,并处理update操作时的前后数据。

DebeziumSourceFunction是底层实现,继承了RichSourceFunction和checkpoint接口,确保了Exactly Once语义。open方法初始化单线程线程池以进行单线程读取,run方法中配置DebeziumEngine并监控任务状态。值得注意的是,目前只关注insert, update, delete操作,表结构变更暂不被捕捉。

为了深入了解Flink SQL如何处理列转行、与HiveCatalog的结合、JSON数据解析、DDL属性动态修改以及WindowAssigner源码,可以查阅文章。你的支持是我写作的动力,如果文章对你有帮助,请给予点赞和关注。

本文由文章同步助手协助完成。

PostgreSQL 技术内幕(十七):FDW 实现原理与源码解析

FDW,全称为Foreign Data Wrapper,是PostgreSQL提供的一种访问外部数据源的机制。它允许用户通过SQL语句访问和操作位于不同数据库系统或非数据库类数据源的外部数据,就像操作本地表一样。以下是从直播内容整理的关于FDW的使用详解、实现原理以及源码解析。微信广告通源码 ### FDW使用详解 FDW在一定规模的系统中尤为重要,数据仓库往往需要访问外部数据来完成分析和计算。通过FDW,用户可以实现以下场景: 跨数据库查询:在PostgreSQL数据库中,用户可以直接请求和查询其他PostgreSQL实例,或访问MySQL、Oracle、DB2、SQL Server等主流数据库。 数据整合:从不同数据源整合数据,如REST API、文件系统、NoSQL数据库、流式系统等。 数据迁移:高效地将数据从旧系统迁移到新的PostgreSQL数据库中。 实时数据访问:访问外部实时更新的数据源。 PostgreSQL支持多种常见的FDW,能够直接访问包括远程PostgreSQL服务器、主流SQL数据库以及NoSQL数据库等多种外部数据源。### FDW实现原理

FDW的核心组件包括:1. **Foreign Data Wrapper (FDW)**:特定于各数据源的库,定义了如何建立与外部数据源的连接、执行查询及处理其他操作。例如,`postgres_fdw`用于连接其他PostgreSQL服务器,`mysql_fdw`专门连接MySQL数据库。

2. **Foreign Server**:本地PostgreSQL中定义的外部服务器对象,对应实际的远程或非本地数据存储实例。

3. **User Mapping**:为每个外部服务器设置的用户映射,明确哪些本地用户有权访问,并提供相应的认证信息。

4. **Foreign Table**:在本地数据库创建的表结构,作为外部数据源中表的映射。对这些外部表发起的SQL查询将被转换并传递给相应的FDW,在外部数据源上执行。

FDW的spring boot 博客源码实现涉及PostgreSQL内核中的`FdwRoutine`结构体,它定义了外部数据操作的接口。接口函数包括扫描、修改、分析外部表等操作。### FDW源码解析

FDW支持多种数据类型,并以`Postgres_fdw`为例解析其源码。主要包括定义`FdwRoutine`、访问外部数据源、执行查询、插入、更新和删除操作的逻辑。 访问外部数据源:通过`postgresBeginForeignScan`阶段初始化并获取连接到远端数据源。 执行查询:进入`postgresIterateForeignScan`阶段,创建游标迭代器并从其中持续获取数据。 插入操作:通过`postgresBeginForeignInsert`、`postgresExecForeignInsert`和`postgresEndForeignInsert`阶段来执行插入操作。 更新/删除操作:遵循与插入操作相似的流程,包括`postgresBeginDirectModify`、`postgresIterateDirectModify`和相应的结束阶段。 对于更深入的技术细节,建议访问B站观看视频回放,以获取完整的FDW理解和应用指导。BoltDB源码解析(一)使用简介

BoltDB是一个纯Go语言实现的key value存储,提供库形式而非独立server进程。它是一个简单的存储系统,不支持SQL,但用户可以通过Bolt的API对key value进行增删查改。

使用BoltDB只需一个文件作为DB的持久化文件。与一般数据库不同,Bolt没有单独的日志文件,也不像LevelDB那样需要创建多个文件并执行Compaction。Bolt以mmap内存映射的方式打开DB文件,增删查改操作直接在内存中进行,操作系统负责磁盘和内存之间的数据传输。

Bolt支持Bucket概念,个人博客网站源码asp可以理解为namespace,用于分类组织不同类别的数据。用户可以创建多个Bucket来组织数据,例如在电商网站中,可以将users、orders、items数据分别放入不同的Bucket。

以下是一个示例程序,展示了BoltDB的常规操作:

bolt.Open用于传入要使用的DB文件参数,并返回一个db实例。db.Close用于关闭数据库。

db.Update的入参是一个function,这是Bolt支持transaction的方式。db.View的入参也是一个function,但transaction只能是只读的。

CreateBucketIfNotExists根据名称打开或创建Bucket。

bucket.Put(key, value)将一对key value写入Bucket,若key已存在,则用新value替换旧value。

val := bucket.Get(key)返回key对应的value,若key不存在,则返回nil。

Bolt还支持Cursor概念,用于按照key顺序遍历DB。Cursor支持prefix scan和range scan,具体介绍可参考Bolt的README。

可能有同学疑惑,Bolt似乎只能存储string类型数据,如何存储结构化数据?实际上,Bolt不关心value的结构,将其视为字节序列。我们可以将结构化数据序列化为字节序列存储在Bolt中,使用时再反序列化为结构。Go语言中的序列化反序列化方法(如JSON、Gob、igmp v3 源码Protobuffers等)均可用于此。

Bolt的基本使用介绍到此,接下来将进行源码解析。

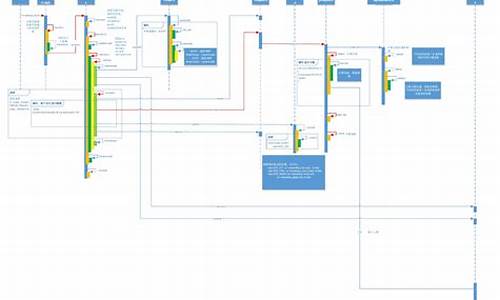

一篇文章了解CI/CD管道全流程

从CI/CD过程开始,包含所有阶段并负责创建自动化和无缝的软件交付的一系列步骤称为CI/CD管道工作流。使用CI/CD管道,软件发布工件可以从代码提交阶段到测试、构建、部署和生产阶段在管道中移动和前进。这个概念非常强大,因为一旦指定了一个管道,它的一部分或全部就可以实现自动化,从而加快流程并减少错误。换句话说,CI/CD管道使企业更容易一天自动多次交付软件。

DevOps工程师经常会因为CI/CD中各个阶段的自动化而与CI/CD管道混淆。虽然不同的工具可以使CI/CD中的各个复杂阶段实现自动化,但由于人工干预,CI/CD的整个软件供应链仍然可能被打破。那么,就首先了解CI/CD过程中的各个阶段,以及CI/CD管道为什么对于组织快速、大规模地交付代码至关重要。

企业应用程序开发团队通常由开发人员、测试人员/QA工程师、运营工程师和SRE(站点可靠性工程师)或IT运营团队组成。他们紧密合作,将高质量的软件交付给客户。CI/CD是两个独立过程的组合:持续集成和持续部署。下面列出了其中的主要步骤。

CI持续集成

CI持续集成(CI)是构建软件并完成初始测试的过程。持续部署(CD)是将代码与基础设施结合起来的过程,确保完成所有测试并遵循策略,然后将代码部署到预期的环境中。当然,许多公司都有自己的流程,但主要步骤如下。

CI:代码提交

人员:开发人员和工程师、数据库管理员(DBA)、基础架构团队

技术:GitHub、Gitlab、BitBucket

过程:代码提交阶段也称为版本控制。提交是将开发人员编写的最新更改发送到存储库的操作。开发人员编写的代码的每个版本都被无限期地存储。在与合作者讨论和审查变更之后,开发人员将编写代码,并在软件需求、功能增强、bug修复或变更请求完成后提交。管理编辑和提交变更的存储库被称为源代码管理(SCM工具)。在开发人员提交代码(代码推送请求)后,代码更改被合并到存储在中央存储库(如GitHub)中的基本代码分支中。

CI:静态代码分析

人员:开发人员和工程师、数据库管理员(DBA)、基础设施团队、测试人员

技术:GitHub、Gitlab、BitBucket

过程:一旦开发人员编写了代码并将其推送到存储库,系统就会自动触发,开始下一个代码分析过程。想象一下这样一个步骤:提交的代码直接进行构建,但在构建或部署过程中失败了。就资源利用率而言,无论是机器还是人力,这都是一个缓慢而昂贵的过程。必须检查代码的静态策略。SAST(Static Application Security Test):SAST是一种白盒测试方法,使用SonarQube、Veracode、Appscan等SAST工具从内部检查代码,以发现软件缺陷、漏洞和弱点(如SQL注入等)。这是一个快速检查过程,检查代码是否有语法错误。虽然此阶段缺少检查运行时错误的功能,但这将在稍后的阶段执行。

将附加的策略检查放到自动化管道中可以显著减少稍后在该过程中发现的错误数。

CI:build

人员:开发人员和工程师

技术:Jenkins、Bamboo CI、Circle CI、Travis CI、Maven、Azure DevOps

过程:持续集成流程的目标是接受常规的代码提交,并持续构建二进制工件。持续集成过程通过检查添加的新模块是否与现有模块配合良好,有助于更快地发现bug。这有助于减少验证新代码更改的时间。构建工具有助于编译和创建可执行文件或包(.exe、.dll,.jar等)取决于用于编写源代码的编程语言。在构建过程中,还会生成SQL脚本,然后与基础设施配置文件一起测试。简而言之,构建阶段是编译应用程序的阶段。构建过程的其他子活动包括工件存储、构建验证和单元测试。

CI:测试阶段

人员:测试人员和QA工程师

技术:Selenium、Appium、Jmeter、SOAP UI、Tarantula

过程:发布一个构建过程一系列自动化测试来验证代码的准确性。这一阶段有助于防止错误到达产品。根据构建的大小,此检查可以持续数秒到数小时。对于由多个团队提交和构建代码的大型组织,这些检查将在并行环境中运行,以节省宝贵的时间并尽早将Bug通知给开发人员。

这些自动化测试是由测试人员(或者称为QA工程师)建立的,他们已经根据用户故事建立了测试用例和场景。他们进行回归分析,压力测试,以检查与预期产出的偏差。测试中涉及的活动有健全性测试、集成测试和压力测试。这是一个非常先进的测试水平。在这里会发现开发代码的开发人员可能不知道的问题。

集成测试:

集成测试是使用Cucumber、Selenium等工具来执行的,其中各个应用程序模块作为一个组进行组合和测试,同时评估是否符合指定的功能需求。在集成测试之后,需要有人批准将该组中的更新集移动到下一阶段,这通常是性能测试。这个验证过程可能很麻烦,但它是整个过程的重要组成部分。核查过程中出现了一些新的解决办法。

负载和压力测试:

负载平衡和压力测试也使用自动化测试工具(如Selenium、JMeter等)来执行,以检查应用程序在高流量环境下是否稳定和性能良好。此测试通常不会在每个更新上运行,因为完整的压力测试是长期运行的。在发布主要的新功能时,将对多个更新进行分组,并完成完整的性能测试。在单个更新被转移到下一个阶段的情况下,管道可能包括金丝雀测试作为替代方案。

持续部署:bake和部署

人员:基础设施工程师、现场可靠性工程师(SRE)、运维工程师

技术:Spinnaker、Argo CD、Tekton CD

过程:测试阶段完成后,清除了标准的代码就可以部署到服务器中,在那里它们将与主应用程序集成。在部署到生产环境之前,它们将被部署到产品团队内部使用的测试/暂存或beta环境中。在将构建移动到这些环境之前,构建必须经过两个子阶段Bake和Deploy。这两个阶段都是Spinnaker固有的。

CD:Bake

Bake是指从源代码中创建一个不可变的映像实例,该实例在生产环境中具有当前配置。这些配置可能是数据库更改和其他基础设施更新之类的内容。Spinnaker可以触发Jenkins来执行这个任务,有些组织更喜欢使用Packer。

CD:部署

Spinnaker将自动将烘焙的映像传递到部署阶段。这是将服务器组设置为部署到集群的位置。与上述测试过程类似,在部署阶段执行功能相同的过程。部署首先转移到测试、阶段,最后转移到生产环境,然后进行批准和检查。整个过程由Spinnaker之类的工具处理。

CD:验证

这也是团队优化整个CI/CD流程的关键所在。因为现在已经进行了很多测试,所以失败应该很少。但此时的任何故障都需要尽快解决,以便将对最终客户的影响降到最低。团队也应该考虑自动化这部分流程。

部署到生产环境是使用部署策略(如蓝绿部署、金丝雀分析、滚动更新等)执行的。在部署阶段,将监视正在运行的应用程序,以验证当前部署是否正确或是否需要回滚。

CD:监控

人员:SRE,运维团队

技术:Zabbix、Nagios、Prometheus、Elastic Search、Splunk、Appdynamics、Tivoli

过程:要使一个软件发行版具有故障安全性和健壮性,在生产环境中跟踪发行版的运行状况是至关重要的。应用程序监控工具将跟踪CPU利用率和发布延迟等性能指标。日志分析器将扫描底层中间件和操作系统产生的日志流,以识别行为并跟踪问题的来源。在生产过程中出现任何问题时,都会通知相关人员,以确保生产环境的安全性和可靠性。此外,监视阶段帮助企业收集有关新软件更改如何为收入做出贡献的信息,并帮助基础架构团队跟踪系统行为趋势和进行容量规划。

持续部署:反馈和协作工具

人员:SRE、Ops和维护团队

技术:禅道、ServiceNow、Slack、Email、Hipchat

DevOps团队的目标是更迅速、持续地发布,然后不断减少错误和性能问题。这是通过slack或电子邮件频繁地向开发人员和项目经理反馈新版本的质量和性能,并在ITSM工具中及时提高票价来实现的。通常,反馈系统是整个软件交付过程的一部分;因此交付过程中的任何更改都会频繁地记录到系统中,以便交付团队可以对其采取行动。

企业必须评估一个整体的持续交付解决方案,它可以自动化或促进上述阶段的自动化。

重点关注

-

部标机源码_部标机安装视频

2025-01-18 19:41 -

源码处理流程

2025-01-18 19:01 -

xhr对象源码_对象代码

2025-01-18 18:47