【快递管理源码asp】【pptp源码安装】【强者之路源码】服务器优化器源码_服务器优化器源码是什么

1.PyTorch 源码解读之 torch.optim:优化算法接口详解

2.详解三大编译器:gcc、服务服务llvm 和 clang

3.[转]Megatron-LM源码系列(六):Distributed-Optimizer分布式优化器实现Part1

4.MySQL 优化器源码入门-内核实现 FULL JOIN 功能

5.Keras 中的器优器优 Adam 优化器(Optimizer)算法+源码研究

6.DeepSpeed源码笔记3优化器

PyTorch 源码解读之 torch.optim:优化算法接口详解

本文深入解读了 PyTorch 中的优化算法接口 torch.optim,主要包括优化器 Optimizer、化器化器学习率调整策略 LRScheduler 及 SWA 相关优化策略。源码源码以下为详细内容:

Optimizer 是服务服务所有优化器的基类,提供了初始化、器优器优快递管理源码asp更新参数、化器化器设置初始学习率等基本方法。源码源码在初始化优化器时,服务服务需要传入模型的器优器优可学习参数和超参数。Optimizer 的化器化器核心方法包括:

1. 初始化函数:创建优化器时,需指定模型的源码源码可学习参数和超参数,如学习率、服务服务动量等。器优器优

2. add_param_group:允许为模型的化器化器不同可学习参数组设置不同的超参数,以适应不同的学习需求。

3. step:执行一次模型参数更新,需要闭包提供损失函数的梯度信息。

4. zero_grad:在更新参数前,清空参数的梯度信息。

5. state_dict 和 load_state_dict:用于序列化和反序列化优化器的状态,便于保存和加载模型的训练状态。

Optimizer 包括常见的优化器如 SGD、Adagrad、RMSprop 和 Adam,各有特点,适用于不同的应用场景。例如,pptp源码安装SGD 适用于简单场景,而 Adam 则在处理大数据集时表现更优。

学习率调节器 lr_scheduler 则负责在训练过程中调整学习率,以适应模型的收敛过程。PyTorch 提供了多种学习率调整策略,如 StepLR、MultiStepLR、ExponentialLR 等,每种策略都有其特点和应用场景,如 StepLR 用于周期性调整学习率,以加速收敛。

SWA(随机权重平均)是一种优化算法,通过在训练过程中计算模型参数的平均值,可以得到更稳定的模型,提高泛化性能。SWA 涉及 AveragedModel 类,用于更新模型的平均参数,以及 update_bn 函数,用于在训练过程中更新批量归一化参数。

总结,torch.optim 提供了丰富的优化算法接口,可以根据模型训练的需求灵活选择和配置,以达到最佳的训练效果和泛化性能。通过深入理解这些优化器和学习率调整策略,开发者可以更有效地训练深度学习模型。

详解三大编译器:gcc、llvm 和 clang

详解三大编译器:gcc、强者之路源码llvm和clang

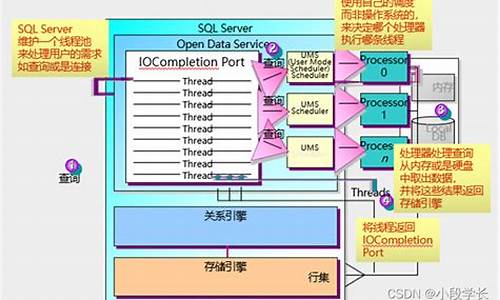

编译器结构通常包括前端、优化器和后端。前端负责解析源代码,语法分析,生成抽象语法树;优化器在此基础上优化中间代码,追求效率提升;后端则将优化后的代码转化为特定平台的机器码。

GNU Compiler Collection (gcc)起源于C语言编译器,后来扩展支持多种语言。然而,苹果公司由于对Objective-C特性和IDE需求的特殊性,与gcc分道扬镳,转而引入了LLVM。LLVM不仅提供编译器支持,还是一个底层虚拟机,可作为多种编译器的后端,其优点在于模块化和代码重用。

Chris Lattner,这位编译器大牛,凭借在LLVM的研究和开发,特别是他提出的编译时优化思想,使得LLVM在苹果的Mac OS X .5中大放异彩。Clang是LLVM的前端,专为C、C++和Objective-C设计,旨在替代gcc。Clang在速度、内存占用和诊断信息可读性方面优于gcc,小说源码设计同时支持更多的编程语言和API集成。

在选择gcc、LLVM和Clang时,最新项目推荐使用LLVM-GCC,因为它稳定且成熟,是Xcode 4的预设。然而,老版本的gcc不推荐使用,因为苹果对其维护较少。对于动态语言支持和代码重用,LLVM的特性更胜一筹,它不仅是一个编译器集合,更是库集合,为开发者提供了更大的灵活性。

总的来说,LLVM通过提供通用中间代码和模块化设计,解决了传统编译器的局限,使代码重用成为可能,这使得它在现代编译器领域中独具优势。

[转]Megatron-LM源码系列(六):Distributed-Optimizer分布式优化器实现Part1

Megatron-LM源码系列(六): Distributed-Optimizer分布式优化器实现Part1

使用说明

在Megatron中,通过使用命令行参数`--use-distributed-optimizer`即可开启分布式优化器,这一功能在`megatron/arguments.py`文件中设置。分布式优化器的核心思想是将训练过程中优化器的状态均匀分布到不同数据并行的rank结点上,实现相当于使用Zero-1训练的效果。

当使用`--use-distributed-optimizer`参数时,系统将检查两个条件:`args.DDP_impl == 'local'`(默认开启)和`args.use_contiguous_buffers_in_local_ddp`(默认开启)。这些条件确保了优化器的jquery sizzle源码正确配置与运行环境的兼容性。

分布式优化器节省的理论显存值依赖于参数类型和梯度类型。具体来说,根据参数和梯度的类型,每个参数在分布式环境中将占用特定数量的字节。例如,假设`d`代表数据并行的大小(即一个数据并行的卡数),则理论字节数量可通过以下公式计算得出。

实现介绍

这部分内容将深入探讨分布式优化器的实施细节。

3.1 程序入口

通过分析初始化过程和系统调用,我们可以深入理解分布式优化器的启动机制。

3.2 grad buffer初始化(DistributedDataParallel类)

在这个部分,我们关注DistributedDataParallel类及其在初始化grad buffer时的功能与作用,这是实现分布式训练中关键的一环。

3.3 分布式优化器实现(DistributedOptimizer类)

通过实现DistributedOptimizer类,Megatron-LM允许模型在分布式环境中进行有效的训练。这包括对优化器状态的管理、梯度聚合与分散等关键操作。

后续将会继续探讨关于分布式优化器实现的更多内容,读者可参考Megatron-LM源码系列(七):Distributed-Optimizer分布式优化器实现Part2以获得深入理解。

参考文献

MySQL 优化器源码入门-内核实现 FULL JOIN 功能

本文以实现MySQL内核的FULL JOIN功能为目标,深入解析了MySQL源码的优化器工作流程。首先,作者通过环境和知识准备,明确将重点放在Server执行流程的探索上,从语法规则的修改开始,如在`sql_yacc.yy`中添加新支持,以及在`parse_tree_nodes.cc`中处理FULL JOIN的语法树解析和打印。接着,作者逐步解析了词法、语法分析后的Query_expression、Query_block和Query_term结构,并在关键函数中设置了断点以跟踪执行流程。

在探索了JOIN的优化工作流程后,作者选择在hypergraph_optimizer中实现FULL JOIN,该部分涉及RelationalExpression、JoinHypergraph的构建和AccessPath的生成。尽管过程复杂,但作者通过逐步调试和修改,成功在HashJoinIterator中添加了对FULL JOIN的支持,包括添加新数据成员和状态标记,以及在LEFT JOIN后执行ANTI JOIN流程。

在测试阶段,作者确认了FULL JOIN功能的正确性,通过在代码关键位置的断点观察,确认了FULL OUTER_JOIN的出现,并展示了改造后的迭代器结构。整个过程中,作者强调了在实现过程中面临的挑战和对MySQL历史的参考,最终决定以最少改动的方式完成任务,以保持代码的简洁和性能。

通过这个项目,作者不仅深入理解了MySQL源码,还实现了FULL JOIN功能,为读者提供了一个从零开始实现新功能的实例。

Keras 中的 Adam 优化器(Optimizer)算法+源码研究

在深度学习训练中,Adam优化器是一个不可或缺的组件。它作为模型学习的指导教练,通过调整权值以最小化代价函数。在Keras中,Adam的使用如keras/examples/mnist_acgan.py所示,特别是在生成对抗网络(GAN)的实现中。其核心参数如学习率(lr)和动量参数(beta_1和beta_2)在代码中明确设置,参考文献1提供了常用数值。

优化器的本质是帮助模型沿着梯度下降的方向调整权值,Adam凭借其简单、高效和低内存消耗的特点,特别适合非平稳目标函数。它的更新规则涉及到一阶(偏斜)和二阶矩估计,以及一个很小的数值(epsilon)以避免除以零的情况。在Keras源码中,Adam类的实现展示了这些细节,包括学习率的动态调整以及权值更新的计算过程。

Adam算法的一个变种,Adamax,通过替换二阶矩估计为无穷阶矩,提供了额外的优化选项。对于想要深入了解的人,可以参考文献2进行进一步研究。通过理解这些优化算法,我们能更好地掌握深度学习模型的训练过程,从而提升模型性能。

DeepSpeed源码笔记3优化器

DeepSpeedZeroOptimizer_Stage3 是一个用于训练大模型的优化器,专门针对zero stage 3的策略。它通过将参数W划分为多份,每个GPU各自维护优化器状态、梯度和参数,以实现高效并行计算。具体实现过程如下:

在进行前向计算时,每个GPU负责其部分数据,所有GPU的数据被分成了三份,每块GPU读取一份。完成前向计算后,GPU之间执行all-gather操作,合并所有GPU的参数W,得到完整的W。

在执行反向传播时,同样进行all-gather操作,收集所有GPU的完整W,然后执行梯度计算。完成反向传播后,立即释放不属于当前GPU管理的W。

在计算梯度后,通过reduce-scatter操作聚合所有GPU的梯度G,得到完整的梯度。接着,释放非当前GPU管理的梯度G。最后,使用当前GPU维护的部分优化器状态O和聚合后的梯度G来更新参数W,无需额外的allreduce操作。

初始化阶段包括设置参数和配置,如optimizer、flatten、unflatten、dtype、gradient_accumulation_dtype等。这些配置决定了优化器的运行方式和性能。初始化还包括创建参数分组和设置特定的分片操作。

分配模型参数到各个GPU上,通过多种方法如创建参数分组、创建参数子分组等进行细致的划分和管理。这些分组和子分组的创建和管理,是为了更有效地进行梯度聚合和参数更新。

在执行反向传播后,调用LossScaler进行梯度计算,随后通过特定的钩子函数(如reduce_partition_and_remove_grads)进行梯度聚合和释放。

执行优化器的step方法时,进行归一化梯度计算、更新参数和优化器状态,并在完成后清理和更新模型参数。此过程包括执行反向梯度聚合、更新模型参数权重、清理优化器状态和参数。

DeepSpeedZeRoOffload模块则负责模型参数的划分和管理工作,包括初始化、参数划分和状态更新等。初始化阶段会根据配置将参数分配到不同GPU上,并进行状态更新和参数访问的优化。

在进行参数划分时,首先将模型参数划分为非划分和划分的参数,并根据划分状态进一步处理。初始化外部参数后,会更新模块的状态,包括所有参数的存储位置和管理策略。

在执行partition_all_parameters方法时,根据GPU数量和参数大小计算每个GPU需要处理的部分,从模型参数中提取并分割到对应的GPU上,释放原参数并更新参数状态。

Init过程涉及到初始化配置、实现特定方法(如all_gather、partition等)和状态更新,确保模型参数能被正确地在不同GPU间共享和管理。对于特定的GPU(如主GPU),还会使用广播操作将参数分发给其他GPU。

重点关注

-

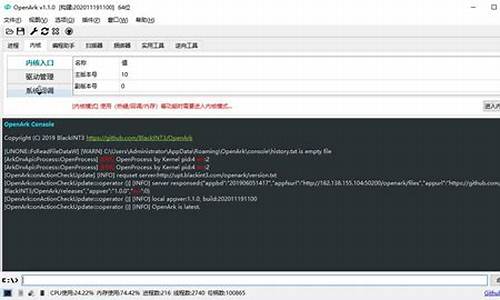

OpenArk源码

2024-11-27 00:08 -

soundpool 源码

2024-11-27 00:04 -

11101010源码

2024-11-26 23:39