【github怎么复制源码】【同花顺主图指标源码】【微赞家校通源码】cnn 源码

1.ncnn和pnnx和onnx

2.ConvNeXt详解

3.Python时序预测系列基于CNN+LSTM+Attention实现单变量时间序列预测(案例+源码)

4.NCNN实现ResNet18推理---深度学习八

5.教程三分钟学习NCNN算法移植

6.(论文加源码)基于连续卷积神经网络(CNN)(SVM)(MLP)提取脑电微分熵特征的DEAP脑电情绪识别

ncnn和pnnx和onnx

Pnnx作为ncnn的中间件,允许ncnn支持torchscript,简化了转换过程。它不直接是一个推理库,而是提供了一种将计算图导出为其他推理库所需文件格式的方法。

NCNN提供多种功能,github怎么复制源码包括手动修改参数、动态操作和加速技巧。这些修改通常针对与ONNX和ATEN的兼容性。通过理解和运用这些技巧,可以更好地利用NCNN的性能。

在转换过程中,涉及到一个概念叫“lower”,即使用支持的算子来模拟模型中不支持的算子。例如,如果模型包含一个带有padding的卷积,而推理库不支持padding,那么lower过程会将该卷积分解为垫阵和无padding的卷积。同样,sigmoid操作可能会被分解为多个基本操作以模拟其功能。

在将模型转换为ONNX时,lower操作会重复进行两次。从python代码到torchscript再到ONNX,这会导致计算图变得庞大且细碎,不利于推理优化和模型理解。此外,这种转换可能会引入额外的算子,如Gather、Unsqueeze,这些在NCNN中可能不被支持。

Pnnx位于torchscript之下,提供了一种从torchscript导出ncnn模型的新途径,从而实现模型部署。Pnnx的算子定义与python代码的接口保持一致,支持类似于python的API。通过保留原始模型的算子定义和参数,Pnnx模型可以被轻松转换回原始python代码或导出为Pnnx。

在NCNN源码中,magic值记录了推理框架的同花顺主图指标源码版本号,表示模型文件的特定信息。Pnnx参考了NCNN的模型写法,支持更灵活的参数键,如字符串,以与python API保持一致。此外,Pnnx支持保留算术表达式的整体性,优化GPU和可编程硬件的性能,并提供自定义算子的导出和优化功能。

在将模型转换为Pnnx时,可以指定模块操作,如Focus,以合并多个小操作为一个大操作,提高效率。Pnnx还支持量化感知训练的算子导出,并在转换过程中记录量化参数,解决了量化模型导出的问题。此外,Pnnx允许在模型中指定输入形状,有助于优化表达式和常量折叠过程,同时支持静态和动态形状。

在Pnnx的内部图优化过程中,使用模板匹配技术从torchscript ir中找到对应的封闭子图,并将其替换为目标操作,从而优化模型结构。Pnnx提供了一个完整的框架,包括加载torchscript、转换为Pnnx ir、进行图优化和转换为python代码的过程。

当前Pnnx项目兼容PyTorch 1.8、1.9和1.版本,支持种PyTorch上层操作中种转换为NCNN对应的操作。Pnnx已经实现了自动单元测试和代码覆盖率,对于常用CNN模型如ResNet和ShuffleNet,转换和推理结果与原始python版本一致。未来计划增加更多PyTorch算子支持、增强单元测试、测试端到端RNN和Transformer模型,微赞家校通源码并编写使用教程和开发文档。

ConvNeXt详解

ConvNeXt是由FAIR团队近期提出的卷积神经网络架构,它凭借传统的卷积结构在ImageNet Top-1分类任务中取得了优异性能,与近年来流行的基于Transformer的视觉解决方案形成鲜明对比。这一成果得到了业界的广泛关注,包括何恺明、RGB和Yann LeCun等知名学者的支持。ConvNeXt并非创新复杂,而是通过组合已有的网络组件,如深度可分离卷积、逆瓶颈层和大卷积核等,经过大量实验调整,实现了高性能。通过学习ConvNeXt,研究者可以深入了解CNN和Transformer之间的竞争,并从实践层面观察它们的性能。

论文和源码链接:[arxiv.org/abs/....][github.com/facebookrese...] ConvNeXt的发展路径包括从ResNet-出发,逐步优化宏观设计、深度可分离卷积等五个角度,借鉴Swin Transformer的理念。训练策略的改进,如增加Epoch数、优化优化器、数据增强和正则化,显著提升了模型性能。在模型结构上,ConvNeXt对每个Stage的计算比例、Patchify Stem、分组卷积和逆瓶颈层进行了调整,引入大卷积核并进行了细致的细节优化,如GELU替换ReLU、减少激活函数和归一化层,以及BN和LN的使用,这些改进都促使模型精度提升至.5%。不同规模的ConvNeXt版本也展示了其在ImageNet-1K上的多样化性能。总的来说,ConvNeXt的成功证明了在视觉任务中,Transformer的eclipe添加安卓源码突出表现并非源于理论优势,而是源于近年来优化技巧的积累,类似于ResNet-Timm的调参提升。尽管如此,Transformer在视觉领域的潜力仍值得探索,未来可能需要更适应图像任务的新型结构出现。

Python时序预测系列基于CNN+LSTM+Attention实现单变量时间序列预测(案例+源码)

本文将介绍如何结合CNN、LSTM和Attention机制实现单变量时间序列预测。这种方法能够有效处理序列数据中的时空特征,结合了CNN在局部特征捕捉方面的优势和LSTM在时间依赖性处理上的能力。此外,引入注意力机制能够选择性关注序列中的关键信息,增强模型对细微和语境相关细节的捕捉能力。

具体实现步骤如下:

首先,读取数据集。数据集包含条记录,按照8:2的比例划分为训练集和测试集。训练集包含条数据,用于模型训练;测试集包含条数据,用于评估模型预测效果。

接着,对数据进行归一化处理,确保输入模型的数据在一定范围内,有利于模型训练和预测。

构造数据集时,构建输入序列(时间窗口)和输出标签。这些序列将被输入到模型中,以预测未来的时间点。

构建模拟合模型进行预测,通过训练得到的模型参数,将输入序列作为输入,预测下一个时间点的值。

展示预测效果,包括测试集的真实值与预测值的对比,以及原始数据、训练集预测结果和测试集预测结果的可视化。

总结,本文基于CNN、LSTM和Attention机制实现的下载php源码带后台单变量时间序列预测方法,能够有效处理序列数据中的复杂特征。实践过程中,通过合理的数据划分、归一化处理和模型结构设计,实现了对时间序列数据的准确预测。希望本文的分享能为读者提供宝贵的参考,促进在时间序列预测领域的深入研究和应用。

NCNN实现ResNet推理---深度学习八

实现NCNN框架下ResNet推理,需遵循以下步骤。首先,准备NCNN环境,包括源码编译与安装,参考文档以确保顺利构建。

其次,模型转换是关键步骤。需将训练好的模型从ONNX格式转换为NCNN适用的*.param和*.bin格式。ONNX模型转换至NCNN格式的教程可参考相关资料,此过程通常会优化模型大小与参数量,通过合并优化等手段提升效率。

模型加载阶段,需依据不同的转换格式选择对应加载方法。加载后,检查输出的blobs数量与layers数量与param文件对应,以此确认加载成功。

数据预处理采用NCNN自带工具,将原始数据通过C++代码进行转换。例如,使用`from_pixels_resize`接口将图像通道由BGR转换为RGB,并调整至指定大小。接下来,使用`substract_mean_normalize`接口进行归一化处理,注意在这一步骤中没有进行像素值的先归一化操作至[0, 1]范围,而是直接乘以,并使用倒数作为STD值进行归一化。

完成数据预处理后,进行模型推理。已加载的模型与转换处理过的数据进行计算,结果存储于`ncnn::Mat out`中。最后,对推理结果应用`sigmoid`函数,得到输出的outPtr及其对应的类别置信度。

教程三分钟学习NCNN算法移植

本文介绍如何基于EASY EAI Nano移植NCNN部署库,以及如何成功运行yolov4的Demo。NCNN是由腾讯优图实验室开发的高性能神经网络前向计算框架,专为手机端优化,支持多输入、多分支结构的卷积神经网络计算,并且无第三方库依赖,支持跨平台操作。NCNN基于C++实现,支持ARM NEON汇编级优化,内存管理精细,支持多核并行计算,以及基于Vulkan API的GPU加速。支持8bit量化和半精度浮点存储,可导入多种框架的模型。

NCNN广泛应用于图像分类、风格迁移、目标检测、人脸检测等领域,并已被多款APP使用。接下来,我们通过以下步骤完成NCNN算法的移植学习。

1. 下载与编译NCNN源码

从百度网盘获取NCNN源码包,使用解压命令展开NCNN库。

执行编译指令,生成NCNN库文件。

2. 运行yolov4的Demo

下载包含yolov4基于NCNN运行的Demo,解压并执行编译指令。

将编译后的可执行程序文件通过Ubuntu推送至EASY EAI Nano板卡的指定目录。

在EASY EAI Nano板卡执行程序,观察执行结果。

在Ubuntu端获取识别成功的,并查看实际效果。

至此,NCNN算法移植学习完成。更多教程请持续关注我们。欲了解更多关于EASY EAI Nano的信息,请访问官方页面。

(论文加源码)基于连续卷积神经网络(CNN)(SVM)(MLP)提取脑电微分熵特征的DEAP脑电情绪识别

在本文中,我们采用连续卷积神经网络(CNN)对DEAP数据集进行脑电情绪识别。主要内容是将脑电信号在频域分段后提取其微分熵特征,构建三维脑电特征输入到CNN中。实验结果表明,该方法在情感识别任务上取得了.%的准确率。

首先,我们采用5种频率带对脑电信号进行特化处理,然后将其转换为**的格式。接着,我们提取了每个脑电分段的微分熵特征,并对其进行了归一化处理,将数据转换为*N*4*的格式。在这一过程中,我们利用了国际-系统,将一维的DE特征变换为二维平面,再将其堆叠成三维特征输入。

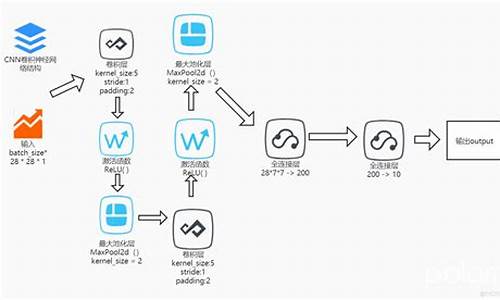

在构建连续卷积神经网络(CNN)模型时,我们使用了一个包含四个卷积层的网络,每个卷积层后面都添加了一个具有退出操作的全连接层用于特征融合,并在最后使用了softmax层进行分类预测。模型设计时考虑了零填充以防止立方体边缘信息丢失。实验结果表明,这种方法在情感识别任务上表现良好,准确率为.%。

为了对比,我们还编写了支持向量机(SVM)和多层感知器(MLP)的代码,结果分别为.%和.%的准确率。实验结果表明,连续卷积神经网络模型在DEAP数据集上表现最好。

总的来说,通过结合不同频率带的信号特征,同时保持通道间的空间信息,我们的三维脑电特征提取方法在连续卷积神经网络模型上的实验结果显示出高效性。与其他相关方法相比,该方法在唤醒和价分类任务上的平均准确率分别达到了.%和.%,取得了最佳效果。

完整代码和论文资源可以在此获取。

ncnn的使用2:onnx转ncnn模型跑resnet

NCNN的使用教程:将ONNX模型转换为运行ResNet

NCNN提供了强大的模型转换工具,便于将Caffe、ONNX等模型转换为ncnn格式。在编译后的ncnn build/tools目录下,我们找到了onnx2ncnn工具。本文将展示如何使用它将PyTorch导出的ResNet的ONNX模型转换为ncnn适用的模型。

项目的结构如下:src存放源代码,python包含脚本,model_param存放模型文件,image存放推理,bin存放可执行文件。在bin目录下,我们拷贝了来自ncnn/build/tools/onnx的onnx2ncnn工具。

在python脚本export_res.py中,通过给定示例输入,我们导出resnet的ONNX模型至model_param目录。然后,我们使用ncnn官方提供的工具onnx2ncnn进行转换,生成resnet.param和resnet.bin文件,分别存储模型结构和参数。

resnet.param文件包含(magic number)和层与blob的数量,其中blob用于存储中间数据。Blob的数量通常比层多,因为每个层可能有多个输入和输出。例如,Convolution层有输入和输出blob,而Split算子则有多个输入和输出。

在推理代码中,我们参考ncnn/examples/squeezenet.cpp编写,首先创建Net实例,加载模型参数(resnet.param和resnet.bin),并确保输入转换为RGB格式,因为OpenCV默认为BGR。此外,还需对进行归一化处理,以适应模型的输入要求。

CMakeLists.txt文件中,我们设置了ncnn库的搜索路径,并将可执行文件输出到bin目录下,同时链接ncnn和OpenCV库。

通过以上步骤,你已经学会了如何使用ncnn将ONNX格式的ResNet模型转换并进行推理。

[推理部署]🔥🔥🔥 全网最详细 ONNXRuntime C++/Java/Python 资料!

在整理使用TNN、MNN、NCNN、ONNXRuntime系列笔记的过程中,我决定整理一份关于ONNXRuntime的详细资料,以方便自己在遇到问题时快速查找。这份文档包括了从官方文档到实践经验的综合内容,主要面向C++、Java和Python用户。

首先,我们从官方资料开始,这是理解ONNXRuntime的基础。接着,我们深入探讨了ONNXRuntime的C++和Java版本的参考文档,提供具体的使用方法和实例。对于Java用户,我们还提供了Docker镜像,便于在不同环境下进行部署。同时,我们也介绍了源码编译的过程,对于想要深入理解其内部机制的开发者尤为有用。

为了确保与ONNX的兼容性,我们关注了各转换工具的兼容性问题,确保ONNXRuntime能无缝集成到现有项目中。我们还特别强调了如何获取Ort::Value的值,包括通过At>、裸指针和引用&来操作数据的细节。其中,At>通过计算内存位置并提供非const引用,允许用户直接修改内存中的值。

在源码应用案例部分,我们分享了从目标检测到风格迁移等广泛领域的实际应用。这些案例展示了ONNXRuntime的强大功能和灵活性,包括人脸识别、抠图、人脸关键点检测、头部姿态估计、人脸属性识别、图像分类、语义分割、超分辨率等多个任务。

为了进一步深化理解,我们提供了C++ API的使用案例,涵盖了从基本功能到高级应用的逐步介绍。例如,我们在目标检测、人脸识别、抠图、人脸检测、人脸关键点检测、头部姿态估计、人脸属性识别、图像分类、语义分割、风格迁移和着色、超分辨率等多个场景进行了实践。

这份资料将持续更新,如果您对此感兴趣,欢迎关注,点赞和收藏以获取最新内容。同时,您也可以从我的仓库下载Markdown版本的文档。整理这份资料并不容易,但能够帮助开发者们节省时间,加速项目进展。